El algoritmo de iteración Newton-Schulz es una herramienta matemática fundamental para transformar matrices en formas que facilitan diversos procesos computacionales, especialmente en el campo de la inteligencia artificial y el aprendizaje profundo. Su objetivo principal es la ortogonalización de matrices, es decir, convertir un conjunto de vectores —ya sean filas o columnas de una matriz— en vectores ortonormales. Esto significa que los vectores resultantes no solo son perpendiculares entre sí, sino que también tienen una norma unitaria. La importancia de lograr esta propiedad radica en la estabilidad numérica y la eficiencia en cálculos posteriores, como la optimización de funciones, la reducción de dimensionalidad o la mejora de redes neuronales. El origen de Newton-Schulz se remonta a metodologías matemáticas clásicas que buscaban preservar propiedades estructurales de los datos tras transformaciones complejas.

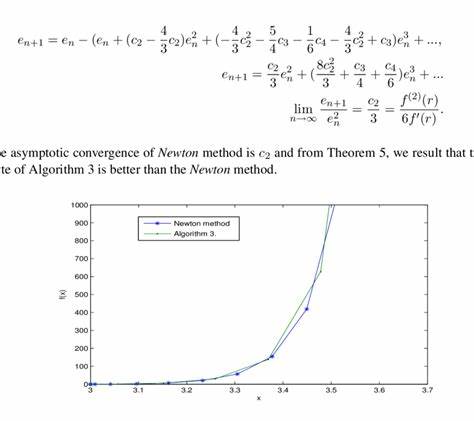

Esta iteración tiene una característica singular: funciona mediante la aplicación sucesiva de polinomios impares en matrices, que exhiben una propiedad muy deseada en álgebra lineal. Cuando una matriz se descompone mediante la descomposición en valores singulares (SVD), los polinomios aplicados actúan directamente sobre los valores singulares, lo que permite controlar cómo estos evolucionan en cada iteración. En términos técnicos, si una matriz M se puede expresar como el producto UΣV^T (donde U y V son matrices ortogonales y Σ es diagonal con los valores singulares), la iteración busca aproximar la transformación que mapea M a la matriz UV^T. Este proceso es análogo a ajustar los valores singulares a uno, a excepción de los valores cero que permanecen inalterados. Así, la iteración Newton-Schulz “corrige” la matriz para que sus vectores ortogonales sean más perfectos con cada paso.

Uno de los enfoques más comunes para implementar esta estrategia consiste en utilizar una iteración basada en un polinomio cúbico específico. Este polinomio se expresa en términos de la matriz como p(X) = (3/2)X - (1/2)XX^T X. Al aplicar repetidamente esta fórmula, la transformación tiende a asemejarse cada vez más a la función signo en el espectro singular, logrando finalmente la ortogonalización deseada. Es vital, sin embargo, asegurar que los valores singulares iniciales estén dentro de un rango controlado, generalmente ajustando la matriz al dividirla entre su norma de Frobenius al comenzar la iteración. Para obtener una convergencia más rápida, investigadores han explorado iteraciones de mayor orden, como las basadas en polinomios quinticos.

Estos polinomios tienen términos hasta el grado cinco, y aunque permiten una aproximación al signo con menos pasos, también introducen ciertas oscilaciones indeseadas alrededor del origen, lo que se traduce en una menor estabilidad si no se manejan adecuadamente. Un desarrollo particularmente fascinante surge en la aplicación práctica del algoritmo en optimizadores de redes neuronales modernas. El Muon Optimizer, utilizado para establecer récords de velocidad en el entrenamiento del NanoGPT, emplea una versión “maldita” del polinomio quintico. Esta variante sacrifica la convergencia garantizada para acelerar la rapidez con que los valores singulares pequeños se inflan, lo que resulta en un entrenamiento significativamente más veloz a costa de perder estabilidad en la iteración. Este es un ejemplo claro de cómo la teoría matemática se adapta a las demandas pragmáticas de la informática avanzada.

Más recientemente, las investigaciones han avanzado hacia iteraciones en las que cada paso utiliza diferentes coeficientes polinómicos, ampliando el espacio de diseño y mejorando la convergencia y estabilidad del método. Un ejemplo destacado es la llamada “iteración de seis pasos” desarrollada por Jiacheng You, que utiliza seis polinomios quinticos distintos en secuencia para equilibrar velocidad y suavidad en la aproximación al signo. Esta técnica no sólo minimiza las oscilaciones, sino que también ofrece una herramienta robusta para la ortogonalización en entornos de aprendizaje automático. Implementar el algoritmo Newton-Schulz en frameworks como JAX permite aprovechar la diferenciabilidad automática y la optimización paralela en GPU, facilitando su integración en pipelines de deep learning. La iteración puede adaptarse automáticamente a la forma de la matriz, normalizándola antes de aplicar los polinomios y transponiendo según sea necesario para potenciar la eficiencia computacional.

La flexibilidad del algoritmo abre la puerta a que los investigadores y desarrolladores puedan diseñar sus propios polinomios según las necesidades específicas de sus aplicaciones. Pueden elegir el orden del polinomio para equilibrar el costo computacional por paso frente a la velocidad total de convergencia, decidir si desean iteraciones convergentes o acelerar la modificación de valores singulares pequeños, y decidir si todos los pasos emplean la misma función o si varían entre pasos para optimizar el rendimiento. Los vínculos históricos del algoritmo Newton-Schulz son amplios y profundos. Esta iteración ha encontrado utilidad en la resolución del problema ortogonal de Procrustes, en la obtención de factores ortogonales en la descomposición polar, y en aplicaciones fundamentales de la química computacional desde la década de 1950 con el trabajo pionero de Per-Olov Löwdin en orbitales atómicos y moleculares. En optimización, también ha sido la base para algoritmos Frank-Wolfe sobre la bola espectral, y ha sido explorada como técnica para mejorar la aproximación de funciones Lipschitz en redes neuronales.

El desarrollo de Newton-Schulz ha sido paralelo a la evolución de la computación y el aprendizaje profundo, haciendo posible no sólo procesos óptimos en entrenamiento, sino también nuevas formas de regularización y diseño de arquitecturas. Su capacidad para mantener propiedades esenciales de las matrices mientras facilita la manipulación algebraica lo convierte en una herramienta imprescindible para profesionales y académicos que buscan un mayor rendimiento y estabilidad en modelos complejos. Con la creciente demanda por modelos más eficientes y robustos, entender y aplicar adecuadamente el algoritmo de iteración Newton-Schulz marcará una diferencia decisiva en el futuro del desarrollo en inteligencia artificial. Su combinación única de rigor matemático y flexibilidad práctica lo posiciona como una técnica indispensable para quienes aspiran a innovar en el mundo de la ciencia de datos y el aprendizaje automático.