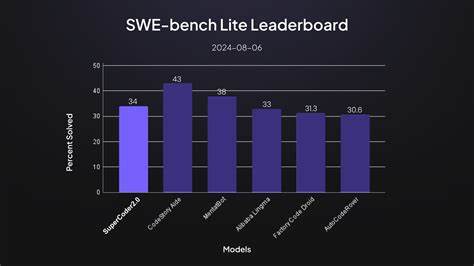

El desarrollo de software ha experimentado una evolución constante a lo largo de las últimas décadas, pero el auge de la inteligencia artificial (IA) ha abierto nuevas puertas para automatizar y optimizar tareas tradicionalmente reservadas para los desarrolladores humanos. En este contexto, el benchmark SWE-bench Lite se erige como una métrica fundamental para evaluar sistemas basados en grandes modelos de lenguaje (LLM) aplicados a problemas reales de programación. Aquí, el agente Refact.ai ha conseguido un logro extraordinario, alcanzando la máxima puntuación con un 59,7% de tareas resueltas de forma totalmente autónoma. Este resultado coloca a Refact.

ai en la cima de la tabla de rendimiento y destaca el potencial de las soluciones de IA open-source para transformar el desarrollo de software. SWE-bench Lite representa un conjunto riguroso de 300 problemas extraídos de incidencias reales en proyectos populares de Python alojados en GitHub. Cada tarea implica la corrección de errores o la implementación de funcionalidades concretas, seguida de una validación mediante la ejecución de pruebas automáticas. Esta metodología permite medir con precisión cómo puede desempeñarse una inteligencia artificial en entornos de producción reales, más allá de simples ejemplos o demostraciones aisladas. La capacidad para navegar en código complejo, identificar problemas y aplicar soluciones funcionales sin intervención humana resulta indispensable para configurar una tecnología realmente útil para los ingenieros.

El enfoque de Refact.ai destaca por su autonomía total. Su agente funciona mediante un proceso iterativo, en el que planifica, ejecuta modificaciones, prueba resultados y se auto corrige hasta alcanzar una solución correcta, todo sin necesidad de instrucciones o supervisión externa. Esta filosofía 'autonomía primero' se refleja también en la configuración de la prueba, que limita las interacciones a un máximo de 60 pasos por tarea, donde cada paso es una acción discreta como cambiar una línea de código o correr un test. Para conseguir esta eficiencia, el agente utiliza una estrategia de prompt sofisticada que guía su comportamiento a alto nivel, incluyendo descripción inicial del problema, exploración del repositorio, generación y ejecución de scripts para reproducir el problema, planificación y aplicación de cambios con la asistencia de un modelo de razonamiento especializado, y evaluación constante mediante pruebas automáticas.

Esta metodología flexible permite al agente ajustar su camino según el contexto, repitiendo o saltándose etapas según convenga para resolver cada incidencia. En el núcleo del sistema se encuentra Claude 3.7 Sonnet, un modelo de IA que actúa como orquestador y tomador de decisiones. Con temperatura de muestreo en cero, este modelo muestra una capacidad impresionante para seguir instrucciones complejas y mantener coherencia durante interacciones extensas. La elección de Claude 3.

7 responde a su rendimiento probado en otros benchmarks exigentes, como Polyglot, donde logró tasas de éxito superiores al 92%, reafirmando su idoneidad para gestionar flujos de trabajo autónomos y detallados. Un aspecto clave que potencia al agente es la integración de la herramienta deep_analysis(), alimentada por el modelo o4-mini, que añade un ciclo estructurado de razonamiento para mejorar la calidad de las soluciones. Este procedimiento en tres fases consiste en la generación inicial de la solución, una crítica detallada que expone posibles debilidades o errores, y una refinación que corrige dichos problemas manteniendo las fortalezas identificadas. Su uso dinámico y autónomo por parte del agente durante la fase de planificación o incluso al evaluar resultados permite una mejora continua y adaptada según las exigencias de cada tarea. El conjunto de herramientas con las que cuenta Refact.

ai es amplio y robusto. Entre ellas, destacan funcionalidades especializadas para explorar código como búsqueda avanzada y análisis de referencias, herramientas de edición que permiten modificar archivos de texto con precisión, y la capacidad de ejecutar comandos en el shell para correr pruebas de Python y verificar la funcionalidad. Esta integración profunda con el entorno de desarrollo facilita al agente una interacción fluida y eficiente con el código base, indispensable para afrontar desafíos reales. Aunque el agente puede trabajar integrado con un ecosistema de herramientas reales como GitHub, Docker o bases de datos PostgreSQL, en el contexto del benchmark estas integraciones no fueron empleadas, concentrándose en la autonomía completa dentro del propio sistema de evaluación. Esto subraya la versatilidad del agente de Refact.

ai para adaptarse a diversas condiciones sin requerir dependencias externas estrictas. El resultado final habla por sí mismo. De las 300 tareas propuestas, Refact.ai resolvió con éxito 179, lo que representa un 59,7% de efectividad, superando a todas las soluciones open-source conocidas hasta la fecha. Destaca también la capacidad para solucionar problemas en proyectos donde otros agentes fallaron, como en casos específicos de Django y SymPy, reforzando la importancia del razonamiento avanzado proporcionado por el sistema.

El rendimiento por repositorio revela fortalezas particularmente en Django, con un éxito superior al 68%, y también resultados destacados en scikit-learn y requests. Sin embargo, hay áreas con margen de mejora, como en Flask, donde el agente no pudo resolver ninguna de las tres tareas evaluadas, o Sphinx, con un 37,5% de eficacia. Estos datos permiten identificar focos de desarrollo futuros para ampliar la cobertura y robustez del agente. Más allá de las cifras, la trascendencia del logro radica en el potencial que representa para la industria del software. La habilidad de delegar tareas repetitivas y complejas a un agente autónomo mejora la productividad de los equipos de desarrollo, les permite concentrarse en aspectos más creativos e innovadores y reduce el ciclo de entrega de software de calidad.

Además, al tratarse de una solución open-source, la comunidad puede explorar internamente el funcionamiento del agente, contribuir a su mejora y adaptarlo a necesidades particulares, impulsando una democratización del acceso a tecnología avanzada. El compromiso de Refact.ai con la transparencia y la colaboración queda patente al publicar la estrategia de prompts, el código y los modelos implicados. Esto invita a desarrolladores, investigadores y empresas a comprender cómo se implementa la autonomía en programación asistida por IA, fomentando la construcción colectiva de futuros sistemas aún más capaces. Mirando hacia adelante, el equipo de Refact.

ai anuncia planes para evaluar su agente en SWE-bench Verified, un conjunto de pruebas más riguroso que podría posicionarlo aún más firmemente como referente en inteligencia artificial aplicada al desarrollo. Esta ambición demuestra la confianza en la robustez técnica lograda y la visión de un futuro donde los agentes autónomos acompañen a los humanos en todos los procesos del ciclo de vida del software. Finalmente, Refact.ai enfatiza que SWE-bench Lite no es solo un ejercicio académico ni una competencia de puntuaciones, sino una representación fiel de desafíos reales que enfrentan desarrolladores a diario. Por ello, su agente se presenta como un colaborador capaz de automatizar tareas tediosas, garantizar código confiable y acelerar entregas, integrándose directamente en los entornos de desarrollo cotidianos como VS Code o JetBrains.

La inteligencia artificial que codifica, piensa y se adapta como un desarrollador senior ya es una realidad tangible. Refact.ai propone una revolución en la ingeniería de software, donde la productividad se multiplica y el talento humano se libera para innovar. Esta sinergia entre capacidades humanas y autonomía artificial promete configurar el futuro de la programación, haciendo que los agentes de IA se conviertan en socios estratégicos y no simples herramientas auxiliares.