En el vertiginoso mundo de la inteligencia artificial, el concepto de sistemas agénicos está revolucionando la manera en que concebimos y desarrollamos soluciones complejas. Estos sistemas, caracterizados por múltiples agentes especializados que operan de manera modular y colaborativa, prometen una evolución hacia inteligencias más sofisticadas y autónomas. Sin embargo, a pesar de la teoría que avala esta arquitectura limpia y segmentada, la práctica revela un camino lleno de complejidades, riesgos y desafíos técnicos que dificultan el salto inmediato hacia la automatización total. En este contexto, surge una estrategia innovadora y pragmática: comenzar con humanos actuando como agentes de IA. Esta aproximación implica que, en lugar de confiar de inmediato en modelos completos y autónomos, tareas especialmente críticas o complejas son realizadas por humanos que simulan el comportamiento y la toma de decisiones que se espera de los futuros agentes artificiales.

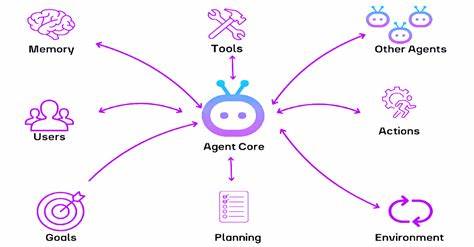

Este enfoque permite una transición controlada y segura, donde el sistema puede madurar paso a paso, obteniendo datos valiosos, entendiendo mejor los procesos y ganando confianza tanto de los desarrolladores como de los usuarios. Los sistemas agénicos buscan modularizar la inteligencia artificial. Esto quiere decir que en lugar de tener un modelo monolítico, se diseña un ecosistema de agentes especializados, cada uno encargado de una tarea concreta. Por ejemplo, uno podría encargarse de extraer información relevante de una consulta recibida, otro podría evaluar el contexto histórico del cliente, mientras que otro se especializa en la generación de respuestas apropiadas. Esta separación facilita el mantenimiento, la actualización y la mejora continua, además de ofrecer límites de seguridad claros.

Pero a medida que se multiplica la cantidad de agentes, también crecen exponencialmente las interdependencias, la complejidad y el riesgo de errores o fallos inesperados. Los humanos, por su parte, tienen la capacidad innata de manejar tareas fluidas, que atraviesan múltiples dominios y que requieren juicios basados en contexto y experiencia, cualidades que aún no son replicadas satisfactoriamente por sistemas artificiales. Cuando se enfrentan a una petición, las personas pueden identificar rápidamente matices como el tono emocional del remitente, la urgencia implícita del mensaje o la relevancia de interacciones previas que no siempre están estructuradas en bases de datos. Además, pueden decidir cuándo resolver un problema por sí solos y cuándo necesitan escalar o contar con la colaboración de un equipo. Poner a humanos en el centro del sistema agénico no es una vuelta al pasado, sino un paso estratégico hacia adelante.

Actuar con humanos-as-agentes implica diseñar las herramientas y procesos de manera que los trabajadores humanos operen bajo las mismas reglas, flujos y parámetros que eventualmente tendrá el sistema automático. Esto suele realizarse con integraciones mediante plataformas como Slack o correo electrónico, que actúan como interfaces proxy para que los humanos reciban, procesen y respondan las tareas, imitando el flujo que algún día ejecutarán los agentes artificiales. Esta metodología aporta múltiples beneficios. En primer lugar, se asume una responsabilidad predeterminada sobre la confiabilidad del sistema, partiendo del cero completo de confianza en la automatización, lo que evita impactos negativos por decisiones erróneas. En segundo lugar, permite un desarrollo ágil y parcialmente funcional desde etapas tempranas, sin necesidad de tener todos los agentes activos o completamente desarrollados.

En tercer lugar, fomenta un aprendizaje profundo sobre los procesos, dificultades y excepciones típicas al observar a humanos ejecutar las tareas, información crucial para diseñar agentes más robustos. A medida que los humanos desempeñan estas funciones, se genera un valioso conjunto de datos etiquetados y contextualizados, los cuales son esenciales para entrenar y validar inteligencias artificiales en el futuro. Contar con ejemplos reales de cómo se realizan las tareas protege contra errores de diseño y desconexiones entre la intención y la ejecución automatizada. Además, integrar a los usuarios humanos y stakeholders desde el inicio fortalece la confianza y el compromiso con el proyecto, lo que resulta vital para su adopción y éxito a largo plazo. Existen diferentes etapas para la madurez de los sistemas agénicos.

Al inicio, el sistema puede simular respuestas predefinidas sin agentes reales. Luego, pasa a un modo manual donde humanos hacen el trabajo detrás de una interfaz, seguido por un modo copiloto donde la inteligencia artificial sugiere soluciones que los humanos editan y aprueban. Posteriormente, en un modo de humano en el ciclo, la IA asume el control con supervisión humana para validar o corregir potenciales errores. Más adelante, el sistema puede manejar con confianza tareas de bajo riesgo mientras escalando situaciones complejas a humanos. Finalmente, se alcanzaría un estado plenamente autónomo, donde la inteligencia artificial maneja todas las tareas con mínima intervención humana, aunque con monitoreos regulares para evitar degradaciones.

Esta progresión gradual no solo mitiga riesgos, sino que crea un diseño nativo donde la presencia humana es una constante, habilitando controles, validaciones y ajustes continuos vitales para mejorar la calidad y corregir posibles sesgos. Es importante destacar que la inclusión humana temprana también ayuda a detectar y mitigar sesgos inadvertidos. Si los agentes humanos no son diversos o presentan patrones de discriminación inconscientes, esos sesgos pueden trasladarse a la inteligencia artificial que se entrena con sus datos y acciones. Por ello, es recomendable implementar rotaciones de agentes humanos, diversidad en los equipos de revisión y auditorías regulares para asegurar que el sistema evoluciona de manera equitativa y justa. Además, los sistemas agénicos con humanos-agentes consideran características necesarias para optimizar tiempos y prioridades.

Desde la clasificación previa de las solicitudes, que ayuda a identificar cuándo un agente artificial puede manejar una consulta o cuándo es indispensable la intervención humana, hasta la priorización mediante modelos de puntuación que facilitan la gestión de colas para evitar cuellos de botella. Para que un agente —ya sea humano o artificial— progrese a la siguiente etapa de madurez, deben definirse criterios claros y medibles, como métricas sostenidas de desempeño o tasas mínimas de intervenciones humanas. Estos parámetros permiten evaluar objetivamente cuándo un sistema está listo para asumir más responsabilidad, garantizando calidad y seguridad. En definitiva, construir sistemas agénicos exitosos requiere un enfoque balanceado que combine la inteligencia humana y artificial, respetando la etapa evolutiva de cada componente. Comenzar con humanos como agentes no equivale a una solución temporal o un retroceso, sino que constituye un plan operativo estratégico que habilita la mejora continua, el aprendizaje constante y la generación de confianza necesaria para escalar hacia sistemas autónomos confiables y eficientes.

El futuro de la inteligencia artificial pasa tanto por la arquitectura técnica como por la gestión humana y cultural. Solo mediante la coevolución de estos elementos será posible alcanzar ecosistemas agénicos que no solo sean poderosos, sino también seguros, transparentes y alineados con los valores y necesidades reales de las personas y organizaciones que los utilizan.