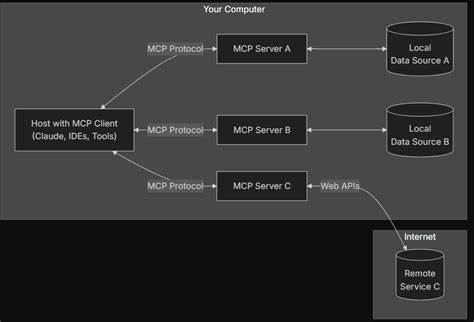

En la era actual, donde la inteligencia artificial y los modelos de lenguaje avanzados se integran cada vez más en nuestras herramientas digitales, surge una necesidad común: acceder a información precisa, actualizada y confiable de manera directa y en tiempo real. Aunque los modelos de lenguaje grande (LLM, por sus siglas en inglés) poseen vastos conocimientos adquiridos durante su entrenamiento, enfrentan limitaciones significativas para acceder a datos recientes o altamente especializados. Ante este escenario, una solución emergente y potente es el protocolo Model-Context-Protocol (MCP), una interfaz estandarizada que facilita la comunicación directa entre modelos de inteligencia artificial y fuentes externas de datos o servicios. En particular, construir un servidor MCP que proporcione acceso a Wikipedia se presenta como una innovación clave para extender la utilidad y funcionalidad de las IAs, permitiendo que consulten una de las bases de conocimiento más amplia y detallada del mundo. El MCP, creado por Anthropic, ofrece un modelo cliente-servidor en el que el cliente suele ser un modelo de IA o una aplicación que lo embebe, mientras que el servidor es un sistema externo que provee recursos, herramientas o datos.

Esta arquitectura unificada evita la fragmentación creada por desarrollos personalizados, facilitando el desarrollo y la integración de nuevas herramientas compatibles con cualquier sistema MCP. Al construir un servidor MCP centrado en Wikipedia, se abre la puerta para que los modelos accedan a datos relevantes mediante funciones específicas, tales como búsquedas, consultas de artículos completos, o acceso a secciones concretas dentro de una página. Para implementar esto, es posible utilizar herramientas como la librería "wikipedia-api" en Python, que interactúa directamente con la API de Wikimedia y facilita la recuperación eficiente de información. El diseño del servidor implica la definición clara de los tipos de datos que se manejarán, aprovechando modelos de datos estructurados como los provistos por Pydantic para describir páginas, secciones y resultados de búsqueda con metadatos útiles. Una ventaja relevante de esta arquitectura es la flexibilidad con la que los consumidores del servicio pueden solicitar sólo la información que realmente necesitan, por ejemplo, limitar la cantidad de texto descargado o focalizar búsquedas en secciones específicas para optimizar la atención de la IA y evitar sobrecarga de información.

Otra dimensión clave en la construcción del servidor es la elección del transporte de datos. MCP permite implementaciones tanto en modo local —donde la comunicación se realiza mediante canales estándar de entrada y salida—, como remoto, en donde el servidor está alojado en una red y se comunica mediante HTTP o tecnologías similares. Esta doble opción otorga versatilidad para adaptarse a distintos entornos y casos de uso. Para la implementación en Python, el paquete FastMCP es una opción destacada, ya que además de ofrecer una referencia funcional del protocolo, cuenta con integración nativa con Pydantic, lo cual simplifica la definición de herramientas y modelos de datos dentro del servidor MCP. El servidor puede exponer diversas herramientas como por ejemplo funciones para obtener un artículo completo, recuperar el contenido de una sección específica o realizar búsquedas dentro de Wikipedia con soporte para paginación.

Esta granularidad permite a los agentes IA construir flujos de trabajo más inteligentes y optimizados, evadiendo respuestas demasiado extensas o irrelevantes. Además, se puede incluir en el servidor MCP prompts predefinidos que sirvan como guías para los agentes, alentándolos a seguir pasos ordenados y consistentes al buscar, filtrar y resumir la información consultada, elevando la calidad de las respuestas generadas. De esta forma, agentes basados en frameworks como SmolAgents pueden integrarse con el servidor, brindando a los usuarios finales una experiencia enriquecida donde la IA no solamente utiliza sus conocimientos internos, sino que complementa sus respuestas con datos actualizados y de alta fidelidad provenientes de Wikipedia. Por ejemplo, un asistente basado en GPT-4o puede emplear el servidor MCP de Wikipedia para investigar en tiempo real las causas de la Revolución Francesa, combinando herramientas de búsqueda y consulta detallada para producir una respuesta completa respaldada con referencias precisas, lo que mejora la confianza y utilidad de la interacción. No obstante, el desarrollo y despliegue de servidores MCP contempla también desafíos importantes en materia de seguridad.

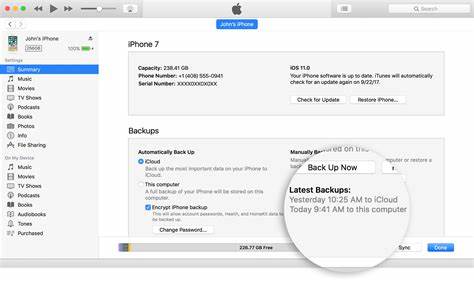

Exponer herramientas y capacidades externas a un agente de IA conlleva riesgos inherentes, especialmente relacionados a posibles ataques de inyección, manipulación o acceso no autorizado. Por ello, el protocolo MCP está incorporando progresivamente mecanismos de autenticación y autorización, recomendados para proteger los servidores contra accesos maliciosos o usos indebidos, garantizando la integridad y confiabilidad del sistema. En términos prácticos, para iniciar un servidor MCP de Wikipedia, la configuración inicial implica gestionar un entorno Python con dependencias necesarias, como FastMCP, Pydantic, requests, la librería para Wikipedia y SmolAgents para facilitar la interacción con agentes, todo convenientemente orquestado mediante herramientas modernas de gestión y despliegue. Posteriormente, el código define clases que modelan las páginas, secciones y resultados de búsqueda, provee funciones que actúan como herramientas disponibles para los clientes MCP, y configura la ejecución del servidor ya sea en modo stdio o SSE, según las necesidades del proyecto. La importancia de esta solución radica en cómo puede transformar la forma en que los agentes conversacionales y asistentes digitales trabajan, pasando de modelos estáticos con conocimiento finito a sistemas dinámicos y plug-and-play que acceden a fuentes externas, enriqueciendo sus capacidades y relevancia para los usuarios.

Además, esta arquitectura fomenta un ecosistema donde desarrolladores, empresas y comunidades pueden ofrecer sus propios MCP servers, estandarizando así las conexiones con las inteligencias artificiales y facilitando la explotación de diversas herramientas y bases de conocimiento. Finalmente, el desarrollo de un servidor MCP conectado a Wikipedia representa un caso paradigmático del poder de la interoperabilidad, la modularidad y la estandarización para el futuro de la inteligencia artificial. La evolución de esta tecnología seguramente impactará positivamente en múltiples sectores, desde la educación hasta el soporte técnico, pasando por la generación de contenido, investigación y más, proporcionando a los sistemas de IA la capacidad de mantener sus respuestas actualizadas, contextualizadas y verificables, marcando un avance significativo hacia asistentes digitales cada vez más útiles y confiables.