En la era digital actual, las redes sociales se han transformado en escenarios donde la información y el contenido generado por usuarios conviven con textos producidos por inteligencia artificial (IA). La detección de contenido generado por IA en publicaciones de redes sociales es cada vez más relevante debido al crecimiento exponencial de generadores automáticos de texto que pueden producir mensajes, noticias, opiniones o incluso discursos completos con apariencia humana. Esta situación plantea cuestionamientos importantes acerca de la veracidad, la ética y la confianza en las plataformas sociales. El avance de modelos como ChatGPT y otros sistemas de lenguaje ha facilitado la creación de contenido de alta calidad indistinguible del creado por humanos. Esto no solo afecta la manera en que se consume la información sino también el modo en que las plataformas deben monitorear y moderar el contenido.

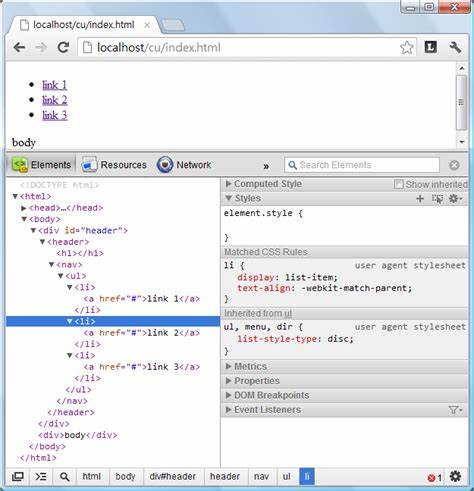

La problemática principal radica en que muchos de los sistemas disponibles para detectar si un texto fue generado por IA poseen limitaciones significativas, incrementando el riesgo de errores y falsos positivos que pueden generar conflictos entre usuarios y administradores. Una de las alternativas más conocidas para detectar contenido generado por IA es GPTZero, un software que analiza cadenas de texto para determinar su origen. Sin embargo, su modelo implica enviar contenido a servidores comerciales de terceros, lo que genera preocupaciones relacionadas con la privacidad, el costo económico y la dependencia externa. Por este motivo, algunas comunidades y desarrolladores han optado por explorar sistemas de código abierto que puedan alojarse y controlarse de forma propia, evitando así la comunicación con servicios externos. Entre estas alternativas destacan proyectos como Binoculars y Zippy.

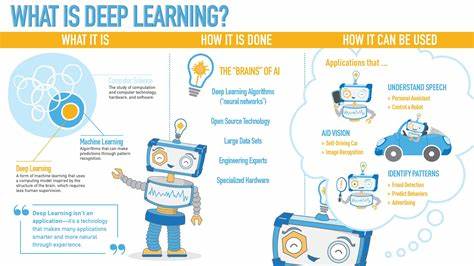

Binoculars es un detector basado en modelos de aprendizaje profundo que promete mayor precisión en la identificación al analizar patrones propios del texto generado por IA. No obstante, su aplicación práctica se ve afectada por el requerimiento de hardware especializado, especialmente GPU potentes y memoria RAM significativa, lo cual limita su uso en escalas grandes o por usuarios comunes. Zippy, por su parte, es una propuesta que busca un balance entre eficiencia y velocidad. Aunque su funcionamiento no es infalible, ofrece detección rápida y puede servir como primer filtro para identificar contenidos sospechosos. La problemática común en ambas herramientas es el alto consumo de recursos y la dificultad para mantenerse actualizadas ante las constantes mejoras en modelos de generación automática, que evolucionan para evadir detección.

Los expertos y usuarios coinciden en que ningún detector de contenido generado por IA actual es completamente confiable. Los sistemas comerciales, aunque mejor entrenados, enfrentan dificultades para reconocer textos procedentes de las versiones más recientes de programas generadores. Asimismo, sufren ocasionalmente falsos negativos, donde contenido generado por IA pasa desapercibido, y falsos positivos, afectando la experiencia de usuarios que crean contenido legítimo. En el ámbito de la educación, por ejemplo, herramientas similares llevan años usándose para detectar trabajos y ensayos elaborados mediante inteligencia artificial. Sin embargo, la efectividad comprobada suele ser baja y genera debates acerca de su utilidad real.

Algunos opinan que estrategias como fortalecer la reputación de los usuarios y establecer múltiples puntos de verificación podrían ser más eficaces que imponer detección estricta y pesada. Otra línea de reflexión apunta al futuro de la regulación y la responsabilidad de las empresas desarrolladoras de IA. Una solución planteada por varios actores es la incorporación obligatoria de marcas de agua digitales o 'watermarks' integradas en la generación del texto automatizado. Esto permitiría identificar con casi total certeza el contenido generado por IA, sin necesidad de consumir grandes recursos computacionales para su detección. No obstante, hasta el momento, las principales compañías de inteligencia artificial como OpenAI han sido renuentes a implementar estas medidas, alegando motivos que incluyen la privacidad y la libertad creativa.

De hecho, han eliminado características que anteriormente facilitaban la identificación, como patrones específicos en espacios o formatos distintivos. Este rechazo hace que la comunidad técnica tenga que adaptar sus soluciones y convivir con un mayor margen de error. Dada la complejidad del panorama, muchos especialistas consideran que la mejor estrategia para gestionar contenido generado por IA excede la detección tecnológica. Se sugiere abordar el fenómeno con las mismas herramientas utilizadas para moderar contenido dañino o manipulado, combinando inteligencia artificial con intervención humana, seguimiento del comportamiento del usuario y evaluación contextual. Además, la creciente sofisticación del contenido falso o manipulado mediante IA supone un nuevo reto para la confianza social.

Los usuarios deben desarrollar habilidades críticas para discernir la autenticidad de la información y las plataformas tienen el desafío de implementar políticas transparentes que aseguren el balance entre libertad de expresión y protección contra desinformación. En definitiva, la detección de contenido generado por inteligencia artificial en redes sociales es un área en pleno desarrollo, marcada por avances tecnológicos y limitaciones a la vez. La búsqueda de soluciones viables exige la colaboración entre desarrolladores, empresas, reguladores y usuarios para crear ecosistemas digitales más responsables y confiables. En el futuro cercano, es probable que surjan mejoras fundamentadas en modelos más compactos y optimizados que permitan ampliar el acceso a detectores capaces de funcionar sin necesidad de gráficas costosas. También será esencial promover normativas que incentiven a los creadores de IA a implementar mecanismos que faciliten la detección originaria, minimizando el impacto social del contenido automatizado.

Por ahora, las redes sociales y sus comunidades deben prepararse para convivir con el fenómeno de la IA generadora de texto, fortaleciendo sus sistemas de moderación y fomentando la educación digital. Aunque la batalla para identificar con certeza este tipo de contenido puede ser compleja y subtipo, el equilibrio entre innovación tecnológica y ética será clave para preservar un internet verdaderamente abierto y seguro para todos.