La inteligencia artificial ha avanzado de manera impresionante en los últimos años, demostrando capacidades sorprendentes en tareas tan diversas como reconocimiento de imágenes, procesamiento de lenguaje natural y resolución de problemas complejos. Sin embargo, a pesar de estos logros, persiste una brecha entre la sofisticación de los sistemas de IA actuales y la flexibilidad y adaptabilidad que caracterizan la cognición humana. Un aspecto clave de esta diferencia radica en cómo el cerebro procesa la información: a través de la sincronización y el tiempo. Las Máquinas de Pensamiento Continuo, conocidas en inglés como Continuous Thought Machines (CTM), representan una evolución revolucionaria en el diseño de redes neuronales. Inspiradas en la biología y particularmente en la forma en que las neuronas cerebrales utilizan el tiempo y la sincronización para codificar y procesar señales, las CTM proponen una arquitectura que no sólo considera la activación neuronal estática, sino su dinámica temporal como núcleo de su funcionamiento.

Esto supone un cambio radical respecto a las redes neuronales tradicionales, que priorizan la eficiencia computacional simplificando las activaciones a valores puntuales sin considerar su evolución temporal. Una de las características más destacadas de las CTM es la introducción de una dimensión interna independiente y recurrente donde el pensamiento puede desarrollarse de forma continua. A diferencia de modelos como las redes recurrentes tradicionales o los transformadores, que procesan los datos en función de la secuencia natural de entrada (como palabras en un texto o fotogramas en video), las CTM generan su propio flujo temporal interno. Esto les permite desplegar un proceso iterativo de pensamiento, incluso cuando trabajan con datos estáticos o no secuenciales, como imágenes o laberintos. Esta dimensión temporal, conocida como interna o de 'ticks', es crucial para permitir que el modelo construya y refine sus representaciones progresivamente.

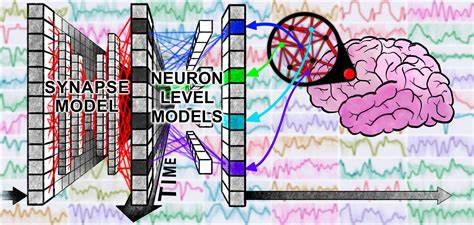

Tal enfoque está profundamente alineado con cómo el cerebro humano procesa información y resuelve problemas: mediante la interacción y sincronización de patrones neuronales a lo largo del tiempo para formar pensamientos complejos y flexibles. Para llevar a cabo este pensamiento continuo, las CTM utilizan un modelo denominado Neuron-Level Models (NLM), donde cada neurona tiene su propio conjunto de pesos y funciones que procesan un historial reciente de señales entrantes, produciendo lo que se denomina post-activaciones. Este diseño privado y especializado por neurona permite una dinámica mucho más rica y diversa en comparación con la activación única y uniforme empleada en la mayoría de redes neuronales. Otra pieza fundamental del modelo es la representación de la sincronización neuronal. En lugar de trabajar sólo con vectores de activación estáticos, las CTM calculan matrices de sincronización a partir de las interacciones temporales entre las activaciones neuronales.

Estas matrices capturan cómo las neuronas se sincronizan entre sí a lo largo del tiempo, y este patrón de sincronización constituye la representación latente con la que el modelo observa el mundo y toma decisiones. El aprovechamiento de la sincronización para representar información abre una dimensión mucho más amplia y expresiva para la codificación neuronal, permitiendo que el modelo capture relaciones complejas y dependencias temporales profundas que permanecen fuera del alcance de los enfoques tradicionales. Esta capacidad fue probada en una diversidad de tareas desafiantes, ilustrando cómo las CTM pueden acelerar el aprendizaje y la generalización. En la tarea de clasificación de imágenes con conjuntos como ImageNet, el modelo no sólo demostró precisión competitiva, sino también una calibración sorprendentemente buena, superando incluso a humanos en algunos aspectos de confianza en las predicciones. Además, las CTM exhiben una capacidad adaptativa para regular el tiempo empleado en el procesamiento según la dificultad de cada entrada, un rasgo que recuerda a cómo el cerebro humano dedica más atención a estímulos complejos y menos a los triviales.

Esta flexibilidad temporal, llamada computación adaptativa, permite optimizar el equilibrio entre precisión y eficiencia. El modelado temporal también permitió avances significativos en problemas de razonamiento secuencial no lineal, como la resolución de laberintos o la predicción de paridad en secuencias binarias completas suministradas simultáneamente, donde modelos clásicos como LSTM tienen dificultades. Las CTM lograron construir representaciones internas que simulan mapas mentales o estrategias a largo plazo, confirmando que el procesamiento dinámico temporal es un componente esencial para la inteligencia avanzada. Otra área donde las CTM sobresalen es en la memoria a largo plazo y la recuperación de información. En tareas de preguntas y respuestas basadas en secuencias visuales y comandos numéricos, el modelo es capaz de recordar y manipular información que queda fuera del rango inmediato de activación, gracias a la organización de sus patrones de sincronización.

Esto ofrece una perspectiva novedosa sobre cómo la sincronización neuronal puede actuar como mecanismo subyacente de la memoria en sistemas artificiales. Los investigadores también exploraron aplicaciones en el aprendizaje por refuerzo, adaptando las CTM para interactuar con entornos dinámicos, incluyendo tareas de navegación y control en escenarios parcialmente observables. Aunque las CTM alcanzaron rendimientos similares a los modelos recurrentes existentes, su arquitectura sugiere un potencial para integrar historia continua de activaciones a lo largo de la interacción, lo cual podría abrir nuevas vías para modelos con planificación y razonamiento más sofisticados. Más allá de los resultados técnicos, lo que sitúa a las Máquinas de Pensamiento Continuo como una revolución en inteligencia artificial es su acercamiento a una forma de computación inspirada en la biología, sin adherirse de manera rígida a las limitaciones exactas de las neuronas reales, sino adoptando conceptos como la sincronización y el tiempo de una forma práctica y escalable. Este equilibrio abre un terreno fértil para futuras investigaciones que busquen el desarrollo de máquinas con capacidades cognitivas cualitativamente nuevas.