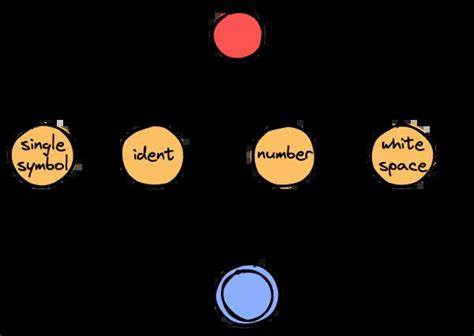

En el mundo del desarrollo de compiladores y análisis de lenguajes, la eficiencia del lexer, o analizador léxico, suele ser un pilar fundamental para garantizar un rendimiento óptimo de todo el proceso. Rust, conocido por su velocidad y seguridad, cuenta con una herramienta ampliamente reconocida llamada Logos, famosa por generar lexers rápidos y eficientes. Sin embargo, un desarrollo reciente ha demostrado que es posible superar a Logos en términos de rendimiento con una implementación a medida adulta y optimizada, que explota tanto las propiedades del hardware como la naturaleza de los datos. Logos basa su velocidad en un enfoque clásico de máquinas de estados impulsadas por tablas de saltos. En esencia, cada tipo de token es representado por un estado y las transiciones se definen para subconjuntos factibles de caracteres, típicamente caracteres ASCII o latinos.

Desde el punto de vista operativo, cada llamada al método que extrae el siguiente token comienza en un estado inicial y progresa mediante transiciones que dependen de los bytes de entrada hasta alcanzar un estado terminal que indica el tipo de token reconocido. Esta estrategia es extremadamente eficiente, especialmente cuando el input consiste principalmente en ASCII, pues se pueden implementar tablas completas por cada estado con índices directos usando bytes. En entradas más complejas, como aquellas que requieren soporte completo para UTF-8, el mecanismo se vuelve más costoso, utilizando un enfoque basado en sentencias switch con múltiples ramas. De hecho, recursos dedicados explican cómo optimizar este tipo de lexers con técnicas complementarias, como el uso de clases de equivalencia para reducir la complejidad de las transiciones. No obstante, la implementación personalizada en estudio comenzó con una base sencilla y poco optimizada, priorizando la simplicidad sobre el rendimiento.

En este contexto, se empleó para el reconocimiento de palabras clave una función hash perfecta, que puede realizar comparaciones directamente en registros de 64 bits, aprovechando que todas las palabras clave tienen menos de 8 caracteres. Este hecho permite transformar la comparación entre keyword y entrada en una simple instrucción de comparación de registros, lo que ya ofrece una ventaja notable. La función hash perfecta fue diseñada para ser muy simple, con un árbol de dependencia de datos poco profundo y utilizando instrucciones elementales. Herramientas como GNU gperf u otras metodologías pueden generar estas funciones eficientemente. De hecho, este tipo de soluciones son utilizadas en proyectos de envergadura como PostgreSQL o el motor V8 de Google.

Para validar la eficiencia, se realizaron comparativas en sistemas Apple M1 usando un archivo de prueba de aproximadamente 100 kilobytes de pseudocódigo. La implementación personalizada completó el análisis en cerca de 313 microsegundos por iteración, mientras que Logos lo hizo en 174 microsegundos, demostrando casi el doble de velocidad. Resultados diferentes aparecieron en arquitectura x86_64, donde la implementación manual fue más rápida que Logos, lo que indica que la arquitectura del procesador y su sistema de ejecución especulativa tienen un impacto significativo. Este fenómeno se relaciona con las características de la ejecución especulativa y el prefetching de datos en CPU modernas. La ejecución especulativa actúa como un prefetcher agresivo, fundamental para manejar tamaños de conjunto de trabajo que superan los niveles de caché L1 o L2.

Por otro lado, las técnicas sin ramas suelen intercambiar control por dependencia de datos, pero la CPU no puede especular sobre datos, principalmente por razones de seguridad, lo que afecta el rendimiento. La exploración de optimizaciones continuó con la inclusión de la anotación #[inline(always)] en todas las funciones, lo que generó un aumento del rendimiento de aproximadamente un 30%. Además, se identificaron ciertas características del API que entorpecían el rendimiento, como una función "peekable" que introducía ramas adicionales y un diseño que usaba punteros fat y enums envueltos en Option, generando cierta ineficiencia en memoria y procesamiento. Al eliminar el mecanismo de peeking y simplificar la gestión de tokens replicando valores en lugar de retornando referencias, la implementación se acercó a solo un 25% de desventaja respecto a Logos, destacando que la estructura y la forma en que se manejaron los datos influyó notablemente en el rendimiento global. En cuanto al procesamiento de caracteres, se hizo énfasis en la optimización para entradas ASCII, un caso muy común en código fuente de múltiples lenguajes.

Datos recopilados mostraron que la gran mayoría del código fuente de proyectos grandes es casi completamente ASCII, lo que permite implementar una estrategia de dispatch que divide el flujo de análisis en dos rutas: una rápida para ASCII y otra más lenta para caracteres no ASCII. Esta técnica es similar a la vectorización de bucles en compiladores, donde se verifica si una cantidad n de elementos puede ser procesada de manera optimizada. Si la comprobación se cumple, se utiliza la versión eficiente en proceso paralelo, de lo contrario, se recurre a la implementación estándar. Sin embargo, ciertas implementaciones del manejo del fallo, como llamar a una función que termine el programa (todo!), pueden impedir optimizaciones subsecuentes y degradar el rendimiento. A partir de estos conceptos, se implementó una función de look-up paralela que utiliza instrucciones SIMD propias de ARMv8 NEON, que operan sobre bloques de 16 bytes en paralelo.

Esto permite clasificar caracteres en categorías como dígitos, espacios en blanco, alfabéticos o símbolos, lo cual simplifica y acelera la identificación de tokens simples. Una máquina de estado muy simple llamada "skip loop" fue diseñada para identificar identificadores al reconocer cuándo una cadena de caracteres alfabéticos o alfanuméricos comienza y cuándo termina, reduciendo considerablemente las comprobaciones individuales y facilitando transiciones más predecibles para el procesador. Los resultados demostraron un impresionante aumento del 35% en velocidad respecto a Logos, llegando a completar el análisis en aproximadamente 118 microsegundos por iteración. Esta mejora se atribuye a una mejor alineación entre la implementación y las capacidades del procesador, incluyendo un mejor uso de la ejecución especulativa y la predictibilidad de las ramas. En la parte correspondiente al reconocimiento de palabras clave, la experimentación incluyó optimizaciones en la generación y uso de máscaras para filtrar caracteres relevantes.

Se cambió la operación tradicional de enmascarado mediante corrimientos y restas por una tabla precomputada de máscaras de bits, lo que sorprendió al mostrar una mejora adicional cercana al 5-10% en esta sección, aunque su impacto global es limitado dado que las palabras clave representan una porción menor de los tokens en códigos reales. Posteriormente se actualizaron los conjuntos de datos para incluir casos más realistas con identificadores que contienen guiones bajos y secuencias de espacios o identidades largas. Estas condiciones complejizaron el "skip loop" y redujeron la ventaja sobre Logos a alrededor de un 20-30%, pues afectaron la predictibilidad de las ramas y la frecuencia relativa de palabras clave. El estudio también evaluó cómo varía el rendimiento con diferentes tamaños de archivo, desde 5KB hasta 1MB, manteniendo un rango de mejora estable y substancial. Este análisis confirma que las optimizaciones implementadas mantienen su validez y eficacia en distintos escenarios.

Una lección importante de esta investigación fue verificar las implicancias de ciertas anotaciones de Rust, como #[no_mangle], que, aunque útiles para propósitos de depuración, pueden introducir regresiones importantes en rendimiento. Descartar esta anotación permitió asegurar que las medidas de tiempo fueran más representativas y fiables. Finalmente, esta exploración pone de manifiesto la relevancia de equiparar estrategias algorítmicas clásicas con características específicas de hardware y supuestos realistas sobre datos de entrada. La combinación de inlining agresivo, manejo eficiente de tablas, dispatch inteligente para ASCII, uso de SIMD y estructuras de control simplificadas lleva a superar a un generador de lexer sofisticado y optimizado como Logos. Si bien la viabilidad práctica aún está sujeta a condiciones particulares del entorno de compilación y la forma específica en que se invoca al lexer, los resultados son prometedores.

De igual modo, el estudio sugiere que un enfoque que fije la predictibilidad del flujo de control y aproveche las capacidades paralelas nativas del procesador puede marcar diferencias sustanciales de rendimiento. Este caso representa un avance intrigante en la optimización de análisis léxico en Rust, fomentando un balance entre flexibilidad, sencillez y máxima eficiencia a nivel máquina, inspirado en arquitecturas modernas pero sólido en fundamentos teóricos. En conclusión, mediante estrategias cuidadosamente diseñadas que integran conocimiento profundo tanto de la implementación de lexers como del hardware, es posible no solo competir contra, sino superar significativamente al que hasta hace poco se consideraba el más rápido generador de lexers en Rust. La senda hacia lexers ultrarrápidos continúa abierta, y estos resultados abren nuevas posibilidades para compiladores y herramientas de análisis sintáctico de alto rendimiento.