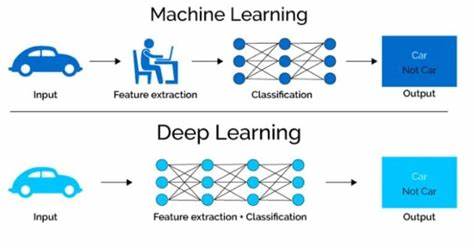

El crecimiento exponencial del aprendizaje automático ha impulsado una demanda sin precedentes de poder de cómputo, destacando las unidades de procesamiento gráfico (GPUs) como uno de los pilares tecnológicos fundamentales en esta evolución. Sin embargo, a medida que los modelos de inteligencia artificial se vuelven más complejos y variados, gestionar la capacidad y eficiencia de las GPUs se convierte en un desafío crítico para centros de datos y empresas que buscan maximizar el rendimiento y minimizar costos energéticos. En este contexto surge LithOS, un sistema operativo innovador desarrollado para abordar estas necesidades específicas y llevar la eficiencia en el uso de GPUs a un nuevo nivel. LithOS representa una nueva era en la gestión de recursos de GPUs, ofreciendo una plataforma especializada que optimiza la administración, el aislamiento y la utilización de la capacidad de cómputo en tiempos de ejecución de cargas de trabajo múltiples y simultáneas. La esencia de este sistema radica en su enfoque en la abstracción y control granular de los recursos del GPU, especialmente de las unidades conocidas como TPCs (Texture Processing Clusters), que son bloques funcionales dentro de la arquitectura del GPU dedicados a procesar distintos tipos de tareas asignadas.

Uno de los avances más significativos que introduce LithOS es su novedosa planificación a nivel espacial, donde un programador de tareas denominado TPC Scheduler permite distribuir y aprovechar los TPCs según las necesidades específicas de cada aplicación. Esta función posibilita lo que se conoce como "robo de TPCs", una forma inteligente de reasignar dinámicamente recursos disponibles entre diferentes cargas de trabajo para evitar tiempos muertos ociosos, redundando en una mejora sustancial en la eficiencia global del sistema. Además, LithOS incorpora una técnica llamada atomización transparente de kernels. En términos prácticos, esta innovación reduce el problema del bloqueo en la cabeza de línea, una situación donde una tarea pesada retrasa la ejecución de otras pendientes. La atomización permite fragmentar las cargas de trabajo en unidades más pequeñas, llamadas átomos, que pueden ser ejecutadas y reprogramadas de manera independiente, facilitando la reasignación dinámica de recursos durante la ejecución.

Esto se traduce en una menor latencia en las aplicaciones y una utilización más fluida y eficiente de los recursos del GPU. El sistema también implementa un mecanismo ligero de ajuste del hardware denominado right-sizing, que determina automáticamente la cantidad mínima de recursos TPC requeridos para ejecutar cada átomo. Esta capacidad es crucial para evitar el desperdicio de recursos, proporcionando únicamente la capacidad necesaria para la tarea en cuestión. La consecuencia directa es una reducción en el consumo energético sin comprometer el desempeño, lo que es especialmente valioso en centros de datos donde la eficiencia energética es un factor determinante para la sostenibilidad y reducción de costos operativos. Complementando estas funciones, LithOS dispone de un mecanismo de gestión de potencia transparente que ajusta dinámicamente el consumo basado en el comportamiento del trabajo en curso.

Esta característica monitorea el flujo de trabajo y modula el uso energético para evitar el exceso de consumo sin impactar negativamente el rendimiento, haciendo posible ahorros significativos en términos de energía durante la ejecución de cargas de trabajo con variabilidad en sus requerimientos de cómputo. La implementación de LithOS en el lenguaje Rust no solo ofrece ventajas en términos de seguridad y eficiencia debido a las características intrínsecas de Rust, sino que también facilita una integración moderna y robusta con el hardware de GPU. Este enfoque ha sido probado en diversos entornos de aprendizaje automático, enfrentándose a soluciones líderes actuales como NVIDIA MPS y otros sistemas de última generación. Los resultados obtenidos son impresionantes, evidenciando una reducción en las latencias máximas (tail latencies) de hasta 13 veces en escenarios de apilamiento de inferencias comparado con MPS, junto con incrementos en el rendimiento agregado que superan el 60% respecto a otros métodos. En contextos donde convergen inferencia y entrenamiento en el mismo entorno, LithOS también demuestra su versatilidad y eficacia, disminuyendo la latencia máxima en casi cinco veces frente a MPS y mejorando el rendimiento total en más del 30% en comparación con soluciones comparables.

Adicionalmente, las estrategias de right-sizing y gestión energética permiten ahorros sustanciales en el uso de la capacidad del GPU y en el consumo energético, con impactos mínimos en el rendimiento, lo que representa un balance ideal para operaciones comerciales y de investigación que buscan maximizar cada vatio y ciclo de procesamiento. La llegada de LithOS marca un antes y un después en la evolución del software de soporte para GPUs en aplicaciones de aprendizaje automático. Al convertir el GPU en un sistema gestionado mediante un sistema operativo especializado, se abren las puertas a nuevas posibilidades para la investigación y desarrollo enfocados en la eficiencia, flexibilidad y escalabilidad. Así, no solo se optimiza el rendimiento, sino que también se facilita el aislamiento efectivo entre múltiples cargas de trabajo, mejorando la seguridad y la predictibilidad en entornos compartidos. Este enfoque redefine la forma en que los expertos en sistemas y desarrolladores de inteligencia artificial piensan sobre la gestión de hardware, logrando un equilibrio entre desempeño y consumo energético que antes era difícil de alcanzar, especialmente en centros de datos de gran escala con múltiples usuarios y aplicaciones simultáneas.

El potencial de LithOS para ser la base de futuros sistemas operativos especializados en GPUs es alto, considerando la tendencia irreversible hacia la integración del aprendizaje automático en cada vez más sectores industriales. En conclusión, LithOS se posiciona como una innovación disruptiva en el mundo del aprendizaje automático y la computación de alto rendimiento. Su diseño centrado en la eficiencia, adaptabilidad y conservación energética responde a las demandas actuales y futuras de la industria tecnológica, ofreciendo soluciones concretas a problemas que limitan la explotación plena del poder de las GPUs. Empresas, investigadores y profesionales del área deben mantener un seguimiento cercano a esta propuesta que no solo optimiza recursos, sino que sienta las bases para el desarrollo de sistemas operativos orientados exclusivamente a las necesidades de la inteligencia artificial y el procesamiento paralelo avanzado. La transformación que promete LithOS es equiparable a la que supuso la llegada de sistemas operativos para CPUs en sus albores, pero orientada a un hardware con características y desafíos propios que requieren una gestión delicada y especializada.

El futuro del aprendizaje automático, con modelos cada vez más sofisticados y demandas crecientes en infraestructura, encontrará en LithOS una herramienta esencial para afrontar estas exigencias de manera eficiente y eficaz.