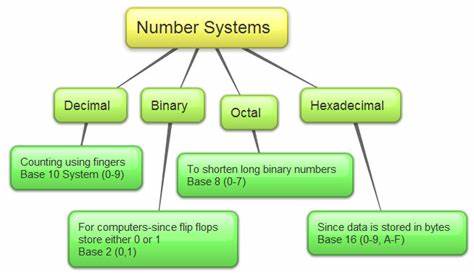

Desde el surgimiento de la informática, una de las dificultades más destacadas ha sido cómo representar numéricamente tanto enteros como números reales dentro de los sistemas digitales. A diferencia de los seres humanos, que utilizan un sistema decimal en base 10, los ordenadores funcionan internamente con un sistema binario. Este sistema se basa en dos únicos dígitos: el 0 y el 1, que corresponden a la ausencia o presencia de señales eléctricas. Este método simplifica el diseño del hardware, pero introduce retos específicos cuando se trata de almacenar y manipular números. La base fundamental de la representación numérica en la informática se halla en la codificación de cualquier número en una secuencia de bits o dígitos binarios.

Cada bit puede adoptar dos valores posibles, lo que genera un conjunto determinado de combinaciones para representar diferentes números. La cantidad de bits disponibles depende directamente de la arquitectura del sistema, que puede ser de 8, 16, 32, 64 bits o más, y afecta el rango y precisión de los números que pueden ser expresados. Los números enteros pueden representarse inicialmente como números sin signo, lo que significa que solo pueden almacenar valores positivos o cero. Por ejemplo, con 4 bits es posible codificar 16 números diferentes, desde 0 hasta 15. Este rango se determina por la fórmula 2 elevado al número de bits, dado que cada bit dobla la cantidad de combinaciones.

Aunque esta representación es sencilla y eficiente para ciertos propósitos como la gestión de memoria, tiene limitaciones evidentes cuando se requiere trabajar con números negativos. Para incluir los valores negativos, originalmente se intentó usar el sistema de signo y magnitud, donde un bit se reserva para indicar si el número es positivo o negativo y el resto representan el valor absoluto. Sin embargo, este método sufre varios inconvenientes. Uno de los más flagrantes es la existencia de dos representaciones para el cero: +0 y -0. Esta duplicidad complica operaciones aritméticas básicas y el hardware debe manejar casos especiales, reduciendo el rendimiento.

Frente a estas dificultades, surgió el sistema de complemento a dos, que actualmente es el método estándar para representar números enteros con signo en la mayoría de los procesadores modernos. En este esquema, el bit más significativo indica el signo, pero la manera en que se codifican los valores negativos permite que el sistema realice sumas y restas sin lógica adicional. El complemento a dos elimina la representación redundante del cero y unifica el tratamiento de números positivos y negativos, facilitando su manipulación en circuitos electrónicos. Los rangos numéricos reconocidos en los sistemas de representación son distintos según el método. La representación sin signo abarca valores desde cero hasta un máximo determinado por el número de bits; con signo y magnitud se reduce el rango y aparece la doble representación del cero; mientras que el complemento a dos otorga un rango simétrico y preciso con una sola representación de cero, optimizando recursos computacionales.

Más allá de los números enteros, uno de los mayores desafíos en la informática ha sido la representación de números reales, especialmente los decimales y fracciones, elementos imprescindibles en cálculos científicos, financieros y de ingeniería. Algunas cantidades tienen expansiones decimales infinitas, como el clásico 1/3, que es 0.3333...

de manera indefinida. Los ordenadores manejan un número finito de bits, por lo que es imposible almacenar tales valores con exactitud absoluta; en consecuencia, se adoptan métodos de aproximación y codificación especializados. La solución predominante ha sido el estándar IEEE 754, que define un formato de representación de números de punto flotante. Este sistema está inspirado en la notación científica, donde un número se expresa en términos de una mantisa y un exponente, permitiendo variar la posición de la coma decimal. Gracias a este diseño, es posible representar números muy grandes o muy pequeños, manteniendo un compromiso adecuado entre rango y precisión.

Un componente clave en los procesadores modernos es la Unidad de Punto Flotante, o FPU, que específicamente maneja operaciones con números en formato de punto flotante. Esta unidad ejecuta sumas, restas, multiplicaciones, divisiones y hasta funciones complejas como raíces cuadradas, facilitando el trabajo con datos reales y acelerando el cálculo numérico. El código que escribimos en lenguajes de programación se transforma en instrucciones binaras que invocan a la FPU para procesar eficientemente estos números. El proceso interno de la unidad de punto flotante implica primero alinear los exponentes de los números antes de realizar cualquier operación, luego sumar o restar las mantisas, normalizar el resultado para mantener la mantisa dentro de un rango prefijado y, finalmente, redondear si es necesario para ajustarse a la precisión disponible. Todo esto se realiza con gran rapidez y precisión, pero siempre con un pequeño margen de error inherente a la naturaleza finita de la representación.

Otro aspecto importante es cómo el computador o el programa distinguen el tipo de dato almacenado en memoria. Un mismo conjunto de bits puede interpretarse de formas muy distintas, dependiendo del contexto: un valor entero en complemento a dos, un número flotante IEEE 754, una cadena de caracteres ASCII o incluso un código de color RGB. Es el sistema operativo, compilador y el propio programador quienes deciden y especifican qué tipo de dato corresponde a un segmento de memoria, asegurando que la máquina realice la interpretación adecuada. En los lenguajes de programación, existen diversos tipos de datos para controlar esta representación. Por ejemplo, en C y C++, el tipo float corresponde a números de precisión simple (32 bits), mientras que el double representa un número de precisión doble (64 bits), ofreciendo mayor exactitud en los cálculos y un rango extendido.

El uso correcto de estos tipos es esencial para evitar errores derivados de la precisión limitada y las aproximaciones inherentes al punto flotante. Históricamente, la llegada de la representación en punto flotante fue determinante para ampliar el campo de aplicación de la informática. Durante los años 60, con el incremento de la actividad científica y tecnológica, se evidenció la necesidad de manejar números extremadamente grandes o pequeños, como los que aparecen en cálculos balísticos o en simulaciones físicas. El sistema estándar IEEE 754 y la integración de unidades de punto flotante en los procesadores facilitaron que se lograran resultados precisos y eficientes, modificando radicalmente el desarrollo tecnológico posterior. Comprender las representaciones numéricas en los sistemas digitales, sus ventajas, limitaciones y el modo en que la computadora las interpreta es fundamental para quienes trabajan en áreas de programación, ingeniería y ciencias computacionales.