En la era digital, donde la inteligencia artificial (IA) avanza a pasos agigantados, la medición del progreso se vuelve crucial para definir cuál tecnología merece reconocimiento y cuáles contribuciones son verdaderamente innovadoras. Sin embargo, la popularidad de las plataformas de benchmarking—esos espacios donde se evalúan y comparan modelos de IA—ha revelado un fenómeno preocupante conocido como "La Ilusión del Ranking". Este fenómeno refiere a la distorsión de las clasificaciones que debería reflejar el avance genuino, pero en cambio puede fabricar una narrativa sesgada influida por tácticas estratégicas y desigualdades en el acceso a datos y recursos. Uno de los ejemplos más destacados de esta situación es Chatbot Arena, una plataforma que se ha posicionado como el epicentro para medir el rendimiento de los modelos de lenguaje a través de enfrentamientos directos evaluados por usuarios humanos. En teoría, la metodología es sencilla y transparente: dos modelos generan respuestas a un mismo prompt, los usuarios seleccionan la mejor y así se determina un ranking.

La realidad es mucho más compleja. Investigaciones recientes han desenmascarado que detrás de esta aparente objetividad, existen mecanismos que generan ventajas injustas y que comprometen la neutralidad esperada de estos sistemas. La dinámica de pruebas privadas y la posibilidad de retractación posterior forman uno de los principales desafíos. Algunos proveedores de modelos, por ejemplo, logran ingresar múltiples variantes de sus creaciones en escenarios privados para probar y perfeccionar sin la presión pública, eligiendo después solo mostrar sus mejores versiones. Esto no solo eleva artificialmente su posición en la tabla sino que dificulta la responsabilidad y transparencia del proceso.

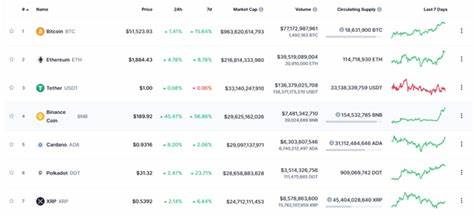

Contrariamente, aquellos que publican todas sus versiones o que poseen menos recursos para este tipo de pruebas quedan relegados, creando un campo de juego desigual que premia la persistencia en los ensayos más que la innovación real. Otra fuente significativa de sesgo surge de la concentración de datos y acceso limitado para ciertos actores. Los modelos propietarios dominan una parte sustancial de las disputas en Chatbot Arena, accediendo a gran parte del tráfico y datos generados en la plataforma. En contraste, laboratorios académicos y organizaciones sin fines de lucro disponen de una fracción diminuta, lo que representa una desventaja considerable. Este desequilibrio alimenta un círculo vicioso donde entrenar con más datos específicos de la plataforma significa mejorar resultados allí y, en consecuencia, consolidar posiciones en el ranking que parecen mostrar avances espectaculares, pero que en realidad reflejan una optimización localizada y no generalizable.

La disparidad en la exposición y la tasa de muestreo de los modelos también alimenta esta ilusión. Algunos modelos ostentan una tasa de exposición diaria mucho mayor, multiplicando sus oportunidades de ser evaluados y, por ende, de acumular victorias, mientras otros luchan por alcanzar el mínimo mínimo de visibilidad. Esto no solo perjudica la fiabilidad del ranking sino que perjudica la percepción pública y de inversionistas sobre qué tecnologías deben recibir atención y apoyo. Frente a estos hallazgos, expertos y académicos han propuesto una serie de lineamientos para restablecer la equidad en las mediciones y garantizar que el ranking funcione como un verdadero indicador de progreso tecnológico. Primero, la necesidad de prohibir las retiradas posteriores a la sumisión debe reforzarse para impedir que se oculten malos resultados y solo se presente la "mejor cara" de un modelo.

Igualmente importante es limitar el número de variantes que cada proveedor pueda probar simultáneamente en privado, para evitar un abuso de la plataforma que desvirtúe la competencia. Además, se propone que la eliminación de modelos en el ranking obedezca a reglas claras basadas exclusivamente en su rendimiento, buscando equilibrar la representación de diferentes tipos de modelos —propietarios, de código abierto o con pesos abiertos— asegurando que ninguno monopolice la tabla. Por último, implementar una estrategia de muestreo más justa, focalizada en examinar enfrentamientos menos evaluados o que presenten mayor incertidumbre estadística, ayudaría a construir una tabla más precisa y confiable. Estas recomendaciones no solo pretenden mejorar la justicia de la competencia sino transformar las plataformas de evaluación en verdaderos instrumentos al servicio de toda la comunidad de IA, donde el mérito técnico y la innovación genuina sean las principales fuerzas impulsoras y no el mayor presupuesto o el acceso privilegiado. Mirando hacia el futuro, la transformación de estos espacios de benchmarking podría contribuir a una democratización mucho mayor del desarrollo de inteligencia artificial, despejando el camino para colaboraciones más abiertas y competitivas.