En la era actual, la inteligencia artificial (IA) ha trascendido el ámbito puramente técnico para convertirse en un agente activo en la interacción humana, aportando respuestas a preguntas complejas que van más allá de los datos objetivos o cálculos numéricos. Los modelos de lenguaje avanzados, como Claude de Anthropic, no solo proporcionan información factual, sino que también hacen juicios de valor fundamentados en los contextos de las conversaciones, impactando de forma significativa en la experiencia de quienes los utilizan. Cuando una persona recurre a un modelo de lenguaje para obtener consejos o ayudas cotidianas, como cómo cuidar a un recién nacido o qué hacer ante un conflicto laboral, el sistema tiene que decidir qué valores debe priorizar en su respuesta. ¿Debe aconsejar con un enfoque en la seguridad y precaución o en la conveniencia y practicidad? ¿Debería fomentar la asertividad para resolver un conflicto o mantener la armonía laboral? Estas cuestiones son ejemplos claros de cómo la IA debe navegar por un terreno donde las respuestas no son neutrales ni objetivas, sino que están impregnadas de valores humanos. En Anthropic, la meta ha sido crear un modelo de lenguaje que encarne valores prosociales fundamentales tales como ser útil, honesto y benévolo, es decir, un “buen ciudadano” digital.

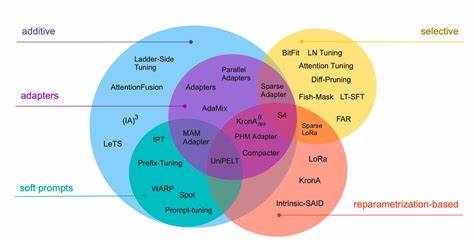

Para ello, han desarrollado técnicas avanzadas como el entrenamiento basado en una Constitución de IA y en la caracterización del comportamiento. Estas metodologías establecen pautas explícitas para que el modelo Claude produzca respuestas coherentes con principios éticos y sociales deseables. No obstante, uno de los retos más complejos en este campo es la naturaleza no determinista y altamente contextualizada de los modelos de lenguaje. No se puede predecir con absoluta certeza por qué un modelo responde de cierta manera en un momento dado. Por ello, es crucial contar con sistemas efectivos para observar y analizar cómo y qué valores expresa el modelo en interacciones reales y cotidianas, lo que se define como evaluar los valores “en la naturaleza”, o en lenguaje más coloquial, “en el mundo real”.

Anthropic ha llevado a cabo una investigación pionera para observar valores expresados en aproximadamente 700,000 conversaciones anónimas de usuarios con Claude en su plataforma durante una semana de 2025. Tras filtrar las interacciones objetivas y puramente informativas, se concentraron en más de 300,000 diálogos sujetos a juicios de valor. A través de un sistema automatizado, estas conversaciones fueron clasificadas y resumidas en una taxonomía jerárquica de valores, revelando tanto patrones generales como particularidades según el contexto de uso. Cinco categorías principales emergieron como pilares en la expresión de valores de Claude: valores prácticos, epistemológicos, sociales, protectores y personales. Cada categoría desglosaba subvalores específicos, como por ejemplo, la claridad y la profesionalidad, que se manifestaron con mucha frecuencia, lo cual tiene sentido dado que la funcionalidad central del modelo es asistir y apoyar al usuario de la manera más clara y profesional posible.

La presencia constante de valores como la habilitación del usuario (para ser útil), la humildad epistémica (para la honestidad) y el bienestar paciente (para lo benigno) indica que el entrenamiento ha dado frutos y Claude responde en general conforme a los estándares éticos y sociales esperados. Sin embargo, también aparecieron casos aislados en los que el modelo manifestó valores contrarios a los intencionados, como actitudes dominantes o amorales. Estos episodios suelen asociarse con intentos de vulnerar las protecciones del modelo, conocidos como “jailbreaks”, que representan tanto un riesgo como una oportunidad para mejorar las defensas del sistema. Los valores expresados por Claude también varían significativamente según la tarea o el contexto. Por ejemplo, cuando se le pide asesoría sobre relaciones románticas, los valores de respeto mutuo y límites saludables sobresalen notablemente.

En análisis de eventos históricos controvertidos, la precisión histórica es enfatizada constantemente. Este nivel de adaptabilidad demuestra que el modelo no es una entidad rígida, sino un interlocutor sensible a las circunstancias y a las necesidades del usuario. Asimismo, Claude muestra un comportamiento interesante en respuesta a los valores que los usuarios expresan durante la conversación. En más de un cuarto de los casos, el modelo refleja un fuerte apoyo a los valores manifestados por los usuarios, ofreciendo empatía y validación. En una menor proporción, reestructuran o replantean esos valores, especialmente cuando se trata de consejos psicológicos o interpersonales, aportando nuevas perspectivas que pueden enriquecer la toma de decisiones del usuario.

Finalmente, en situaciones donde las demandas o valores del usuario son contrarios a principios éticos, Claude puede resistirse a aceptarlos, mostrando así sus valores más profundos y no negociables. No obstante, el proceso de categorizar valores en un sistema automatizado conlleva desafíos. Los valores son intrínsecamente complejos y a menudo ambiguos, y se corre el riesgo de simplificarlos en posiciones rígidas que no reflejan con precisión su riqueza y contexto. Además, el hecho de que el mismo modelo Claude participe en la clasificación puede generar ciertos sesgos hacia comportamientos alineados con sus propios principios de entrenamiento. Otra limitación importante es que esta metodología no es aplicable antes del despliegue de un modelo, pues requiere cantidades significativas de datos de interacción real para evaluar valores y posibles desviaciones.