En el dinámico campo de la inteligencia artificial, los modelos de lenguaje grandes (LLMs) han transformado múltiples áreas, especialmente en la generación y síntesis de datos. Sin embargo, estos avanzados modelos a menudo requieren recursos computacionales masivos, son costosos y presentan desafíos ambientales significativos debido a su consumo energético. Recientemente, un innovador marco coordinado que involucra múltiples pequeños modelos de lenguaje ha emergido como una solución alternativa capaz de igualar el desempeño de los grandes LLMs en tareas complejas de síntesis de datos. El desarrollo y evolución de los LLMs han sido un motor clave para muchas aplicaciones modernas de inteligencia artificial, desde asistentes virtuales hasta sistemas avanzados de traducción y análisis semántico. El tamaño masivo y la capacidad de estos modelos, como se ha visto en variantes con decenas de miles de millones de parámetros, permiten generar datos de alta calidad y complejidad.

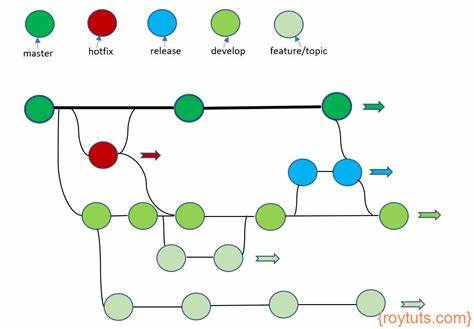

Sin embargo, el enfoque tradicional basado en un solo gran modelo enfrenta problemas reales como el elevado costo económico, el impacto ambiental y riesgos relacionados con sesgos incorporados en la arquitectura monolítica. Ante estos retos, la propuesta de un marco estratégico que coordina varios pequeños LLMs cobra especial relevancia. Inspirado en procesos humanos colaborativos, como la revisión por pares en la academia, este enfoque distribuye roles especializados entre diferentes pequeños modelos, asignándoles tareas específicas que contribuyen a un proceso iterativo y de control de calidad de los datos generados. Esta estrategia se denomina marco GRA, un acrónimo en inglés que refiere a los roles de Generador, Revisor y Adjudicador. El rol del Generador consiste en crear las muestras iniciales de datos, aprovechando la capacidad de los pequeños modelos para desarrollar soluciones diversas y creativas aunque limitadas en individualidad.

Luego, el Revisor se encarga de evaluar la calidad y variedad de esas muestras, detectando errores, inconsistencias o falta de diversidad, lo que agrega una capa de control y mejora. Finalmente, el Adjudicador interviene para resolver discrepancias y conflictos, tomando decisiones informadas que optimizan la salida final. Este ciclo colaborativo simula de manera efectiva la calidad de síntesis de un gran LLM, pero con un enfoque más sostenible y accesible. Al subdividir la tarea de síntesis en subprocesos manejados por agentes especializados, se logra no solo la paridad en la calidad de los datos, sino también ventajas en flexibilidad, escalabilidad y reducción del impacto ambiental. Los beneficios de este marco basado en pequeños LLMs son múltiples y significativos.

Primero, la disponibilidad de recursos para entrenar y ejecutar pequeños modelos es mayor, permitiendo a más desarrolladores e instituciones acceder a tecnología de alto nivel sin requerir infraestructura costosa. En segundo lugar, la modularidad del sistema permite una actualización y mantenimiento más sencillo, ya que cada componente puede desarrollarse y mejorarse de forma independiente. Además, al representar un enfoque menos centralizado, se reducen los riesgos inherentes a modelos monolíticos, tales como la amplificación de sesgos o fallos catastróficos en el procesamiento de datos. El proceso de revisión iterativa y adjudicación en el marco GRA genera datos más confiables y diversificados, mejorando así la robustez de los sistemas que dependen de esa información. En estudios recientes realizados sobre múltiples benchmarks, este marco de coordinación entre pequeños LLMs ha demostrado no solo alcanzar la calidad de síntesis generada por modelos grandes como Qwen-2.

5-72B-Instruct, sino en algunos casos superarla. Esto genera un impacto directo en la comunidad de inteligencia artificial, planteando un cambio de paradigma en la forma en que se aborda la generación de datos sintéticos y el desarrollo de modelos eficientes. El papel de la colaboración en sistemas artificiales, inspirado en dinámicas humanas, se vuelve cada vez más relevante frente a la creciente complejidad de los retos tecnológicos. Este modelo nos invita a repensar la dependencia de sistemas masivos únicos, apostando por la integración y coordinación de agentes más pequeños que juntos suman capacidades potentes. Implementar este marco en aplicaciones reales también abre la puerta a nuevas posibilidades en términos de personalización y adaptación a contextos específicos.

Por ejemplo, pequeños LLMs especializados en dominios particulares pueden colaborar para sintetizar datos altamente relevantes y adaptados, superando las limitaciones que enfrentan grandes modelos generalistas. Además, el menor consumo energético y la reducción de costos vinculados con los pequeños modelos tienen beneficios directos para la sostenibilidad tecnológica y la democratización del acceso a inteligencia artificial avanzada. Instituciones educativas, pequeñas empresas y proyectos independientes pueden aprovechar esta metodología para avanzar en sus propuestas sin depender de recursos concentrados en pocas grandes corporaciones. Esta innovación también plantea preguntas interesantes sobre la evolución futura de los LLMs y la inteligencia colectiva en sistemas artificiales. La coordinación estratégica entre agentes especializados podría ser la clave para construir sistemas más inteligentes, flexibles y resilientes, capaces de evolucionar y adaptarse en entornos cambiantes.