El color es una experiencia fundamental que influye en cómo interpretamos el mundo que nos rodea. Sin embargo, lo que vemos no es simplemente un hecho natural, sino una construcción compleja que implica la interacción entre la luz, nuestros ojos, nuestro cerebro y la tecnología que utilizamos para capturar y mostrar imágenes. Comprender cómo los humanos perciben el color y cómo los dispositivos digitales trabajan con esta información es clave para crear imágenes que se vean fieles y consistentes en múltiples plataformas. En este sentido, los modelos y espacios de color se convierten en herramientas esenciales para manejar esta comunicación entre la percepción humana y las máquinas. Desde el momento en que la luz entra en nuestro ojo hasta que una imagen se muestra en un monitor, ocurre un proceso fascinante y cargado de detalles técnicos y biológicos.

La luz que emite una pantalla está compuesta por diferentes longitudes de onda, las cuales son interpretadas por los receptores de nuestro ojo llamados conos. Tenemos tres tipos de conos, cada uno sensible a distintas gamas de colores: los conos S responden al azul, los conos M al verde y los conos L al rojo. Este mecanismo tricromático es el fundamento más básico de nuestra percepción del color. A pesar de que el ojo humano es sorprendentemente sofisticado, nuestra percepción del color no es perfecta ni absoluta. En realidad, los colores son una interpretación que nuestro cerebro hace de diferentes combinaciones de longitudes de onda.

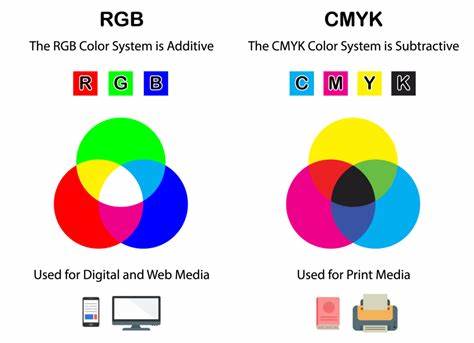

Por ejemplo, cuando vemos el color blanco, en realidad es porque varias longitudes de onda están presente en proporciones que nuestro cerebro interpreta de esa forma. No existen colores inherentes en la luz, sino señales que nuestros sentidos y nuestro sistema nervioso procesan para darnos la experiencia del color. Para representar estos colores mediante dispositivos electrónicos, que no tienen la capacidad biológica humana, es necesario utilizar modelos matemáticos y espacios de color que traduzcan estas experiencias sensoriales en datos numéricos. Uno de los modelos más conocidos y usados es el RGB, que se basa en la percepción de rojo, verde y azul y que se utiliza en la mayoría de pantallas y cámaras digitales. Cada color dentro de este modelo se genera combinando diferentes niveles de intensidad de estos tres colores básicos.

Sin embargo, el modelo RGB tiene limitaciones, principalmente porque está ligado a dispositivos específicos cuyas características pueden variar. Por ejemplo, el tono exacto de rojo en una pantalla puede diferir del rojo que una cámara captura o del rojo que otra pantalla muestra. Esto se debe a que cada dispositivo tiene su propio espacio de color, es decir, un rango específico de colores que puede reproducir. Para garantizar coherencia visual, se utilizan perfiles de color que ayudan a mapear el color capturado o creado en un dispositivo a la apariencia que debería tener en otro. Uno de los estándares universales más importantes desarrollados para resolver estos problemas es el espacio XYZ, creado por la Comisión Internacional de Iluminación (CIE).

A diferencia del RGB, el espacio XYZ es independiente del dispositivo y se basa en experimentos científicos con observadores humanos promedio. Este espacio permite definir todos los colores que un ojo humano puede percibir y actúa como intermediario cuando se traducen colores de un dispositivo a otro. Aun así, el espacio XYZ no es perfecto para tareas prácticas como el almacenamiento de imágenes o los cálculos de procesamiento digital debido a que no representa de manera fiel la distancia perceptual entre colores; es decir, dos colores pueden estar muy cerca en los valores numéricos pero verse muy diferentes para los humanos, o viceversa. Aquí es donde entra en juego el espacio CIE L*a*b*, también desarrollado por la CIE, que intenta representar los colores de manera que la distancia entre dos puntos en este espacio refleje la diferencia perceptual que un humano percibiría entre esos colores. El espacio L*a*b* separa la información en tres componentes: L* representa la luminosidad o claridad de un color, mientras que a* y b* representan los ejes de color que cubren el espectro rojo-verde y azul-amarillo, respectivamente.

Esta separación es clave para aplicaciones profesionales donde es imprescindible medir y reproducir colores con precisión, como en diseño gráfico, impresión o fotografía. En términos de video e imágenes digitales, otro modelo muy relevante es el YUV, que se utiliza especialmente en compresión y transmisión de video. En este sistema, Y representa la luminancia, o la información de brillo, mientras U y V transportan la información cromática (los matices de color). Dado que la visión humana es más sensible a cambios en brillo que en color, separar estos componentes permite optimizar la compresión y mejorar la calidad visual percibida. Un aspecto fundamental que vincula la percepción humana y la representación digital es la corrección gamma.

La forma en que nuestros ojos perciben la intensidad de la luz no es lineal, sino que se parece más a una curva logarítmica. Por ende, escribir los valores de color sin tener en cuenta esta característica provocaría que las imágenes se vean demasiado oscuras o demasiado claras en ciertas regiones. Para solucionar esto, los sistemas digitales aplican una transformación matemática llamada corrección gamma que ajusta los valores para que coincidan mejor con la percepción humana. El espacio sRGB, el más común en la web y en multitud de dispositivos, incorpora esta corrección gamma para optimizar la representación del color en pantallas estándar. Sin embargo, incluso los modelos como sRGB tienen limitaciones, especialmente cuando hablamos de dispositivos o aplicaciones que requieren un rango más amplio de colores y luminosidades, como los contenidos de alta definición o el procesamiento de imágenes en fotografía profesional.

Para esas necesidades, las tecnologías de alto rango dinámico (HDR) y los nuevos formatos de imagen han empezado a desplegarse. Estos permiten capturar y mostrar imágenes con una gama más amplia de colores y niveles de brillo, tal como lo percibe el ojo humano en condiciones reales y variadas. No obstante, para que estas imágenes se muestren correctamente, todos los elementos del flujo — desde la captura en la cámara, pasando por el procesamiento, hasta la pantalla— deben ser compatibles y trabajar sincronizados para preservar la intención visual original. El desafío de la uniformidad y la coherencia del color sigue siendo un campo de investigación activa y un área crítica para la industria tecnológica, el arte digital y la comunicación visual. La capacidad para adaptar y convertir colores entre diferentes espacios mediante perfiles de color y transformaciones estandarizadas es vital para evitar sorpresas desagradables, como fotos mal representadas, videos con tonos extraños o impresiones que no reflejan fielmente la imagen digital original.

Finalmente, también es importante considerar que la percepción del color no es idéntica para todas las personas ni en todas las condiciones ambientales. Factores como la iluminación, el contexto visual, las adaptaciones fisiológicas del ojo, y variaciones individuales influyen en cómo percibimos los colores. Los modelos de color, aunque precisos y sofisticados, buscan representar un promedio generalizado para facilitar la interoperabilidad entre humanos y dispositivos. La magia del color sigue residiendo en la interacción compleja y sutil entre la luz, la mente y la tecnología. En resumen, comprender los modelos de color y espacios como RGB, XYZ, L*a*b*, sRGB y YUV, así como los procesos adicionales como la corrección gamma y la gestión de perfiles, es crucial para garantizar que las imágenes digitales se vean coherentes, vibrantes y fieles a la realidad, sin importar dónde o cómo se visualicen.

En un mundo cada vez más digital visual, este conocimiento no solo beneficia a técnicos y científicos, sino también a diseñadores, artistas y usuarios finales que desean que su experiencia visual sea la mejor posible.