La irrupción de la inteligencia artificial (IA) ha revolucionado la forma en que las empresas conciben sus productos, servicios y procesos internos. En este contexto, la velocidad y la innovación son requisitos clave para mantenerse competitivos. Sin embargo, esta prisa ha llevado a muchas organizaciones a caer en una trampa peligrosa: la entrega indiscriminada de sus datos a proveedores externos sin una estrategia sólida de gobernanza y control. A este fenómeno se le ha denominado la "trampa de la entrega de datos" y expone a las empresas a numerosos riesgos de cumplimiento, seguridad y deuda técnica. El problema radica en que la mayoría de las compañías, bajo presión para implementar rápidamente capacidades de IA generativa o analítica avanzada, optan por soluciones turnkey en las que simplemente cargan sus datos en un proveedor externo y consumen APIs para lanzar funcionalidades nuevas.

Esta solución inmediata puede parecer eficaz a corto plazo, pero la realidad es que genera un impacto nocivo a largo plazo. Cuando los datos valiosos—especialmente aquellos relacionados con clientes, operaciones o información sensible—salen del perímetro de la empresa, se pierde la visibilidad directa sobre dónde se almacenan, cuánto tiempo permanecen, quién tiene acceso y cómo se utilizan. Esta pérdida de control tiene implicaciones legales de gran alcance. Cumplir con regulaciones estrictas como el GDPR europeo, HIPAA en el sector salud o incluso políticas internas propias, se vuelve difícil de garantizar si la empresa no tiene dominio absoluto sobre sus datos. Una simple configuración errónea o una cláusula en los contratos de entrenamiento de modelos pueden vulnerar normativas, exponiendo a la organización a multas, sanciones, pérdidas reputacionales e incluso demandas.

Además del riesgo para la gobernanza, la entrega de datos sin un diseño adecuado genera una deuda técnica significativa. Las arquitecturas que surgen de esta práctica a menudo presentan una alta dependencia con el proveedor, acoplamientos rígidos en esquemas de datos, procesos y controles de seguridad que dificultan migrar a otras plataformas en el futuro o responder ágilmente a cambios regulatorios o de negocio. El mantener sincronizados datos fragmentados entre varios proveedores y sistemas internos añade complejidad y eleva el margen de error y las inconsistencias. Ante este panorama, los arquitectos de datos empresariales han venido definiendo mejores prácticas que invierten la lógica tradicional: en lugar de mover datos hacia la IA, buscan llevar la IA hacia los datos. Esta filosofía se basa en cuatro pilares fundamentales que actúan como guardarraíles para garantizar seguridad, gobernanza y flexibilidad a largo plazo.

El primer pilar es el almacenamiento abierto e in situ. Evitar formatos propietarios y permitir una migración fluida entre distintos proveedores cloud o entornos on-premises es clave para no quedar atrapados en plataformas específicas. Formatos open source como Delta Lake, Apache Iceberg o Parquet proveen tablas columnar con garantías ACID y son compatibles con múltiples motores de procesamiento, facilitando interoperabilidad. En segundo lugar, la capa unificada de gobernanza es esencial. Centralizar permisos de acceso a nivel de tabla, fila o columna, registrar la trazabilidad de consultas y cambios, y aplicar políticas dinámicas de enmascaramiento o filtrado permiten otorgar accesos muy precisos y auditables.

Herramientas como Apache Ranger, Open Policy Agent o Unity Catalog aportan esta capacidad crucial para la gestión continua y cumplimiento normativo. Un tercer pilar son los mecanismos de compartición de datos sin copia (zero-copy sharing). En lugar de enviar archivos CSV o duplicar datasets, el compartir se realiza mediante protocolos abiertos y seguros como Delta Sharing, el catálogo REST de Iceberg o Arrow Flight SQL. Este método permiten conceder acceso en tiempo real a tablas vivas con permisos revocables al instante, eliminando riesgos asociados a réplicas no controladas. Finalmente, la integración completa del ciclo de vida del modelo —desde entrenamiento hasta registro y despliegue— dentro del perímetro gobernado asegura que cada predicción pueda ser trazada hasta sus fuentes de datos originales y código fuente, garantizando transparencia y capacidad de auditoría.

Plataformas que incorporan esta integración facilitan la experimentación rápida sin sacrificar la seguridad. Entre las soluciones que cumplen con estos cuatro guardarraíles destaca Databricks con su arquitectura Lakehouse. Esta plataforma combina Delta Lake para gestionar tablas ACID directamente sobre los buckets de almacenamiento propios de AWS, Azure o Google Cloud; Unity Catalog para aplicar políticas de acceso multinube; Delta Sharing para compartir datos sin duplicados en tiempo real y MosaicML junto con servicios de modelado integrados para entrenar y servir modelos sin que los datos salgan del entorno controlado. Gracias a estas capacidades, las organizaciones que utilizan Databricks mantienen la residencia y cifrado de sus datos bajo sus propias cuentas cloud y VPCs, alejándose del paradigma tradicional donde la capa de control y datos se alojan en cuentas gestionadas por los proveedores. Esto no solo reduce la superficie de riesgo sino que facilita la soberanía y auditoría sobre los activos de información.

Si bien otros grandes proveedores cloud como AWS, Google Cloud, Azure o servicios como Snowflake ofrecen soluciones con características similares, la diferencia clave radica en el nivel de apertura y flexibilidad para evitar el bloqueo del ecosistema y la capacidad real de operar en entornos multicloud o híbridos. Cada uno presenta sus ventajas y limitaciones, pero la apuesta por formatos abiertos y protocolos estandarizados es la garantía que asegura una estrategia sostenible y adaptable ante la evolución tecnológica y regulatoria. Para las empresas que desean implementar estas mejores prácticas, es fundamental seguir un proceso detallado y progresivo. Primero es indispensable hacer un inventario exhaustivo y clasificación rigurosa de los datos, identificando información sensible, datos regulados, y anotando la base legal para su uso según la legislación aplicable. Sin este paso, aplicar políticas de menor privilegio y compartir datos de forma selectiva es muy complicado.

Seguidamente, se recomienda migrar todos los datasets a formatos abiertos y gobernados, con esquemas estrictos y almacenamiento cifrado y protegidos con bloqueos de objetos para evitar modificaciones no autorizadas. Activar catálogos unificados que integren el control de acceso, incluyendo máscaras de columnas, filtros de fila y etiquetado dinámico, simplifica la tarea de gestionar políticas homogéneas en todas las herramientas que acceden a los datos. En paralelo, es crucial reforzar el perímetro técnico con redes privadas, reglas de firewall para almacenamiento y limitar computación accesible solo a nodos aprobados, cerrando puertas a movimientos inadvertidos o transferencias no autorizadas. La erradicación de buckets públicos y salida no controlada de datos fortalece la defensa contra fugas. Al compartir datos externamente con proveedores de IA, lo esencial es minimizar la exposición entregando solo lo estrictamente necesario, ya sea con agregados, pseudonimización o eliminación de columnas irrelevantes.

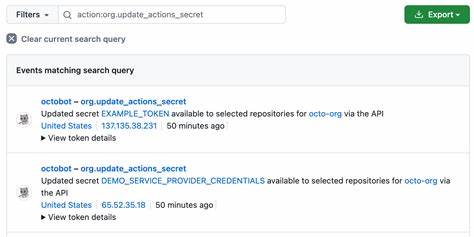

La creación de "shares" con tokens con tiempo de vida limitado, restricciones por dirección IP y monitoreo en tiempo real de consultas asegura que el acceso se pueda revocar inmediatamente en caso de finalización o incumplimiento. Por último, migrar los pipelines internos de aprendizaje automático a un entorno gobernado e integrado con modelos registrados y controlados evita la dispersión por exportaciones a entornos inseguros y facilita el cumplimiento normativo. Exponer endpoints de predicción bajo controles estrictos y registro permanente de accesos completa el ciclo de supervisión robusta. Automatizar auditorías periódicas y detección de desviaciones es un paso avanzado que no debe omitirse. Alertas sobre datos sin etiquetar, vigencia próxima de tokens autorizados o el entrenamiento con datos no clasificables permiten reaccionar rápido ante riesgos emergentes, manteniendo los guardas enfocados y efectivos.

En definitiva, la llamada trampa de la entrega de datos es un error común pero evitable. La capacidad de mover modelos y capacidades de IA hacia los datos bajo estándares abiertos y gobernanza integrada no solo preserva la seguridad, sino que acelera la innovación al eliminar demoras en transferencias, minimizar riesgos regulatorios y facilitar la evolución tecnológica constante. Las empresas que adopten esta estrategia estarán mejor posicionadas para aprovechar cada avance en inteligencia artificial como un complemento ágil y seguro dentro de su infraestructura de datos, evitando cargas técnicas y legales innecesarias, y manteniendo la confianza de sus clientes y socios. En un mundo donde la información es el activo más valioso, no entregar las llaves de los datos sino traer la IA al entorno controlado se convierte en la única forma sostenible y rentable de competir en la fiebre del oro digital.