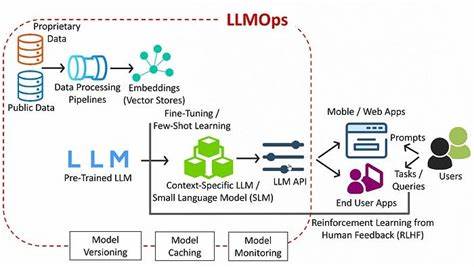

En la era digital actual, los grandes modelos de lenguaje (LLM) están transformando la forma en que interactuamos con la tecnología, impulsando aplicaciones que van desde asistentes virtuales hasta traducción automática y generación de contenido. Sin embargo, la complejidad inherente a estos modelos y la necesidad de infraestructura robusta plantean un desafío considerable para los ingenieros de sistemas que buscan implementar y servir estos modelos de manera eficiente. Tiny-LLM emerge como una respuesta innovadora, ofreciendo un curso y una aproximación práctica para servir LLM en dispositivos Apple Silicon, un ecosistema cada vez más presente y potente. El proyecto Tiny-LLM se presenta como una iniciativa en desarrollo, diseñada específicamente para que ingenieros de sistemas puedan desentrañar y construir la infraestructura para servir modelos de lenguaje grandes desde cero. A diferencia de muchas soluciones comerciales o frameworks de alto nivel que ocultan detalles técnicos bajo interfaces simplificadas, Tiny-LLM se basa casi íntegramente en las APIs de arreglos y matrices de MLX.

Esta elección no es casualidad, ya que permite a los usuarios entender las bases matemáticas y computacionales, optimizando cada paso y proceso de la cadena de servicio. Una de las motivaciones principales para desarrollar Tiny-LLM es la accesibilidad al entorno de desarrollo. En lugar de depender de configuraciones complejas basadas en GPUs NVIDIA, que requieren hardware específico y cierto nivel de experticia, Tiny-LLM apuesta por macOS y Apple Silicon, plataformas que son cada vez más comunes y amigables para desarrolladores. Los chips de Apple, con arquitecturas altamente eficientes y optimizadas, permiten realizar inferencia y servir modelos con desempeño competitivo, aprovechando tecnologías como Metal para procesamiento paralelo y aceleración gráfica. El modelo ejemplar en Tiny-LLM es Qwen2, un LLM que ha ganado relevancia por su efectividad y soporte en proyectos de código abierto.

Qwen2 se posiciona como el ejemplo paradigmático para entender las técnicas esenciales que Tiny-LLM busca enseñar. A través de este enfoque, los ingenieros no solo aprenden a desplegar modelos, sino también a implementar temporalmente estructuras críticas como la atención (attention), normalización RMS, capas MLP y esquemas de generación de texto. Desde conceptos fundamentales hasta técnicas avanzadas, Tiny-LLM ofrece un roadmap estructurado para acompañar al aprendiz en el dominio completo del servicio de LLM. El curso Tiny-LLM se organiza en semanas y capítulos, progresando desde la comprensión y codificación del núcleo matemático —como la atención clásica y mecanismos de rotación posicional— hasta optimizaciones especializadas en hardware. Por ejemplo, se enseña la implementación de atención grupal, que permite una mejor manipulación de consultas simultáneas, así como técnicas para manejar caches de claves y valores que mejoran la eficiencia al generar respuestas continuas.

El objetivo es cubrir todo el ciclo, desde la carga del modelo, la generación de texto, hasta temas más avanzados como decodificación especulativa y paralelismo para escalar la infraestructura. La comunidad alrededor de Tiny-LLM también desempeña un papel fundamental. A través de plataformas como Discord, los usuarios pueden interactuar con el creador, skyzh, y otros entusiastas que comparten conocimiento, consejos y avances. Este espacio colaborativo es especialmente valioso para ingenieros que deseen profundizar y resolver desafíos técnicos de forma colectiva, generando un ecosistema donde la innovación y el aprendizaje convergen. Desde la perspectiva técnica, Tiny-LLM destaca por evitar la dependencia de frameworks de alto nivel que abstraen excesivamente la lógica de los modelos.

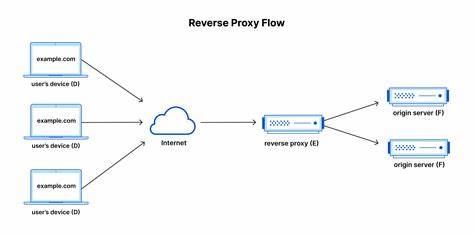

Al trabajar directamente con MLX, que es una librería diseñada para manipulación eficiente de tensores y operaciones matriciales en Apple Silicon, los desarrolladores aprenden a controlar la eficiencia y el costo computacional de cada operación neural, lo cual es crucial para proyectos que deben funcionar en entornos con recursos limitados o para maximizar el rendimiento en hardware específico. El proyecto también está en constante evolución, con varios hitos alcanzados y otros en desarrollo. Las primeras fases han consolidado funcionalidades básicas con código robusto y tests completos, tales como los bloques transformer y mecanismos de atención. Sin embargo, hay avances pendientes que incorporarán mayor paralelismo, uso de mecanísmos Mixture of Experts (MoE), y estrategias de batching para optimizar el rendimiento en escenarios de múltiples usuarios o cargas variables. La elección de Apple Silicon como plataforma principal no solo responde a la facilidad de acceso y despliegue, sino también a la eficiencia energética y la integración en el ecosistema macOS, que es ampliamente preferido en sectores de desarrollo tecnológico por su estabilidad y soporte.

La compatibilidad con Metal, junto con la arquitectura ARM de Apple, permite una optimización de bajo nivel sin sacrificar la portabilidad, lo que abre puertas para que sistemas distribuidos puedan incorporar dispositivos Apple como nodos de inferencia LLM. Otro aspecto innovador de Tiny-LLM es la enseñanza de la cuantización y optimización de operaciones matriciales para CPU y GPU, lo cual es fundamental para disminuir la huella computacional sin perder calidad en las respuestas generadas. Estas técnicas permiten que modelos originalmente muy pesados puedan funcionar de forma más fluida en hardware accesible, democratizando el uso de LLM en aplicaciones reales. Además, la guía enfatiza el entendimiento conceptual detrás de cada implementación. Por ejemplo, al abordar la atención escalable, Tiny-LLM no solo muestra cómo se codifica, sino también qué problemas resuelve y cómo afecta el rendimiento y la calidad del output.

Esto fortalece la capacidad crítica del ingeniero de sistemas para adaptar y mejorar la infraestructura según requerimientos específicos de proyecto o hardware. La documentación oficial y el material didáctico están alojados en una plataforma accesible, con explicaciones paso a paso, código abierto disponible para revisión e inclusión en proyectos propios, y una comunidad que actualiza continuamente las mejores prácticas. Este enfoque abierto invita a la colaboración y al aprendizaje conjunto, que son fundamentales en un campo que evoluciona tan rápidamente como el de la inteligencia artificial. Algunos desafíos y temas futuros en Tiny-LLM incluyen el soporte para caches de claves y valores cuantizados, esquemas avanzados de muestreo para generación de texto, entrenamiento fino de modelos, y la integración de agentes inteligentes que puedan interactuar con herramientas externas para potenciar sus capacidades. Estos aspectos marcan un horizonte prometedor, manteniendo a Tiny-LLM en la vanguardia del estudio y servicio práctico de modelos de lenguaje.

En resumen, Tiny-LLM es una propuesta excepcional para ingenieros de sistemas que desean dominar el servicio de grandes modelos de lenguaje en Apple Silicon con un enfoque práctico, detallado y altamente optimizado. Al evitar buscar soluciones prefabricadas y apostar por el entendimiento profundo y la construcción desde cero, Tiny-LLM prepara a los profesionales para enfrentar los retos técnicos actuales y futuros en el campo de la inteligencia artificial aplicada. Para quienes busquen adentrarse en esta área, Tiny-LLM representa una oportunidad única: aprovechar el poder de Apple Silicon para aprender, construir y servir LLMs de manera eficiente y escalable, todo dentro de una comunidad activa y en crecimiento. La evolución constante del proyecto promete seguir ofreciendo herramientas, técnicas y conocimiento indispensable para que ingenieros y desarrolladores sean protagonistas en la revolución de la inteligencia artificial.