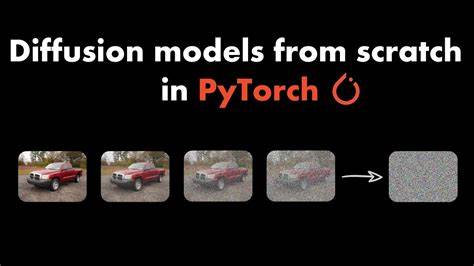

En el campo de la inteligencia artificial, los modelos de difusión han emergido como una de las tecnologías más prometedoras para la generación de imágenes, video y otros tipos de datos sintéticos con alta calidad. Diffulab es una biblioteca abierta que llega para simplificar y potenciar el entrenamiento desde cero de estos modelos, ofreciendo a desarrolladores e investigadores una herramienta robusta, personalizable y fácil de usar. Esta solución se convierte en un activo importante para los entusiastas que buscan entender y avanzar en las técnicas más avanzadas en aprendizaje profundo aplicado a la generación de contenido. Diffulab nace con la propuesta de proporcionar una estructura limpia y modular que permita no solo entrenar modelos de difusión clásicos, sino también experimentar con distintas arquitecturas y formalizaciones. La biblioteca está creada para quienes desean tener un control total sobre cada componente del entrenamiento, desde la arquitectura de la red neuronal que se empleará, pasando por la formalización matemática del proceso de difusión, hasta el método exacto para inferir nuevos datos a partir del modelo entrenado.

Una de las fortalezas de Diffulab es su compatibilidad con distintas arquitecturas tradicionales y novedosas como U-Net y DiT. Estas redes neuronales son fundamentales para que el modelo aprenda a reconstruir datos complejos a partir de ruido, base del funcionamiento en modelos de difusión. Además, la biblioteca soporta formalizaciones variadas que incluyen procesos ampliamente conocidos en la literatura como DDPM (Denoising Diffusion Probabilistic Models), Rectified Flow y EDM (Elucidated Diffusion Models). Esta diversidad facilita que usuarios puedan experimentar con múltiples enfoques para encontrar el más adecuado a sus necesidades. La flexibilidad de Diffulab también se extiende al proceso de inferencia, es decir, la manera en la que el modelo genera nuevos ejemplos o datos a partir del conocimiento adquirido.

La biblioteca contempla distintos samplers o métodos muestreadores, lo que permite seleccionar el más eficiente o el que mejor se adapte a la calidad o velocidad deseada en la generación de contenido. El proyecto todavía está en una etapa incipiente, pero su potencial es enorme. La comunidad de desarrolladores está invitada a colaborar, ya sea reportando errores, creando implementaciones nuevas o mejorando las funcionalidades existentes. Entre sus futuras metas destacan incluir adaptadores de modelos que permitan realizar ajustes finos mediante técnicas como LoRA (Low-Rank Adaptation), y la integración de inyecciones de características para escenarios específicos. Estas funcionalidades ampliarán el espectro de aplicaciones de Diffulab, haciéndola aún más potente para fines profesionales o académicos.

Para quienes desean comenzar a utilizar Diffulab, el proceso es accesible. La instalación se facilita mediante Astral UV, un gestor de paquetes moderno, y los usuarios solo requieren clonar el repositorio oficial, sincronizar dependencias y proceder a la instalación editable. Una vez instalado, la plataforma utiliza Hydra para gestionar configuraciones complejas, haciendo viable la personalización sin necesidad de modificar directamente el código base. Este nivel de control permite a los investigadores replicar experimentos y adaptar parámetros a sus modelos con comodidad. Diffulab recomienda configurar la herramienta accelerate antes de iniciar el entrenamiento para optimizar la gestión de recursos computacionales.

Las configuraciones predeterminadas y ejemplos disponibles en el repositorio oficial sirven como guía para usuarios novatos e intermedios, facilitando así la ejecución rápida de sesiones de entrenamiento sobre distintos datasets, desde los más simples a los de mayor complejidad. La comunidad técnica puede además contribuir a la mejora continua de la biblioteca, colaborando en la expansión de funciones como el soporte para mixed precision training, que es fundamental para aprovechar las capacidades de hardware modernas y acelerar el proceso sin perder precisión en los resultados. También está en desarrollo la implementación de algoritmos más avanzados para la optimización del muestreo, como Euler y Heun, que buscan obtener un buen equilibrio entre rapidez y calidad en la generación de muestras. Diffulab también abre la puerta al entrenamiento de modelos condicionados y la aplicación de técnicas de difusión en espacios latentes, integrando variational autoencoders para mejorar la eficiencia del proceso. Este enfoque es clave para tareas como la generación condicional o la edición de imágenes, que requieren manipular características abstractas en lugar de datos en formato bruto.

La posibilidad de experimentar con diferentes parametrizaciones del loss function en DDPM, incluyendo parámetros como epsilon, x0, y v, además del aprendizaje de la varianza, contribuye a mejorar la representación y la estabilidad del modelo durante su entrenamiento. Estas opciones amplían el arsenal disponible para investigadores que buscan optimizar la generación y el aprendizaje. Uno de los aspectos más atractivos de Diffulab es que pone al alcance de la comunidad los últimos avances en modelos de difusión, siguiendo las recomendaciones y técnicas más innovadoras, incluidos los aportes destacados de grandes empresas como NVIDIA, que han publicado investigaciones fundamentales para repensar la forma en que se entrenan estos modelos. La acumulación de estas lecciones se traduce en un proyecto que, aunque joven, está diseñado para evolucionar rapidamente. En definitiva, Diffulab es una propuesta que combina accesibilidad, poder técnico y flexibilidad para todo aquel interesado en modelar y entrenar sistemas de difusión desde cero.

Su enfoque modular y abierto la convierte en una plataforma ideal para experimentar, innovar y aprender en un campo que continua transformando la capacidad creativa de la inteligencia artificial. Para investigadores, desarrolladores y profesionales que busquen construir o personalizar modelos generativos de última generación, Diffulab presenta un ecosistema robusto que promete acelerar investigaciones y aplicaciones en áreas tan diversas como la generación de imágenes, análisis de datos sintéticos, simulación y más. La invitación es a explorar, contribuir y aprovechar este recurso que apuesta por democratizar uno de los avances más revolucionarios en el mundo del aprendizaje automático.

![Tiny technology – Philip Morrison's 1968 Christmas Lectures [video]](/images/B11CA47B-BA68-4C81-B5F7-94472B86E335)