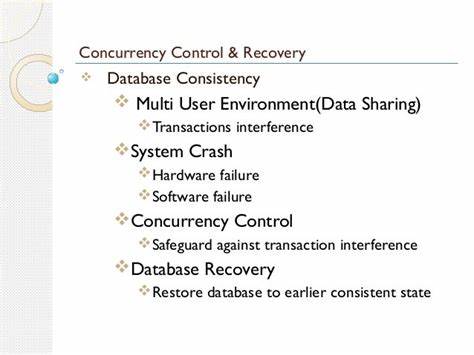

El control de concurrencia y la recuperación de datos son piedras angulares en el diseño y operación de sistemas de bases de datos confiables y eficientes. Estas temáticas, analizadas desde una perspectiva histórica y técnica, definen cómo múltiples transacciones pueden ejecutarse simultáneamente sin comprometer la integridad de los datos y cómo los sistemas pueden recuperarse de fallos inesperados para garantizar la durabilidad y consistencia de la información. El libro "Concurrency Control and Recovery in Database Systems", publicado en 1987 por Bernstein, Hadzilacos y Goodman, ofrece una visión clara y pionera de estos desafíos en un momento en que aún no existían soluciones sólidas y ampliamente aceptadas para aspectos como la recuperación. En aquella época, conceptos como el registro anticipado para escritura (write-ahead log) y el esquema ARIES, que revolucionarían la recuperación de bases de datos en la década siguiente, aún no se habían consolidado. El prefacio del libro sitúa al lector en un contexto tecnológico anterior a eventos cruciales como la caída del Muro de Berlín y el lanzamiento de Windows 3.

1, destacando que el estado del arte aún estaba en desarrollo. En consecuencia, la estructura del texto refleja una organización lógica que agrupa los temas en control de concurrencia (capítulos 1 a 5), recuperación (capítulos 6 y 7), y finalmente un capítulo dedicado a la replicación, que anticipaba futuros retos en bases de datos distribuidas. Este ordenamiento temático responde a la prioridad que se le dio en ese tiempo a comprender y asegurar que múltiples accesos simultáneos a los datos se realizaran con corrección y integridad. El control de concurrencia ofrece las técnicas para manejar esta simultaneidad evitando conflictos y inconsistencias, mientras que la recuperación garantiza que, frente a errores o fallos del sistema, las transacciones mantengan propiedades fundamentales como atomicidad y durabilidad. El capítulo primero del libro, titulado "El Problema", plantea la motivación fundamental que justifica el estudio riguroso de estas áreas.

Partiendo de una óptica operacional, se define el comportamiento correcto que debe exhibir una transacción desde el punto de vista del usuario, centrando la atención en los historiales de lecturas y escrituras en lugar del estado estático del sistema. Esto es crucial para entender cómo las operaciones de distintos usuarios pueden interferir entre sí y qué mecanismos requiere el sistema para preservar la coherencia. Entre los conceptos fundamentales se encuentran la serializabilidad, que asegura que el efecto global de una serie de transacciones concurrentes sea equivalente a alguna secuencia ordenada sin solapamientos; la capacidad de commit o abort para indicar la finalización exitosa o la reversión total de una transacción; y los problemas que pueden surgir, tales como abortos en cascada y pérdidas de actualizaciones. En aquel tiempo, la implementación dominante era el uso del bloqueo estricto de dos fases (2PL), que regulaba el acceso a recursos con bloqueos que debían ser adquiridos y liberados en fases específicas para evitar conflictos. Esta técnica, aunque eficaz, presentaba limitaciones de rendimiento y complejidad, además de suscitar debates sobre su impacto en la escalabilidad y la concurrencia.

La ausencia de modelos multiversión, que en la actualidad permiten lecturas consistentes sin bloqueos rígidos, también marcaba la realidad técnica. Bajo un esquema de versión única, la deshacer (undo) de operaciones se manejaba con un nivel de detalle significativo para garantizar la integridad en caso de abortos. Esto implicaba costos de almacenamiento y cómputo notables, que hoy se mitigan gracias a mejoras en hardware y algoritmos. El capítulo concluye con la presentación de un modelo interno de sistema de base de datos dividido en cuatro componentes principales. El gestor de transacciones (TM) actúa como intermediario entre las operaciones de los usuarios y el sistema, enviando solicitudes al planificador (scheduler) para controlar la concurrencia.

Este planificador es responsable de garantizar la serializabilidad y a menudo la estricta adherencia al orden, decidiendo si retrasar, ejecutar o rechazar operaciones. El gestor de recuperación (RM) vela por las propiedades de atomicidad y durabilidad, gestionando el almacenamiento persistente mediante operaciones de lectura y escritura coordinadas con el gestor de caché (CM), que se encarga del movimiento de datos entre memoria volátil y almacenamiento estable. Esta comunicación se basa en un modelo minimalista de interacción por señales, donde cada módulo espera confirmaciones antes de proceder, lo que mantiene la claridad y modularidad del sistema. Aunque este modelo es didáctico y estructurado, los sistemas actuales han evolucionado integrando capas y mecanismos complejos, adaptados a arquitecturas distribuidas, entornos Cloud y demandas de alta concurrencia y disponibilidad. Sin embargo, comprender esta base histórica y teórica es esencial para profesionales y académicos que deseen dominar la gestión efectiva de transacciones y la tolerancia a fallos.

![The Lego Island decompilation is now 100% complete [video]](/images/F24052C9-0D11-4E04-8164-530E5E6876EC)