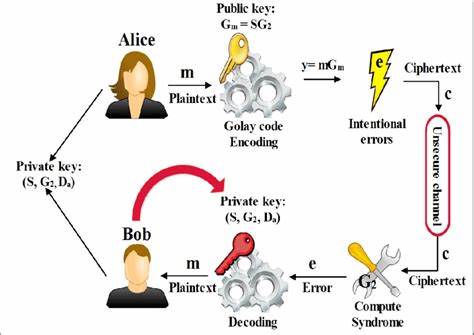

La evolución tecnológica y la amenaza que representan las computadoras cuánticas para la criptografía actual han impulsado una carrera global para establecer sistemas criptográficos resistentes a futuros ataques cuánticos. En este contexto, el criptosistema McEliece, basado en códigos de corrección de errores, se destaca por su robusta historia de seguridad y su prometedora aplicabilidad en la era post-cuántica. Sin embargo, su camino hacia la estandarización y adopción generalizada ha estado marcado por debates y controversias, especialmente frente a otras propuestas como Kyber y HQC, promovidas por entidades como el Instituto Nacional de Estándares y Tecnología de Estados Unidos (NIST). El origen de McEliece se remonta a 1978, cuando Robert McEliece propuso un esquema criptográfico basado en códigos de Goppa para proporcionar privacidad mediante la dificultad computacional de descifrar ciertos códigos lineales. Su principal fortaleza radica en la estabilidad de sus parámetros de seguridad a lo largo de más de cuatro décadas, resistiendo sin pérdidas sustanciales los avances en técnicas criptanalíticas.

Las pruebas relevantes y análisis efectuados por herramientas como CryptAttackTester confirman que las mejoras en ataques contra este sistema se han mantenido marginales, lo que posiciona a McEliece como una alternativa sólida frente a algoritmos basados en retículos, los cuales lentamente han visto mermada su seguridad con nuevas investigaciones. Uno de los aspectos más sobresalientes de Classic McEliece, la versión adaptada para estandarización, es su capacidad para ofrecer tamaños de texto cifrado significativamente pequeños gracias a la incorporación del mecanismo de compresión de texto cifrado introducido por Niederreiter en los años 80. Este atributo resulta esencial para ciertos escenarios de comunicación donde los límites de tamaño de paquetes y el costo del ancho de banda son críticos. Protocolos modernos, orientados a la transmisión eficiente y segura de datos como PQ-WireGuard o el VPN Rosenpass, se benefician directamente de estos textos cifrados compactos, facilitando una integración más ágil en redes con limitaciones o propensas a ataques de denegación de servicio. A pesar de estas ventajas evidentes, el panorama de la estandarización ha sido complejo.

NIST, pilar fundamental en la selección y promoción de algoritmos post-cuánticos, ha seguido un camino prudente y en ocasiones cuestionado en relación con McEliece. Si bien reconoce su seguridad sólida, ha priorizado otros sistemas, en especial Kyber, que es el único algoritmo de cifrado estándar promovido activamente por la entidad hasta la fecha. Esta preferencia ha sido explicada en parte por temores relacionados con patentes, percepciones de rendimiento, y la continua evolución de ataques a lattices. Sin embargo, críticos y expertos del equipo Classic McEliece señalan que dichas razones no se sostienen completamente ante el análisis detallado y que la demora para estandarizar McEliece podría acarrear costos en términos de seguridad y eficiencia en aplicaciones que requieren claves estáticas a largo plazo. El proceso de estandarización en la Organización Internacional para la Estandarización (ISO) ha tenido un avance diferente, con un proyecto aprobado desde mayo de 2023 que contempla a Classic McEliece, FrodoKEM y ML-KEM.

La coincidencia temporal entre las acciones de ISO y las de NIST ha provocado inquietudes sobre posibles estándares incompatibles. No obstante, expertos indican que este temor es infundado debido a la estrecha colaboración habitual entre ambos organismos y a la secuencia natural de estos procesos, en donde primero ISO podría concluir su estándar, permitiendo a NIST ajustar sus documentos y asegurar interoperabilidad. Uno de los puntos centrales en el debate ha sido la cuestión de las claves estáticas versus efímeras. Muchas aplicaciones modernas, desde protocolos de VPN hasta sistemas de autenticación y correo seguro, se apoyan en claves estáticas que se usan para múltiples encriptaciones. En estos casos, el costo total se ve influido más por el tamaño del texto cifrado que por la generación ocasional de la clave pública.

Classic McEliece destaca en este contexto por ofrecer textos cifrados eficientes y un rendimiento que mejora conforme se usan más encapsulaciones con la misma clave, convirtiéndolo en una opción preferida para estos usos específicos. Esta realidad ha sido reconocida incluso en el ámbito empresarial, con compañías como Ericsson abogando públicamente por la estandarización de Classic McEliece y destacando sus ventajas en términos de desempeño y seguridad para casos de uso que involucran claves estáticas, como WireGuard, S/MIME, IMSI o protocolos de negociación de claves como EDHOC. Sin embargo, un análisis crítico de los informes oficiales de NIST revela que el organismo no ha reflejado con precisión este interés ni las implementaciones existentes en el mercado, llevando a una subestimación de la importancia y adopción real de McEliece. En términos de seguridad, McEliece presenta también una ventaja significativa en la simplicidad y robustez de sus supuestos. Mientras que los esquemas basados en lattices y otros enfoques dependen de suposiciones más complejas y a menudo decisionales, Classic McEliece basa su resistencia en la propiedad de unidireccionalidad (one-wayness) de su sistema subyacente, lo que ha sido demostrado con rigor y apoyado en numerosas evaluaciones sobre la dificultad de recuperar claves privadas o resolver problemas de descifrado, incluso con las mejoras recientes en ataques algebraicos o distinciones de clave pública.

No obstante, la narrativa de NIST a menudo ha generado confusión o incluso desinformación respecto a la seguridad real de McEliece, destacando supuestos avances en criptanálisis que según expertos no afectan fundamentalmente el nivel de protección del sistema. Esta falta de claridad y la presentación selectiva de la información contrastan con la confianza pública y los documentos técnicos elaborados por el equipo Classic McEliece, que enfatizan la estabilidad y madurez de sus análisis de seguridad. Desde la perspectiva del rendimiento, se ha detectado también que ciertas evaluaciones y comparativas públicas utilizadas por NIST se basan en datos obsoletos o benchmarks desactualizados que no reflejan las optimizaciones realizadas en versiones recientes del software oficial de McEliece. Esta situación ha perjudicado la percepción del sistema frente a sus competidores, cuando en la práctica, su desempeño en ciclos de CPU es considerablemente mejor de lo que se ha transmitido. Otro episodio significativo fue la eliminación progresiva de FrodoKEM por parte de NIST, argumentada principalmente por problemas de rendimiento.

Esta decisión y la justificación asociada contrastan con la marcada apertura hacia otras propuestas menos eficientes que aplican KEM (Key Encapsulation Mechanism), como HQC, lo que ha motivado cuestionamientos acerca de los criterios utilizados para evaluar aceptabilidad y aplicabilidad en función del contexto real de las aplicaciones. Frente a todo este panorama, la recomendación que muchos expertos plantean es clara: aprovechar las fortalezas de Classic McEliece para aplicaciones donde se justifique su uso, especialmente para escenarios que demanden claves estáticas y textos cifrados pequeños. Para casos donde las limitaciones de tamaño o rendimiento resulten restrictivas, los sistemas basados en retículos pueden actuar como alternativas, aunque con un mayor riesgo relativo dada la creciente complejidad y variabilidad en sus análisis de seguridad. Finalmente, para minimizar el impacto ante posibles fallos o vulnerabilidades, se recomienda un despliegue híbrido que combine criptografía clásica de curva elíptica con algoritmos resistentes a ataques cuánticos. La estandarización de Classic McEliece representa, en definitiva, un paso crucial hacia un ecosistema post-cuántico más diverso, seguro y adaptado a la multiplicidad de necesidades de las futuras aplicaciones digitales.

Su retraso o subestimación pueden significar no solo un costo económico, sino un golpe a la confianza y protección de los datos en un mundo cada vez más interconectado y amenazado por el avance tecnológico. Entender y valorar objetivamente sus ventajas, así como los retos en estándares y despliegue, es fundamental para construir un entorno criptográfico sólido y confiable en las próximas décadas.