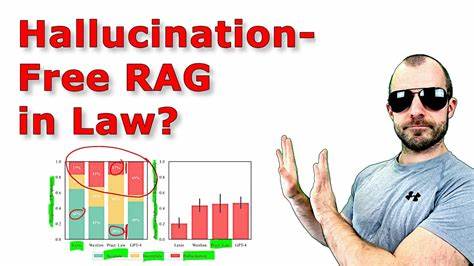

En la era digital, la inteligencia artificial (IA) ha transformado múltiples sectores, y el ámbito legal no es la excepción. Las herramientas de investigación legal basadas en IA prometen agilizar el acceso a jurisprudencia, doctrinas, normativas y análisis complejos que tradicionalmente requerían muchas horas de estudio y experiencia especializada. Sin embargo, surge una pregunta crucial: ¿pueden estas soluciones garantizar resultados precisos y libres de errores que podrían tener graves consecuencias legales? Este cuestionamiento lleva a evaluar la fiabilidad y confiabilidad de los sistemas de IA enfocados en la investigación jurídica y a examinar el fenómeno de las "alucinaciones" en los modelos de lenguaje, que consisten en generar información incorrecta o inventada con terminología convincente. La sofisticación de los modelos de IA ha avanzado considerablemente, con algoritmos capaces de procesar grandes volúmenes de datos legales y aprender de patrones complejos en documentos judiciales y normativos. Herramientas reconocidas en el mercado implementan inteligencia artificial para facilitar búsquedas profundas y entregar resúmenes inteligentes que emulan el trabajo de un profesional legal experto.

No obstante, el balance entre velocidad, facilidad de uso y exactitud resulta un desafío central, ya que incluso pequeñas imprecisiones pueden comprometer la toma de decisiones legales. El término “alucinación” en el contexto de la IA se refiere a cuando un modelo genera hechos o referencias que no existen realmente dentro de su base de datos o del conocimiento real. En el entorno legal, este fenómeno es especialmente peligroso, pues la autoridad, confiabilidad y precisión de la información es fundamental para acciones judiciales, asesorías, cumplimiento normativo y estrategia legal. Por esta razón, abogados y profesionales del derecho se encuentran vigilantes y críticos ante el uso de IA en su práctica diaria. Las herramientas líderes en investigación legal con IA suelen incorporar bases de datos actualizadas, algoritmos de búsqueda semántica y capacidades para interpretar lenguaje natural.

La combinación de estas tecnologías permite una interacción más intuitiva y una detección más profunda de documentos relevantes, citas y precedentes judiciales. Sin embargo, dado que gran parte de la inteligencia artificial que acompaña estas plataformas está sustentada en modelos de lenguaje generativo, el riesgo de alucinaciones persiste, sobre todo cuando se les pide interpretaciones o inferencias complejas. Para mitigar este riesgo, varias plataformas implementan mecanismos de verificación cruzada y filtros de calidad que validan las fuentes antes de ofrecer resultados. Además, algunas incluyen referencias específicas a documentos oficiales y ofrecen funcionalidades para que el usuario pueda verificar el origen de cada dato, fomentando la transparencia y la confianza. No obstante, la interacción humana sigue siendo esencial para corroborar la información y detectar posibles inconsistencias o errores.

El análisis de casos en los que estas herramientas han fallado o proporcionado información incorrecta revela patrones comunes, tales como dependencia excesiva en datos superficiales, sesgo en entrenamientos previos o insuficiente actualización frente a nuevas normativas o jurisprudencia reciente. La vulnerabilidad aumenta en asuntos de alta complejidad o que implican interpretaciones jurídicas novedosas, donde la precisión terminológica y de contexto es vital. En contrapartida, la IA brinda ventajas significativas cuando se usa correctamente. Acelera los procesos de recopilación y análisis de documentos, reduce costes asociados a la investigación manual y permite identificar correlaciones y tendencias menos evidentes para el ojo humano. La integración efectiva de estas herramientas implica capacitación especializada y una cultura de revisión constante para evitar la dependencia ciega y promover un uso crítico y consciente.

La evolución tecnológica también apunta hacia soluciones híbridas y complementarias, donde la IA funciona como soporte al experto legal en lugar de sustituirlo completamente. El objetivo es aprovechar el poder computacional para potenciar la capacidad humana y optimizar resultados, minimizando el margen de error y manteniendo la ética profesional. Asimismo, el futuro promete avances en modelos de lenguaje más refinados y específicos para el ámbito jurídico, entrenados sobre bases de datos especializadas, que podrían reducir las alucinaciones y mejorar la interpretación contextual. También se espera mayor integración de sistemas de inteligencia artificial con plataformas legales oficiales y organismos reguladores, fortaleciendo la confiabilidad y trazabilidad de la información. En conclusión, las herramientas de investigación legal basadas en inteligencia artificial representan un recurso innovador que puede transformar profundamente la práctica del derecho, pero su fiabilidad está condicionada a la implementación de procesos rigurosos de validación y supervisión humana.

Evaluar la presencia y riesgo de alucinaciones en estas plataformas es fundamental para asegurar que la tecnología actúe como un aliado sólido, y no como una fuente de confusión o error. El futuro de la investigación legal dependerá de la colaboración armoniosa entre inteligencia artificial avanzada y el juicio experto humano, consolidando así un sistema más eficiente, preciso y accesible.