En el mundo tecnológico actual, la inteligencia artificial (IA) avanza a pasos agigantados, con agentes de IA emergiendo como una de las innovaciones más prometedoras. Sin embargo, a pesar del entusiasmo generalizado que rodea a estos sistemas autónomos capaces de realizar tareas complejas, existen razones contundentes para considerar que los agentes de IA podrían desencadenar una serie de problemas severos en nuestra sociedad y ámbito laboral. Su creciente adopción no está exenta de riesgos que merecen un análisis riguroso, especialmente en lo que respecta a su precisión, fiabilidad y ética. Uno de los factores más importantes es que, aunque los modelos de lenguaje y algoritmos contemporáneos han mejorado notablemente, aún están lejos de alcanzar una precisión del 100% en escenarios del mundo real. Los indicadores de rendimiento y las pruebas benchmarks suelen mostrar resultados muy optimistas, pero estas métricas no reflejan la complejidad y los matices de las aplicaciones cotidianas.

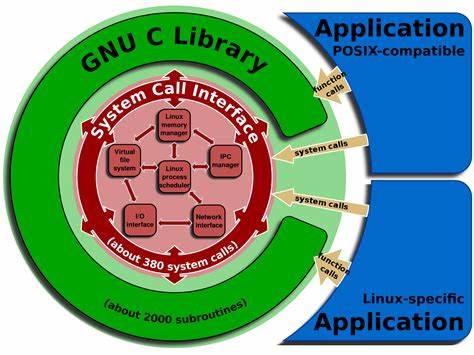

En entornos críticos como la salud o el derecho, un solo error puede derivar en consecuencias devastadoras. La automatización completa basada en agentes de IA, sin una supervisión humana adecuada, puede resultar no solo ineficiente sino peligrosa. Las imperfecciones de estas tecnologías no han sido erradicadas y hasta ahora, no se cuenta con garantías suficientes para confiar plenamente en su toma de decisiones autónoma. Además, la capacidad de los agentes de IA para seleccionar y utilizar herramientas adecuadas en distintos contextos es limitada. Estos sistemas a menudo enfrentan dificultades para decidir si deben apoyarse en su base de conocimiento interna o recurrir a herramientas externas que podrían ser más pertinentes para la tarea.

Cuando intervienen múltiples aplicaciones o software, la coordinación y discriminación adecuada entre ellos no se realiza con la soltura necesaria, generando ineficiencias y errores. Esta descoordinación perjudica especialmente a entornos laborales donde se requiere una integración armónica de diversas fuentes de información y metodologías. Otro aspecto crucial es la confianza. La interacción humana con los agentes de IA está condicionada a un nivel de confianza que, en sectores sensibles, es difícil de alcanzar. Para la mayoría de las personas, la idea de confiar aspectos críticos como su salud, finanzas o seguridad a un sistema que no garantiza infalibilidad resulta inaceptable.

Cuando los agentes cometen errores, la confianza del público y de los usuarios disminuye rápidamente, y en algunas ocasiones puede ser irreparable. Ejemplos del pasado en autos autónomos o en sistemas de recomendación implican que el público se mantiene escéptico, especialmente cuando está en juego la seguridad o decisiones que afectan directamente a la vida humana. Es imposible ignorar el papel insustituible del factor humano en la supervisión y toma de decisiones donde entra en juego el razonamiento moral, la empatía y la intuición. Los agentes de IA carecen de la capacidad para comprender las complejidades emocionales y éticas que surgen en diversas situaciones, como la resolución de conflictos o la atención al cliente en circunstancias delicadas. Por lo tanto, aunque estos agentes pueden encargarse de labores repetitivas o analíticas, la presencia humana sigue siendo fundamental para asegurar procesos justos y considerados que respeten la dignidad y las expectativas sociales.

Los prejuicios incorporados en los datos con los que se entrenan los agentes de IA también representan un obstáculo importante. Estos sistemas reflejan y, en algunos casos, amplifican sesgos sociales presentes en sus conjuntos de datos. En ámbitos como la contratación de personal o la justicia, esto puede traducirse en discriminación inadvertida por género, raza o clase social, perpetuando desigualdades existentes. Detectar y corregir estos sesgos es una tarea ardua y no siempre exitosa, lo que plantea serias dudas sobre la equidad y justicia de las decisiones impulsadas por IA. Desde el punto de vista legal y ético, la irrupción de agentes de IA genera preguntas que aún no tienen respuesta.

¿Quién será responsable cuando un agente cometa un error? ¿Qué sucede si estos sistemas son utilizados para realizar actos ilícitos, desinformar o manipular la opinión pública? La ausencia de una regulación clara y coherente sobre el uso de agentes de IA puede derivar en un escenario de abuso e injusticia. La falta de supervisión pone en riesgo la privacidad, la autonomía individual y la igualdad de oportunidades, además de potenciar la concentración de poder en manos de pocas corporaciones con intereses comerciales. Otro riesgo asociado es la dependencia excesiva en estos agentes, que puede generar una degradación progresiva de habilidades cognitivas humanas esenciales. Al delegar tareas desde las más simples hasta las complejas en sistemas automatizados, los individuos podrían perder destrezas fundamentales para la resolución creativa de problemas o el juicio crítico. Esta situación podría aumentar la vulnerabilidad frente a fallas tecnológicas o manipulación, y reducir la capacidad humana de innovar y adaptarse a nuevos escenarios.