La revolución en inteligencia artificial ha impulsado la demanda de modelos de lenguaje más inteligentes y capaces de comprender grandes volúmenes de datos complejos. En este sentido, las tablas, utilizadas tradicionalmente para almacenar datos estructurados, representan una fuente invaluable de información que aún no ha sido explotada al máximo. Extraer información útil de tablas para modelos de lenguaje moderno es un desafío y a la vez una oportunidad para mejorar los resultados en aplicaciones de análisis, generación de conocimiento y soporte en la toma de decisiones. Los modelos de lenguaje a gran escala, conocidos como LLMs (por sus siglas en inglés), requieren fuentes de datos que sean no solo abundantes sino también estructuradas y comprensibles para alcanzar un alto nivel de precisión y profundidad en sus respuestas. Las tablas contienen datos ordenados en filas y columnas, que permiten realizar análisis descriptivos, comparativos, temporales y causales que podrían enriquecer la inteligencia artificial.

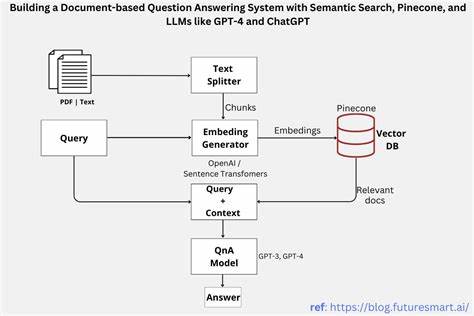

Sin embargo, el principal reto es convertir esos datos brutos en información procesable y legible. Tradicionalmente, el procesamiento de datos tabulares para inteligencia artificial se ha abordado a través de métodos que integraban cada fila como una unidad indivisible, lo que resultaba ineficiente y propenso a la pérdida de detalles estructurales importantes. Otros enfoques involucraban la traducción de lenguaje natural a consultas SQL para interrogar bases de datos, un proceso que demandaba un profundo conocimiento del esquema y no siempre garantizaba una salida rápida o contextualizada. Además, las técnicas de recuperación basadas en índices directos de filas o columnas carecían de una comprensión semántica profunda. Para superar estas limitaciones, se han desarrollado enfoques innovadores que descomponen el proceso en fases claras y automatizadas.

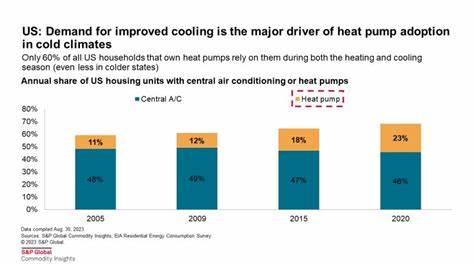

La primera fase es la comprensión de metadatos, que implica analizar el diccionario de datos o codebook asociado, con el propósito de traducir códigos y variables técnicas en etiquetas comprensibles. Esta etapa también consiste en reconocer el tipo de datos, su calidad, ausencias y contexto experimental, lo que a su vez permite incorporar conocimientos previos del dominio o la validación mediante modelos de lenguaje para enriquecer esta interpretación. Una vez entendida la estructura y contexto de los datos, la segunda fase es la extracción de insights o conocimientos. Aquí se ejecutan análisis estadísticos univariantes para describir distribuciones y tendencias centrales, bivariantes para evaluar relaciones entre variables, y análisis temporales destinados a identificar cambios a lo largo del tiempo. Este proceso no solo se restringe a datos numéricos, sino que también contempla variables categóricas y complejas, manejando datos faltantes y experimentales con técnicas apropiadas.

Adicionalmente, mediante modelos de regresión y control de variables, se infieren asociaciones de naturaleza causal y se expresan con lenguaje natural que refleja rigor estadístico y contexto de la fuente. La preparación para visualizaciones representa otro aspecto fundamental en esta etapa, dado que los gráficos y tablas generados pueden mejorar la comprensión y ofrecer representaciones dinámicas dentro de sistemas de generación asistida por recuperación (RAG). Estas visualizaciones son recuperables y permiten a los usuarios interactuar con los resultados. La fase final consiste en la generación de preguntas y respuestas. Cada descubrimiento o dato relevante es envuelto en múltiples pares de preguntas y respuestas, utilizando plantillas y la paraprasiación que proporcionan los modelos de lenguaje.

Esto genera una base de datos robusta que no solo contribuye a la formación y ajuste fino de LLMs, sino que también es un recurso valioso para consultas directas e interactivas con los datos. Un ejemplo destacado de aplicación práctica es el análisis de la encuesta American National Election Studies (ANES). Este conjunto de datos recopila información desde 1948 hasta la actualidad, con más de mil variables codificadas. Utilizando la metodología descrita, es posible traducir variables técnicas como códigos de edad, género o educación en etiquetas comprensibles, y realizar análisis que incluyen promedios, distribuciones, correlaciones, y tendencias históricas en la opinión pública y comportamiento político. Además, se pueden identificar relaciones causales, como el impacto de la ideología política sobre la confianza en el gobierno, ajustando por edad y género.

Estos hallazgos se presentan en lenguaje claro e incluso se formulan preguntas relevantes que facilitan el acceso y el entendimiento. Las ventajas de contar con un sistema automatizado y estructurado para extraer conocimientos de tablas son múltiples. Permiten mejorar la inteligencia de los modelos de lenguaje al ofrecer datos contextuales y precisos que no se obtienen fácilmente con textos no estructurados. Se pueden construir corpus especializados para entrenamiento, optimizando así la capacidad de los modelos para responder a consultas complejas y específicas. Asimismo, este enfoque mejora la eficiencia, eliminando la necesidad de programar manualmente consultas SQL o de realizar interpretaciones extensas por parte de expertos.