En la era digital, la inteligencia artificial (IA) ha evolucionado de manera asombrosa, llevó consigo promesas e inquietudes que acompañan cada avance tecnológico. En particular, la aparición y expansión de los modelos de lenguaje masivos, como los grandes modelos lingüísticos, han planteado nuevas preguntas y suscitado debate en la comunidad especializada y el público en general. La reflexión sobre la presunción inherente a estas tecnologías resulta fundamental para comprender su potencial y sus limitaciones actuales. Históricamente, la inteligencia artificial comenzó con un enfoque simbólico, donde la meta principal era replicar la inteligencia humana mediante sistemas basados en reglas, hechos y razonamientos explícitos. Proyectos como Dendral y MYCIN marcaron la cúspide de esta etapa, satisfaciendo un optimismo generalizado que aseguraba que la inteligencia computacional estaba al alcance, y que solo restaba escalar los sistemas y complejizarlos para alcanzar la inteligencia artificial completa.

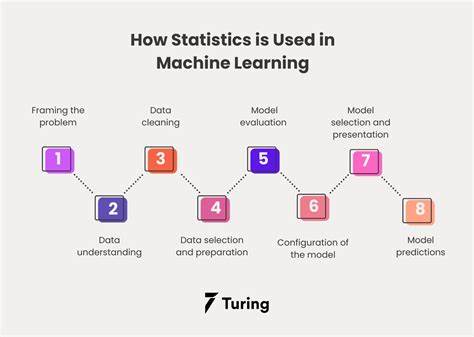

Sin embargo, el progreso en dicha dirección evidenció sus debilidades: la fragilidad y la esterilidad de los sistemas expertos. Estos, aunque efectivos en dominios específicos, carecían de flexibilidad y eran vulnerables frente a escenarios imprevistos o información incompleta. Para subsanar esas deficiencias, se intentaron incorporar probabilidades, heurísticas y mecanismos de razonamiento común que no dependieran exclusivamente de reglas estrictas. Con la llegada de la inteligencia artificial basada en modelos estadísticos y aprendizaje automático, especialmente los transformers y grandes modelos de lenguaje, la conversación se desplazó al dominio del lenguaje y el análisis masivo de textos. Se partió de la idea de que la inteligencia podría emerger a partir del procesamiento estadístico de enormes corpus escritos, enfocándose en la predicción de la siguiente palabra o patrón en una cadena lingüística.

Esta aproximación, aunque ha dado resultados impresionantes en generación de texto y tareas lingüísticas, presenta un conjunto distinto de desafíos. En primer lugar, la dependencia exclusiva en el lenguaje escrito, que no refleja completamente la riqueza y espontaneidad del lenguaje oral ni la compleja interactividad social. El lenguaje escrito es, en sí mismo, una representación artificial que requiere planificación y edición, y no es un reflejo fiel de la cognición humana ni de la comunicación más natural y fluida. Además, los sistemas fundamentados en los grandes modelos de lenguaje son excelentes para predecir y generar texto coherente, pero a menudo carecen de lógica y pueden desviarse de la verdad, produciendo lo que se conoce como 'alucinaciones'. Esto indica que, mientras la capacidad lingüística es fundamental para la inteligencia, no es sinónimo de inteligencia total ni de comprensión genuina.

El artículo “Likewise! AI Presumption” publicado en Communications of the ACM subraya la importancia de cuestionar las presunciones implícitas en el desarrollo tecnológico actual. En particular, la suposición de que el procesamiento digital de texto escrito es un medio suficiente para captar la inteligencia humana requiere revisión y posiblemente una ampliación para incluir otros tipos de datos, como el lenguaje hablado y las interacciones multimediales. Un aspecto interesante es el debate respecto a la relación entre el lenguaje y la inteligencia general artificial (AGI). Algunos expertos argumentan que la proeza en el manejo del lenguaje sería una manifestación del AGI, un indicador y no la base en sí misma. Otros sugieren que entender y replicar la complejidad del lenguaje humano es el punto de partida inevitable para lograr una inteligencia artificial más completa y auténtica.

La reflexión crítica también debe extenderse a los métodos y herramientas que emplean estos modelos. La tokenización, la generación basada en la probabilidad predictiva y la validación mediante retroalimentación humana son procesos que, si bien optimizan el desempeño, también incorporan sesgos y limitaciones que impactan en la calidad y confiabilidad de los resultados. En resumen, la inteligencia artificial moderna enfrenta un conjunto dual de promesas significativas y dificultades intrínsecas. Al mirar atrás, las decepciones de la IA simbólica nos recuerdan la necesidad de paciencia y rigor científico, evitando caer en el exceso de optimismo infundado. Al mismo tiempo, la potente capacidad de procesamiento del lenguaje natural y la enorme disponibilidad de datos escritos han abierto una vía fructífera para explorar la inteligencia desde perspectivas novedosas.

El futuro del desarrollo de la inteligencia artificial debería considerar la integración de múltiples fuentes de datos, incluyendo el habla, imágenes y otros medios sensoriales, para superar las limitaciones actuales. Explorar cómo estos diversos inputs pueden contribuir a una inteligencia artificial más rica y auténtica supone un desafío apasionante para la comunidad científica. Finalmente, la discusión ética y filosófica no puede estar ausente. La tendencia humana a atribuir a las máquinas rasgos que podrían no poseer, o a sobrestimar sus capacidades reales, debe manejarse con cautela. La transparencia en los desarrollos, la educación pública sobre las verdaderas prestaciones y limitaciones de la IA, y la participación activa de la sociedad en estos debates, serán esenciales para orientar el futuro de estas tecnologías de forma responsable y beneficiosa para todos.

Así, la presunción moderna sobre la inteligencia artificial es un reflejo de nuestras expectativas, limitaciones técnicas y comprensión filosófica. Seguir cuestionando nuestras suposiciones, aprender del pasado y diversificar nuestros enfoques serán pasos decisivos para avanzar hacia una inteligencia artificial que realmente potencie nuestras capacidades sin perder de vista la complejidad y riqueza del fenómeno que deseamos emular.