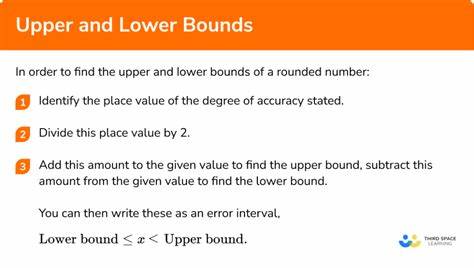

El consenso es uno de los pilares fundamentales en el mundo de la computación distribuida, ya que permite que múltiples procesos lleguen a un acuerdo común a pesar de la posibilidad de fallos y la falta de sincronización absoluta. A lo largo de las décadas, investigadores y profesionales del área han desarrollado diversas soluciones teóricas y prácticas para alcanzar consenso eficiente y seguro, entre las cuales destacan protocolos como Paxos y sus variantes. Sin embargo, uno de los desafíos clave ha sido determinar el número mínimo de procesos necesarios para garantizar un consenso rápido, especialmente cuando se buscan decisiones en tan solo dos pasos o mensajes. Un hito clásico en esta materia es el resultado seminal de Leslie Lamport, quien estableció que para implementar un consenso parcialmente sincrónico tolerante a fallos, se requiere un número mínimo de procesos que dependen de los parámetros de falla tolerados. En particular, su fórmula \max\{2e + f + 1, 2f + 1\} determina la cantidad mínima de procesos necesarios para lograr consenso con deciciones en dos mensajes bajo ciertas condiciones de fallos, donde “f” representa el número de fallos adversos y “e” el número de fallos bajo los cuales se puede decidir en dos pasos.

Este límite superior está perfectamente alineado con el diseño del protocolo Fast Paxos, que se considera un estándar en la obtención de consenso rápido, especialmente en sistemas distribuidos que requieren alta disponibilidad y baja latencia. Sin embargo, el desarrollo tecnológico y la experiencia práctica han dado lugar a protocolos más modernos como Egalitarian Paxos, que logran decisiones en dos pasos empleando menos procesos que los estipulados por los límites clásicos, lo que ha generado un aparente conflicto con las fórmulas tradicionales. La revisión detallada y la reinterpretación de estos límites muestran que la discrepancia surge porque los límites clásicos abarcan escenarios muy generales y de amplio espectro, algunos de los cuales no se presentan o no son relevantes en arquitecturas prácticas actuales. En otras palabras, la teoría tradicional contempla condiciones operacionales y de fallo muy restrictivas, y no siempre se ajusta a las condiciones reales bajo las cuales funcionan los sistemas modernos. Frente a esta realidad, los investigadores han propuesto un enfoque más pragmático que permite establecer límites ajustados a escenarios prácticos y relevantes.

Este nuevo marco redefine las condiciones bajo las cuales se exige el consenso en dos pasos y, a partir de ahí, establece nuevos límites que son más flexibles y realistas. Una de las conclusiones más interesantes de este enfoque renovado es que los requisitos de proceso cambian en función de cómo se implementa el consenso: ya sea como un objeto atómico o como una tarea de decisión. Cuando se implementa como un objeto atómico —que garantiza que las operaciones se vean como instantáneas y lineales— el número mínimo de procesos necesarios para lograr decisiones en dos pasos es \max\{2e + f - 1, 2f + 1\}, una cantidad ligeramente menor que la tradicional, pero aún garantizando consistencia y fiabilidad. Por otro lado, cuando el consenso se implementa como una tarea, es decir, una operación que puede no requerir las propiedades estrictas del objeto atómico, el límite más ajustado para dos pasos es \max\{2e + f, 2f + 1\}. Esta sutileza revela cómo la naturaleza del problema y la definición precisa del consenso influyen en la cantidad mínima de procesos necesarios.

Estas nuevas perspectivas ofrecen valiosas oportunidades para diseñadores de sistemas distribuidos, al permitir optimizar recursos y mejorar la eficiencia sin sacrificar la seguridad o la solidez. Protocolos contemporáneos se benefician directamente de estas revisiones, logrando reducir la cantidad de nodos participantes y la latencia, aspectos cruciales en infraestructuras que manejan enormes volúmenes de transacciones con altos requerimientos de disponibilidad. Además, la revisión de los límites inferiores en el consenso de dos pasos tiene implicaciones importantes en la teoría subyacente de la computación distribuida, facilitando un mejor entendimiento de cómo los fallos y los tiempos de mensaje afectan la capacidad para alcanzar acuerdos rápidos y confiables. La distinción entre consenso como objeto y como tarea desafía y enriquece la manera en que los investigadores conceptualizan la coordinación en sistemas con fallos. En términos prácticos, este trabajo también explica por qué ciertos sistemas que usan protocolos como Egalitarian Paxos parecen violar límites clásicos pero, de hecho, operan bajo condiciones que justifican su éxito con menos procesos.

La aclaración de estas condiciones propicia un ambiente de innovación más informado y racional para la creación de nuevos protocolos que a la vez sean rápidos, tolerantes a fallos y eficientes. La comunidad académica y profesional de la computación distribuida puede aprovechar estos hallazgos para reevaluar diseños existentes y trazar nuevas líneas de investigación que exploren variantes de consenso eficientes adaptadas a condiciones específicas de sistemas reales. La capacidad de tomar decisiones en dos pasos con recursos ajustados es particularmente relevante para aplicaciones en bases de datos distribuidas, blockchain, sistemas de almacenamiento y servicios en la nube que exigen tanto rapidez como confiabilidad. En resumen, la revisión de los límites inferiores para el consenso en dos etapas propone un equilibrio entre rigor teórico y aplicabilidad práctica. El establecimiento de nuevos límites ajustados a las condiciones contemporáneas representa un avance significativo en la comprensión y la implementación eficiente de protocolos de consenso.

Así, se abren puertas a sistemas distribuidos más ágiles y robustos, capaces de satisfacer demandas crecientes sin la necesidad de un sobredimensionamiento de sus componentes. El futuro de los sistemas distribuidos seguramente estará marcado por estas investigaciones que combinan formalismos matemáticos con la experiencia práctica, propiciando innovaciones que permitan explotar al máximo los recursos disponibles y controlar la complejidad inherente a la coordinación en ambientes distribuidos. El consenso en dos pasos, ahora más accesible y mejor comprendido, continuará siendo una herramienta clave para construir sistemas confiables y escalables en la era digital.