En el mundo actual de la inteligencia artificial, los modelos de lenguaje extenso (LLMs, por sus siglas en inglés) se han convertido en una herramienta fundamental para procesar y generar texto, desarrollar predicciones y automatizar tareas especializadas. Sin embargo, a medida que avanzamos hacia aplicaciones cada vez más complejas, surge la necesidad de comprender la estabilidad y confiabilidad de estos sistemas, especialmente cuando se utilizan métodos como el aprendizaje en contexto o Chain-of-Thought (CoT). Aquí es donde la Conjetura de Lyapunov emerge como una herramienta conceptual única para examinar los modos de falla y la sensibilidad de estos modelos ante pequeñas variaciones en sus métodos de entrenamiento o en la estructura de sus datos. El aprendizaje en contexto permite que los LLMs adapten su capacidad para nuevas tareas sin necesidad de un reentrenamiento intensivo. Básicamente, se induce una “memoria” temporal a través de un conjunto de ejemplos o cadenas de pensamiento integradas directamente en la entrada del modelo.

Esto es una evolución fascinante que introduce una forma de automatización simbólica, funcionando como una suerte de AutoML simbólico, donde la automatización no reemplaza a los humanos sino que los auxilia en la construcción de modelos más elaborados y especializados a partir de conocimientos previos. Sin embargo, este enfoque tiene limitaciones evidentes. La cadena de pensamiento debe ser diseñada cuidadosamente por humanos expertos y es altamente dependiente de la coherencia y adherencia del input al diseño original. Una ligera desviación en las condiciones o demandas puede llevar a fallos críticos, como ocurre en ejemplos donde la representación simbólica no se adapta bien a nuevas reglas o tareas incrementales, por ejemplo, cálculos aritméticos basados en letras más complejas que superan el rango inicialmente contemplado. Es en este contexto que la Conjetura de Lyapunov, originaria de la teoría del caos y la dinámica de sistemas, se traslada a la crítica de estas arquitecturas de aprendizaje en máquina.

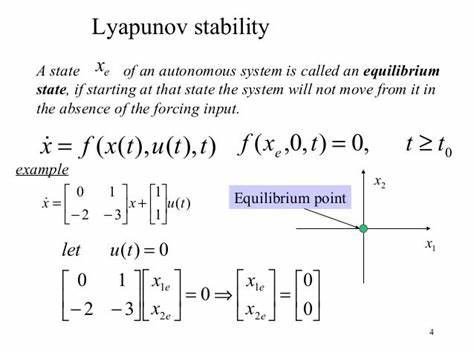

Tradicionalmente, Lyapunov sirve para medir la sensibilidad del comportamiento de un sistema dinámico ante pequeñas perturbaciones en sus condiciones iniciales. Aplicada a las CoT datasets, la idea es similar: si un pequeño cambio en la estructura o los datos que forman la cadena de razonamiento desencadena un efecto desproporcionado o un modo de fallo, decimos que la cadena es Lyapunov sensible. Esto significa que el sistema no es robusto y puede comportarse de manera impredecible fuera de un rango muy estricto de variabilidad. En términos prácticos, el descubrimiento de estas fallas no solo alerta sobre la fragilidad del modelo sino que recalca la importancia del rol humano en el diseño y supervisión de estos procesos. La ilusión de que la automatización elimina la necesidad de la pericia humana es una falacia.

Más bien, se traslada la complejidad y el esfuerzo hacia la creación y validación del dataset simbólico, que a su vez es crucial para mantener la precisión y el funcionamiento estable del LLM. Esta perspectiva plantea desafíos significativos para la investigación y aplicación de los modelos de lenguaje extensos en tareas críticas donde la confiabilidad es primordial. El entendimiento y la mitigación de la sensibilidad Lyapunov en CoTs requieren metodologías rigurosas, así como marcos teóricos que integren conocimientos de matemáticas aplicadas, inteligencia artificial y diseño simbólico con enfoque humano. Más allá de la crítica, la adopción de técnicas basadas en aprendizaje en contexto como un tipo novedoso de AutoML simboliza un avance importante en la manera en que automatizamos el aprendizaje de máquinas. Se potencia la productividad, se democratiza el acceso a tareas sofisticadas y se ofrece la posibilidad de ajustar modelos sin largos procesos de entrenamiento.

Esto facilita no solo a los expertos sino también a usuarios menos experimentados a involucrarse con la inteligencia artificial de forma significativa y productiva. Al mismo tiempo, es imprescindible mantener una visión crítica y realista de las capacidades de estos sistemas. Reconocer sus limitaciones, como las expresadas en la Conjetura de Lyapunov para tareas de CoT, evita sobreexpectativas y promueve el desarrollo de soluciones complementarias que balanceen automatización y supervisión humana. En definitiva, el estudio de la estabilidad de los modelos de lenguaje extenso desde la perspectiva de la Conjetura de Lyapunov abre una nueva ventana para entender los mecanismos internos de aprendizaje simbólico en IA. Nos invita a profundizar en cómo diseñamos datasets, analizamos modos de falla y aplicamos estos sistemas en esferas donde la precisión y resiliencia son vitales.

Mientras avanzamos hacia futuras integraciones masivas en campos diversos, esta comprensión crítica será la base para crear modelos más robustos, confiables y alineados con las necesidades humanas. La convergencia de teoría matemática clásica con inteligencia artificial emergente demuestra, en este caso, que la estabilidad y la programación simbólica desde humanos siguen siendo la piedra angular para un aprendizaje automático efectivo. Explorar y superar las limitaciones detectadas por la Conjetura de Lyapunov en las cadenas de pensamiento será una tarea central para investigadores y profesionales que buscan aprovechar todo el potencial de los modelos de lenguaje extenso en la nueva era digital.