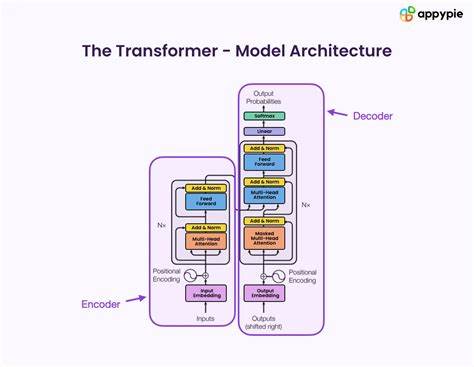

Los modelos de lenguaje han revolucionado la manera en que la inteligencia artificial procesa y genera texto, siendo piezas centrales de numerosas tecnologías actuales. Sin embargo, comprender las diferencias arquitectónicas y cómo estas inciden directamente en sus capacidades sigue siendo un desafío, especialmente en contextos de preentrenamiento a gran escala que involucran miles de millones de parámetros y enormes conjuntos de datos. En este sentido, la investigación más reciente pone especial atención en un componente innovador denominado "Capas Canon", que promete alterar significativamente la dinámica interna del procesamiento secuencial en modelos como Transformers, atención lineal y modelos basados en espacios de estado. El nombre "Canon" proviene de la terminología musical, evocando la idea de una armonía repetida y sincronizada entre elementos vecinos, aplicándose aquí a la corriente horizontal de información entre tokens adyacentes en la secuencia procesada. Estas capas Canon operan creando sumas ponderadas de representaciones cercanas, favoreciendo la difusión de información local de modo eficiente y natural.

La introducción de esta arquitectura resulta en mejoras significativas en distintos aspectos clave del desempeño del modelo. Una de las propiedades más notables de las capas Canon es su capacidad para duplicar la profundidad del razonamiento dentro del proceso de inferencia, un atributo esencial para tareas que requieren entender relaciones complejas o desarrollar inferencias jerárquicas. De manera complementaria, la modificación arquitectónica amplía el alcance o la amplitud del razonamiento, facilitando que el modelo integre información más diversa sin sacrificar la coherencia o la precisión contextual. Este avance no solo se evidencia en modelos robustos, sino que también eleva el rendimiento de arquitecturas más básicas o limitadas, como los modelos NoPE (sin posicionamiento posicional embebido), alcanzando niveles comparables a alternativas avanzadas como RoPE (posicionamiento rotativo relativo). También permite que mecanismos de atención lineal compitan con modelos de espacios de estado sofisticados, destacando así la versatilidad y potencia que esta innovación aporta.

Para validar la efectividad y el impacto de las capas Canon, los investigadores han desarrollado entornos sintéticos controlados para preentrenamiento. Estos espacios experimentales ofrecen un escenario ideal para separar el ruido y la aleatoriedad que comúnmente afectan los resultados en escenarios académicos a gran escala. Gracias a esta metodología, es posible aislar y evaluar recursos intrínsecos del modelo, revelando con mayor claridad los beneficios atribuidos a las capas Canon, tanto en tareas sintéticas altamente especializadas como en entrenamiento a escala real. Una ventaja adicional de este enfoque basado en datos sintéticos ilimitados y de alta calidad es su capacidad para anticipar la evolución futura de las arquitecturas de modelos de lenguaje ante mejoras en las tuberías de entrenamiento. Por ejemplo, mejoras en la curación de datos o en técnicas como el aprendizaje por refuerzo posterior al entrenamiento pueden potenciar aún más las habilidades de razonamiento y la inferencia jerárquica, aspectos que se ven notablemente amplificados con la incorporación de las capas Canon.

En el panorama actual de la inteligencia artificial, donde la transparencia y la eficiencia arquitectónica son valores centrales, la evidencia apunta a que la integración de mecanismos que faciliten el flujo de información horizontal y local es una vía prometedora. Las capas Canon encajan dentro de esta visión, aportando no solo una mejora funcional clara, sino también una solución arquitectónica liviana y adaptable que no entorpece la compatibilidad con otras estructuras de secuencia. El impacto práctico es considerable. Desde mejorar la comprensión contextual hasta optimizar el análisis de lenguaje natural en aplicaciones que requieren un entendimiento profundo y razonado, esta innovación marca un hito. Además, su capacidad para rescatar el rendimiento de modelos simples abre nuevas posibilidades para dispositivos y entornos con limitaciones computacionales, democratizando el acceso a capacidades avanzadas de procesamiento.

En última instancia, la incorporación de las capas Canon representa un avance conceptual y práctico que redefine la arquitectura interna de los modelos de lenguaje. Permite no solo avanzar en la precisión y profundidad del procesamiento lingüístico sino también trazan un rumbo claro hacia la próxima generación de modelos capaces de razonamiento multi-capa con eficacia y eficiencia renovadas. El desarrollo de este tipo de investigaciones resalta la importancia de continuar explorando nuevas formas de diseñar arquitecturas de IA que aumenten la capacidad explícita del modelo para manipular y sintetizar conocimiento, más allá de la mera acumulación de datos o parámetros. La conjunción de la física aplicada a los modelos de lenguaje y las innovaciones en diseño arquitectónico, como la magia de las capas Canon, anticipa un futuro en el que los modelos de lenguaje sean cada vez más potentes, interpretables y adaptativos, haciendo realidad el sueño de máquinas que entiendan y razonen el lenguaje humano de manera más natural y profunda.