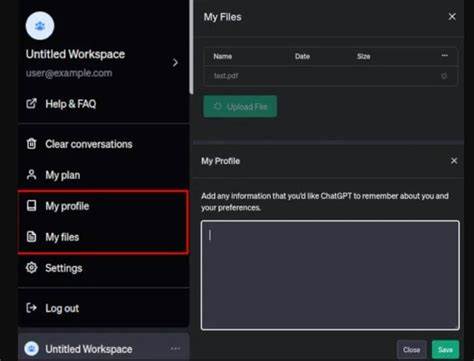

En el contexto actual de la inteligencia artificial y la automatización, ChatGPT se ha convertido en una herramienta indispensable para millones de usuarios en todo el mundo. Gracias a su capacidad para procesar lenguaje natural y brindar respuestas precisas, cada vez más personas recurren a este modelo para obtener asistencia técnica, aprender, traducir o incluso realizar análisis complejos. Sin embargo, recientemente han surgido preocupaciones acerca de la privacidad y seguridad de los datos que los usuarios comparten, particularmente en relación con la posible filtración de archivos que se han cargado en la plataforma. Un caso reciente que ha puesto en alerta a la comunidad tecnológica involucra a un usuario que solicitó a ChatGPT información sobre el formato de archivos binarios de un software específico llamado SVOX Picotts. Lo que inicialmente parecía un intercambio rutinario de información técnica, derivó en la inesperada revelación de datos pertenecientes a otro usuario.

Esta situación no solo sorprendió por la naturaleza de la información mostrada, sino también porque durante la conversación el modelo cambió repentinamente de idioma, pasando del inglés al portugués, lo que sugiere que estaba accediendo o interpretando contenido de diferentes fuentes o sesiones. Este incidente plantea una serie de interrogantes fundamentales: ¿Hasta qué punto la inteligencia artificial mantiene la privacidad y confidencialidad de los archivos subidos por cada usuario? ¿Existe la posibilidad de que datos sensibles, desde proyectos técnicos hasta información médica, puedan ser expuestos inadvertidamente a otros usuarios? La gravedad de estos cuestionamientos radica en la confianza depositada por millones de personas que comparten datos variados con la esperanza de obtener ayuda o respuestas útiles, sin imaginar que sus datos puedan filtrarse. Para comprender mejor esta problemática, es importante analizar la arquitectura y funcionamiento de ChatGPT. Este modelo de inteligencia artificial, desarrollado por OpenAI, se basa en una vasta red neuronal que ha sido entrenada con cantidades masivas de datos textuales para predecir y generar respuestas coherentes. No obstante, las sesiones con los usuarios suelen ser tratadas como conversaciones aisladas con mecanismos internos que evitan mezclar información entre usuarios.

Sin embargo, el incidente mencionado sugiere que podría haber fallas o errores temporales en el manejo de los contextos o en la segmentación de datos. El riesgo de filtración de datos sensibles no debe tomarse a la ligera. Muchos usuarios suben archivos que contienen información privada, desde documentos financieros, contratos, hasta registros médicos. La exposición accidental de estos archivos podría causar daños irreparables, como pérdida de privacidad, problemas legales, o incluso riesgos de seguridad personal. Además, dado que la inteligencia artificial funciona en la nube y no en un dispositivo local, los datos transmitidos están sujetos a protocolos de seguridad que dependen del proveedor del servicio.

Otro aspecto relevante es la gestión de idiomas y contextos. El cambio automático del inglés al portugués en la conversación no solo fue una anomalía relevante, sino que también indica que ChatGPT utilizó información de otro usuario con un contexto lingüístico distinto. Esto sugiere que, en determinados casos, el modelo combina o confunde contextos de diferentes conversaciones, un fallo que requiere atención inmediata por parte de los desarrolladores y responsables de la plataforma. Para los usuarios, la recomendación principal es ejercer máxima precaución al compartir archivos o datos sensibles a través de ChatGPT o cualquier otro servicio de inteligencia artificial. Es vital verificar qué clase de información se está proporcionando y reflexionar sobre las posibles consecuencias si dicha información llegara a filtrarse o ser interpretada fuera de su contexto original.

En el ámbito corporativo y gubernamental, este tipo de incidentes debe ser motivo suficiente para reevaluar políticas internas de uso de inteligencia artificial, especialmente cuando se maneja información regulada o confidencial. La implementación de protocolos de seguridad adicionales, capacitación adecuada para empleados y el desarrollo de soluciones que limiten o anonimicen datos sensibles antes de ser procesados, resultan fundamentales para reducir las vulnerabilidades. Los desarrolladores de modelos de IA y las plataformas que los alojan también deben tomar este escenario como una alerta para mejorar sus sistemas. La transparencia en cómo se gestionan los datos, la implementación de auditorías constantes y la creación de mecanismos para detectar y corregir filtraciones o cruces indebidos de información son pasos esenciales para mantener la confianza del usuario. Es necesario también entender que la tecnología detrás de ChatGPT y otros modelos de lenguaje natural está en constante evolución.

La capacidad de procesar contextos complejos y múltiples idiomas representa un desafío significativo para los diseñadores de estos sistemas. Fallos como el reconocido cambio de idioma inesperado o la aparición de datos ajenos pueden, en algunos casos, ser resultado de pruebas experimentales o errores temporales en actualizaciones recientes del modelo. En conclusión, el incidente donde ChatGPT reveló información perteneciente a otros usuarios pone en relieve la importancia crítica de la privacidad y seguridad en el manejo de datos en plataformas de inteligencia artificial. Si bien la utilidad de estas herramientas es increíblemente valiosa, es imperativo que tanto usuarios como proveedores implementen prácticas responsables para proteger la confidencialidad y minimizar riesgos. La confianza en la inteligencia artificial depende de la certeza de que nuestros datos están seguros y que cualquier información sensible no será expuesta ni utilizada de forma indebida.

![90s Cable Simulator – Recreating Retro Cable TV with a Raspberry Pi [video]](/images/0088042A-78A8-41AE-982D-A210235D2206)