La inteligencia artificial (IA) ha dejado de ser una tecnología lejana para convertirse en una herramienta fundamental en diversos sectores, desde el entretenimiento hasta el ámbito sanitario. Con esta creciente importancia, la regulación y el manejo adecuado de la IA se vuelven indispensables. En este contexto surge el Artículo 4 del AI Act de la Unión Europea, que establece directrices claras sobre la alfabetización en inteligencia artificial para las organizaciones que utilizan o desarrollan sistemas de IA. Estas prácticas no solo buscan garantizar un uso responsable, sino también mitigar riesgos y fomentar una cultura organizacional adaptada a las nuevas realidades tecnológicas. El llamado a la "alfabetización en IA" va mucho más allá de una simple capacitación tecnológica.

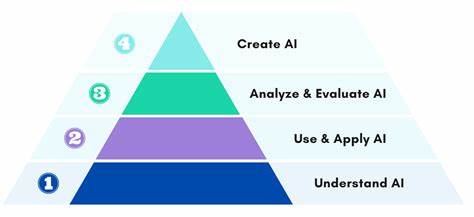

Implica que los empleados y responsables en las empresas comprendan en profundidad cómo funciona la inteligencia artificial, sus limitaciones, sus riesgos y las mejores maneras de integrarla en procesos cotidianos sin caer en sesgos, errores o malentendidos graves. A partir de febrero de 2025, esta formación se vuelve obligatoria para asegurar un marco de trabajo que prevenga sanciones indirectas y pérdidas de reputación derivadas de usos inadecuados. Uno de los pilares del Artículo 4 es la diferenciación clara entre roles. No todos los actores implicados en el manejo de IA tienen las mismas responsabilidades ni necesitan el mismo nivel de conocimiento. Por ejemplo, los proveedores de IA, aquellos que desarrollan o comercializan estas soluciones, tienen requerimientos distintos en términos de transparencia y evaluación de riesgos que los usuarios finales, quienes emplean la IA para tareas específicas dentro de sus áreas profesionales.

Esto obliga a diseñar programas de formación flexibles y adaptados al contexto particular de cada organización y área de trabajo. Una característica fundamental del marco normativo es que no se imponen formatos rígidos de capacitación. La flexibilidad es clave, porque la diversidad de sectores y el avance acelerado de la tecnología hacen inviable un único modelo. Así, las organizaciones tienen la libertad de crear contenidos y metodologías de aprendizaje adecuados a sus necesidades específicas. Lo esencial es que estas formaciones permitan a los participantes identificar riesgos como el sesgo algorítmico o las alucinaciones —es decir, errores donde las IA generan respuestas imprecisas o falsas— y sepan cómo actuar en consecuencia.

La evaluación de riesgos es otro aspecto crucial bajo esta regulación. La incorporación de IA en un entorno laboral debe estar precedida por la identificación cuidadosa de posibles problemas que puedan afectar tanto a la integridad de los procesos como a la confianza de usuarios y clientes. Esto implica auditar los sistemas de IA, validar los resultados y mantener una supervisión continua para evitar consecuencias no deseadas, especialmente cuando se trata de aplicaciones sensibles o de alto impacto, como en la salud o seguridad. Ejemplos reales demuestran la utilidad y alcance de estos requisitos. Empresas como Telefónica y Verbund han implementado programas de alfabetización en IA que involucran a diferentes áreas, garantizando que no solo los equipos técnicos, sino también gerenciales y operativos, comprendan el alcance y las limitaciones de las tecnologías que utilizan.

Estas experiencias muestran cómo la educación interna contribuye a optimizar el uso de IA, potencia la innovación responsable y previene riesgos legales o éticos. Más allá del cumplimiento normativo, estas prácticas fomentan una cultura corporativa que reconoce el valor estratégico de la inteligencia artificial sin perder de vista la ética y la transparencia. La adopción de una visión crítica y formativa permite que las organizaciones se posicionen de manera competitiva, con empleados capaces de tomar decisiones informadas y responsables en un entorno cada vez más automatizado. Otra ventaja importante es la prevención de consecuencias reputacionales. En tiempos donde la confianza es un activo esencial, los fallos en el uso de IA pueden derivar en problemas graves, desde la propagación de información errónea hasta el daño en la privacidad o discriminación inadvertida.

La alfabetización en IA contribuye a que cada colaborador entienda su rol en el ecosistema digital y promueva prácticas seguras que protejan a la organización y a sus clientes. En cuanto al diseño de los programas de formación, se recomienda combinar teorías con casos prácticos y simulaciones que reflejen escenarios reales. Esto no solo facilita la comprensión, sino que también asegura que los conocimientos se puedan aplicar rápidamente en el día a día. Asimismo, la incorporación de feedback continuo y evaluación del aprendizaje permite ajustar e innovar los contenidos según las necesidades emergentes. Mientras la regulación europea marca este camino, el resto del mundo observa con atención los avances para adoptar estándares similares en materia de IA.

La alfabetización es, sin duda, una pieza clave para adelantar un uso responsable de la tecnología y evitar los errores del pasado, cuando muchas innovaciones se implementaron sin la debida preparación o análisis de impacto. En suma, el Artículo 4 de la AI Act es un llamado a la acción para las organizaciones: no se trata solo de cumplir con una norma, sino de construir un conocimiento sólido que permita integrar la inteligencia artificial como una aliada segura y confiable. Este esfuerzo implica comprensión profunda, capacitación continua y evaluación constante, pero sobre todo la voluntad de adaptarse y evolucionar en un contexto digital en constante cambio. Así, la alfabetización en inteligencia artificial se convierte en un pilar fundamental para aprovechar todo el potencial de la IA con responsabilidad, ética y eficacia, garantizando que tanto las empresas como sus usuarios estén preparados para los desafíos y oportunidades que esta tecnología generará en un futuro muy próximo.