La inteligencia artificial sigue conquistando nuevos terrenos, y uno de los campos más interesantes de experimentación son los videojuegos clásicos. Pokémon, con su complejidad estratégica y la necesidad de una toma constante de decisiones, se ha convertido en un desafío fascinante para modelos de lenguaje avanzados como Gemini 2.5 Pro y Claude 3.7 Sonnet. Recientemente, la discusión sobre cuál de estos modelos es mejor jugando Pokémon ha generado un intenso debate en la comunidad.

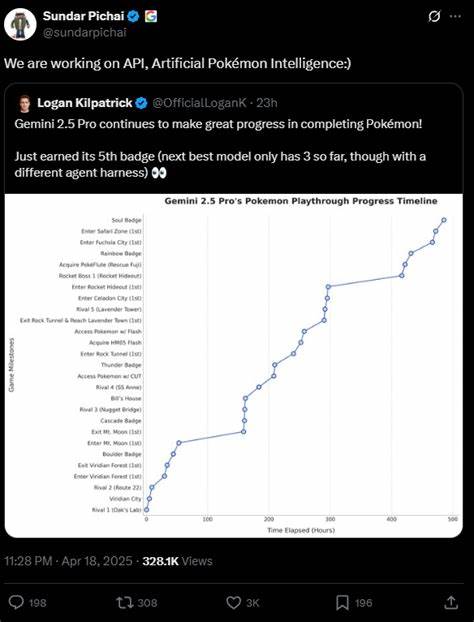

Es esencial desmenuzar tanto sus logros como las diferencias fundamentales en su forma de operar para entender mejor esta rivalidad que, en realidad, va más allá de un simple enfrentamiento. La referencia inicial al benchmark de Pokémon surge con el lanzamiento de Claude 3.7 Sonnet por Anthropic, que promovió la idea de que su modelo podía superar retos complejos dentro del juego. Posteriormente, Google presentó a Gemini 2.5 Pro, asegurando que había avanzado considerablemente más en las pruebas y que lo había hecho con menos esfuerzo computacional, algo que llamaba la atención de expertos y aficionados.

Sin embargo, un análisis más profundo revela que no todo es tan sencillo como parece. Uno de los aspectos más importantes al evaluar el desempeño de estas IA es la diferencia en las 'herramientas' o «agent harnesses» que cada una utiliza. Este término se refiere a una compleja infraestructura que rodea al modelo base y le proporciona soporte indispensable: prompts con consejos específicos, acceso a información visual y de la memoria RAM del juego, herramientas para traducir texto en comandos dentro del emulador, un sistema de planificación y enjuiciamiento de acciones mediante un segundo modelo crítico, y más. La disparidad en estas configuraciones influye directamente en los resultados obtenidos y hace que una comparación directa sea un tanto cuestionable. Claude y Gemini, aunque parten de objetivos similares, difieren en la forma y cantidad de información que pueden procesar antes de tomar cada decisión.

Por ejemplo, Gemini recibe una representación textual del minimapa del juego que le permite navegar con mayor claridad, algo que Claude no tiene en la misma medida debido a limitaciones en su acceso o en el formato de información. Esta ventaja informativa facilita que Gemini pueda evitar perderse o actuar de manera errática en entornos complicados. Por otro lado, Claude posee una herramienta de navegación más sofisticada en ciertos aspectos, que le permite pedir desplazamientos precisos dentro del mapa del juego, siempre que las coordenadas sean visibles en pantalla. Este sistema representa un enfoque distinto para sortear los retos de la exploración, que también es uno de los puntos débiles de los modelos debido a las dificultades que presentan los problemas visuales y de comprensión volcados en imágenes. A nivel de rendimiento, Gemini ha logrado avanzar aproximadamente el doble de distancia en el juego usando alrededor de un tercio de las acciones que ha necesitado Claude.

Este dato llama la atención y, en términos superficiales, podría indicar una mejora significativa. Sin embargo, el responsable del proyecto GeminiPlaysPokemon, Joel Z, deja claro que estas métricas no son un reflejo riguroso de superioridad, ya que la configuración, la asistencia recibida y los objetivos en cada experimento varían enormemente, haciendo que la comparación sea poco objetiva. Más allá de los números y las herramientas, es importante entender la filosofía y el contexto en los que ambos proyectos se desarrollan. ClaudePlaysPokemon se ha estado trabajando durante más tiempo y en un ambiente más controlado y cerrado, mientras que GeminiPlaysPokemon está en una fase experimental activa con intervenciones en tiempo real para mejorar el rendimiento, lo que introduce dinámicas diferentes en la evolución de la ejecución. Además, ambos modelos enfrentan complicaciones propias de la visión computarizada, uno de los cuellos de botella principales para la navegación y toma de decisiones en el juego.

La dificultad radica en interpretar correctamente las imágenes del juego, entender el entorno y planear movimientos coherentes y estratégicos, tareas que aún representan un reto considerable para las IA. Por si fuera poco, la versión del juego que se ejecuta también difiere: Claude juega Pokémon Rojo mientras que Gemini lo hace en Pokémon Azul. Aunque en esencia ambos títulos son muy similares, existen pequeñas variaciones en los Pokémon disponibles y en ciertas mecánicas que pueden influir en su experiencia y estrategia, añadiendo otra variable a considerar en la comparación. El debate también pasa por cuestionar qué tan válido es usar Pokémon como benchmark para medir la capacidad de las IA. Algunos expertos señalan que, teniendo en cuenta la intervención humana en la configuración de los agentes, las limitaciones en visión y la cantidad abrumadora de pasos en los que muchas acciones no contribuyen efectivamente al progreso, este enfoque es más una curiosidad técnica que una medición real y definitiva.

Además, la existencia de programas clásicos de velocidad (TAS) y bots diseñados específicamente para Pokémon, aunque no basados en aprendizaje automático, complica la interpretación del logro alcanzado por los modelos de lenguaje. En términos de experiencia de usuario y observador, aquellos que han seguido ambas transmisiones y experimentos coinciden en que las diferencias no son abismales. Ambos modelos muestran fortalezas y debilidades, dificultades en mantener la coherencia a largo plazo, y momentos claros de desconcierto o bloqueo en el juego. Algunos señalan que Gemini parece tener más éxito en aspectos como generación de mapas y reconocimiento de objetos, mientras que Claude se rinde más rápidamente ante objetivos imposibles o errores inadvertidos. Lo que queda claro es que el avance en la lucha de ambos modelos no se puede atribuir únicamente a su inteligencia inherente, sino que depende largamente del contexto en el que se ejecutan, su arquitectura de soporte y los ajustes constantes realizados durante sus corridas.

![Best AI Hacker in the World [video]](/images/1ABAFA3D-EDA0-4717-91F7-1C234AC8C72B)