Durante las últimas décadas, el avance de la inteligencia artificial (IA) ha sido vertiginoso y transformador. Desde sistemas simples hasta modelos generativos complejos, la IA ha cambiado la manera en que interactuamos con la tecnología, impactando áreas tan diversas como la medicina, las finanzas, la comunicación y el entretenimiento. Sin embargo, a medida que estas tecnologías crecen en poder y sofisticación, surge un desafío fundamental que preocupa tanto a expertos como a usuarios: la falta de transparencia en cómo estas máquinas toman decisiones. Esta realidad, conocida comúnmente como el “efecto caja negra” de la IA, se refiere a la imposibilidad de comprender con claridad qué sucede dentro de un modelo avanzado cuando procesa información o genera resultados. Mediante la interpretabilidad, se busca desvelar estos procesos ocultos para asegurar que la IA sea confiable, ética y realmente beneficiosa para la sociedad.

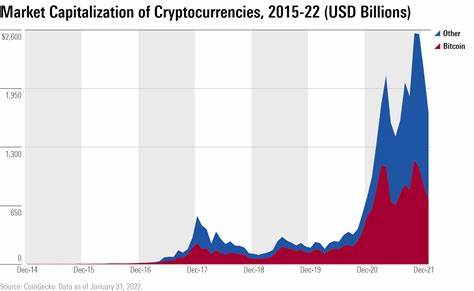

La palabra caja negra hace referencia a sistemas con componentes o procesos internos que no son accesibles o comprensibles. En la IA, este concepto se aplica especialmente a redes neuronales profundas y modelos generativos que, aunque pueden producir resultados impresionantes, no revelan claramente las bases de sus decisiones. Esto contrasta con el software tradicional, en el que las instrucciones y reglas son explícitamente definidas por programadores humanos. La complejidad y el aprendizaje autónomo hacen que la IA actual sea en gran medida un misterio incluso para sus propios creadores. Este desconocimiento puede producir riesgos elevados: errores no detectados, sesgos ocultos que perpetúan injusticias, o comportamientos inesperados que pueden tener consecuencias negativas, especialmente en sectores sensibles como el sanitario o financiero.

La inquietud fundamental detrás de este problema es que, sin entender cómo razona un sistema de IA, perdemos control y capacidad para anticipar posibles fallos o malos usos. Por ejemplo, un modelo de IA que sugiere diagnósticos médicos podría generar recomendaciones erróneas debido a datos sesgados o interpretaciones equivocadas, y sin interpretabilidad no se podrían identificar los factores específicos que llevaron a esta conclusión. Además, la ausencia de transparencia dificulta la aceptación pública y regulatoria, frena la integración segura de la IA en procesos críticos y limita la responsabilidad legal ante posibles daños. Afortunadamente, en los últimos años, el campo de la interpretabilidad ha avanzado significativamente. La investigación se enfoca en desentrañar las “cajas negras” para comprender qué representan las diferentes características internas, cómo interactúan y cómo influyen en las decisiones del modelo.

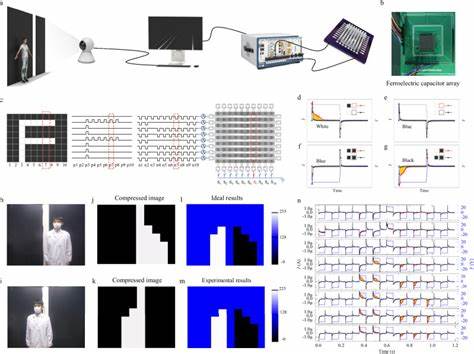

Empresas pioneras, como Anthropic, han logrado mapear millones de características específicas dentro de sus modelos avanzados, lo cual representa un paso importante hacia la creación de sistemas más transparentes. Estas iniciativas utilizan herramientas sofisticadas que permiten identificar patrones y conexiones neuronales con significado inteligible, ayudando a explicar el razonamiento de las máquinas. Este progreso no solo es tecnológico, sino también estratégico. La posibilidad de inspeccionar y rastrear el comportamiento interno de una IA permite detectar y corregir sesgos, errores o vulnerabilidades que podrían ser explotadas maliciosamente. En la práctica, esto significa que los desarrolladores pueden hacer una depuración más certera y que los responsables de seguridad pueden anticipar problemas antes de que ocurran.

Incluso en entornos donde se realizan pruebas de estrés y validación profundas, como en lo que se conoce como “red teaming” y “blue teaming”, la interpretabilidad facilita la identificación de puntos débiles instalados intencionalmente y su posterior reparación. La interpretabilidad tiene asimismo un impacto directo en la colaboración entre humanos y máquinas. Cuando se puede entender y explicar cómo un sistema de IA genera sus respuestas, los usuarios están mejor equipados para confiar en sus recomendaciones y decisiones. Esto es fundamental en áreas donde una simple decisión basada en IA puede tener efectos significativos sobre vidas humanas, como en tribunales, servicios financieros o administración pública. La transparencia ayuda a evitar el abuso o la dependencia ciega en sistemas que podrían no ser perfectos.

Por otro lado, la carrera tecnológica actual avanza a un ritmo acelerado, lo que plantea desafíos excepcionales para mantener la claridad y el control. Muchos modelos crecen en complejidad y tamaño, dificultando aplicar métodos de interpretabilidad a gran escala. Sin embargo, la dimensión de esta responsabilidad obliga a una colaboración multidisciplinaria: investigadores, reguladores, desarrolladores y sociedad civil deben trabajar conjuntamente para establecer marcos sólidos que promuevan la transparencia y fomenten la innovación segura. Los gobiernos y los organismos internacionales tienen un papel especialmente crucial en este sentido. La creación de políticas que incentiven o incluso exijan transparencia en el desarrollo de proyectos de IA puede proteger a los ciudadanos y evitar un uso malévolo o irresponsable.

Además, estas regulaciones pueden impulsar la investigación en interpretabilidad como una línea prioritaria, promoviendo estándares que contribuyan a la confianza global en la inteligencia artificial. Desde el punto de vista ético, la interpretabilidad responde a una necesidad imperiosa: garantizar que la IA no se convierta en una caja negra impenetrable que gouverne aspectos fundamentales de la vida sin supervisión humana. La transparencia debe ser parte del núcleo del diseño y desarrollo de estos sistemas para asegurar que respeten derechos, eviten discriminaciones y mantengan alineados los valores humanos con las decisiones automatizadas. A largo plazo, la búsqueda de interpretabilidad puede transformar la propia naturaleza de la inteligencia artificial. Sistemas diseñados para ser explicables no solo son más seguros, sino que también pueden ser mejores colaboradores y asistentes.

Al comprender y revelar sus procesos, la IA puede adaptarse y aprender de manera más responsable, evitando errores y participando en diálogos efectivos con sus usuarios. En conclusión, la revolución de la IA trae consigo oportunidades inmensas, pero también importantes desafíos que no pueden ser ignorados. La llamada “caja negra” representa uno de los mayores riesgos si no se logra avanzar en la interpretabilidad y la transparencia. Mientras las máquinas se vuelven más inteligentes, los humanos debemos redoblar esfuerzos para entender y controlar esas inteligencias. De esta manera, la IA podrá cumplir su promesa de ser una herramienta poderosa para mejorar nuestras vidas sin sacrificar la integridad, la seguridad ni los valores fundamentales de nuestra sociedad.

La interpretabilidad es la llave que abre la caja negra y nos permite mirar dentro con confianza y claridad, marcando el camino hacia un futuro digital en el que la inteligencia artificial sea realmente una aliada confiable y ética.