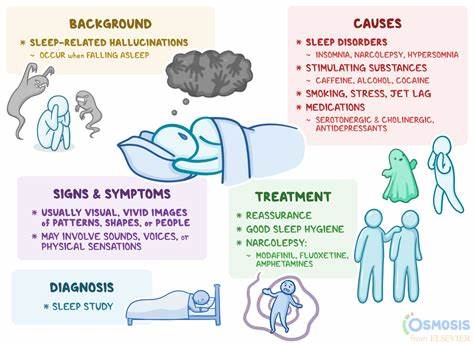

En la era digital actual, donde la inteligencia artificial (IA) y los modelos de lenguaje como GPT están cada vez más presentes en nuestras actividades diarias, es común escuchar el término "alucinaciones" aplicado a las máquinas. Sin embargo, estas manifestaciones de errores o imprecisiones no son exclusivas de los sistemas automatizados; los humanos también pueden caer en errores similares que repercuten en la productividad y eficacia de las organizaciones. La expresión "cómo detener que tu humano alucine" se convierte entonces en una metáfora para abordar las fallas que ocurren cuando las personas trabajan sin un sistema claro o sin el contexto adecuado, y ofrece una oportunidad para analizar cómo mejorar la colaboración entre humanos e inteligencia artificial. La analogía entre los errores cometidos por los seres humanos y las alucinaciones de los modelos de lenguaje ayuda a visibilizar que ambos tipos de inteligencia enfrentan problemas similares. Estos errores suelen surgir cuando la información es insuficiente, contradictoria o está mal comunicada.

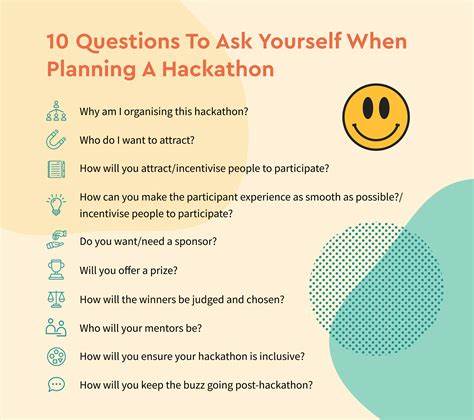

En entornos laborales o de toma de decisiones, estas condiciones hacen que la persona actúe con suposiciones incorrectas, falta de claridad o con restricciones temporales que afectan su razonamiento y las acciones que emprende. Para entender mejor estas dinámicas, es útil examinar casos donde, en lugar de combatir el error con más presión o remediaciones puntuales, se crean sistemas y procesos que permiten a los individuos desempeñarse con mayor precisión y confianza. Tomemos como ejemplo a Alice, una gerente ficticia en una empresa joven y en rápida expansión, que decide construir un equipo para manejar distintas áreas vitales: marketing, ingeniería y reclutamiento. Aunque cada integrante del grupo es inteligente y capacitado, todos presentan errores en diferentes niveles, causados más por las fallas del sistema que por sus habilidades personales. El primero de estos casos se refiere a Bob, el analista de marketing, quien debe preparar un pronóstico de crecimiento para un reporte trimestral.

Bob enfrenta un mar de datos, métricas confusas y falta de definición clara en términos como "activación" o datos pertinentes a usar. La falta de una jerarquía en la información o la existencia de múltiples fuentes sin una validación estricta generan que Bob entregue una presentación con resultados erróneos. El problema no radica en su capacidad, sino en que el entorno de consulta no ofrece las herramientas y el contexto necesario para tomar decisiones informadas. La solución adoptada por Alice implicó crear indicadores claros, asignar etiquetas de vigencia y calidad a los conjuntos de datos, y aportar una documentación exhaustiva para evitar malentendidos terminológicos. Un segundo ejemplo es el de Charlie, el ingeniero de software, quien bajo presión debe aplicar un parche para corregir un error crítico en el sistema de autenticación.

La urgencia, combinada con procesos poco definidos y revisiones superficiales, provoca que el arreglo termine generando un bloqueo que afecta a los usuarios. El problema aquí no es la incompetencia, sino la imposibilidad de reflexionar o elaborar un plan sólido antes de actuar. Para remediar esto, se implementan protocolos que priorizan la planificación previa, la autoevaluación de soluciones alternativas y revisión rigurosa enfocada en posibles riesgos, promoviendo tiempos para la exploración y discusión antes de desplegar cualquier cambio. Finalmente, el caso de Dave, encargado del reclutamiento, muestra cómo la ambigüedad y la falta de comunicación entre departamentos puede generar grandes desviaciones en los resultados. Dave recibe la tarea de cubrir todas las vacantes rápidamente usando un anuncio obsoleto y sin criterios claros ni canales de coordinación.

El resultado es una lista de candidatos poco adecuados y desordenada que no satisface las necesidades reales de la organización. Para evitar este tipo de errores, se establecen documentos de alcance detallados, mapas de colaboración y protocolos claros de aceptación y retroalimentación que permitan ajustar los objetivos en función de las prioridades y restricciones reales. Los patrones que emergen de estas historias son notables: los errores no suceden porque las personas son incapaces o negligentes, sino porque las condiciones en las que trabajan no están optimizadas para evitar ambigüedades, falta de contexto o presión indebida. Al impulsar el diseño de procesos inteligentes y sistemáticos, Alice logra que su equipo reduzca los errores de manera significativa, evidenciando el poder de la gestión basada en sistemas frente a la sobrecarga de trabajo individual o el castigo de fallas. Cuando trasladamos estos conceptos al trabajo con la inteligencia artificial y en particular con modelos de lenguaje, es fundamental entender sus limitaciones y cómo mejorar la interacción humana con esta tecnología.

A diferencia de una persona, una IA no aprende de forma continua a menos que se actualice su contexto manualmente de forma periódica. Por ello, es importante mantener actualizados los entornos y las instrucciones para evitar respuestas erróneas o "alucinaciones". Asimismo, a menudo las plataformas que albergan la IA contienen sistemas de instrucciones internas opacas que influyen en sus respuestas y que no siempre son transparentes para el usuario final. Para trabajar efectivamente con máquinas inteligentes, es recomendable aplicar las mismas lecciones que se usan para mejorar la colaboración humana: clarificar objetivos, definir restricciones de manera explícita, establecer criterios de validación y brindar contexto suficiente. Además, siempre es útil pedir clarificaciones o incluir cláusulas de salida para evitar comprometer procesos en situaciones inciertas.

En última instancia, la "ley de la inteligencia relativa" sugiere que cualquier sistema inteligente, ya sea humano o artificial, puede cometer errores cuando trabaja con información escasa, contradictoria o bajo presión, y cuando se le incentiva a dar una respuesta rápida más que a buscar certeza o pedir aclaración. Por lo tanto, el camino no está en eliminar totalmente los errores, sino en construir sistemas híbridos en los que humanos y máquinas colaboren, ajustando sus límites y apoyándose mutuamente para alcanzar mejores resultados. Esta perspectiva invita a reflexionar sobre cómo diseñamos nuestros entornos de trabajo, la interacción con las tecnologías emergentes y, en definitiva, la gestión de los procesos que sostienen nuestras organizaciones. Trabajar para detener las "alucinaciones" humanas y artificiales implica asumir una responsabilidad compartida: aprender a comunicar con precisión, diseñar sistemas adaptativos y mantener siempre viva la capacidad de cuestionar y validar las fuentes y los supuestos que guían nuestras decisiones.

![I tested every EU alternative to US digital products (ditching Big Tech) [video]](/images/6011A549-A7BF-4CE2-AB55-3019BDC9C38A)