En un mundo donde la inteligencia artificial (IA) avanza a pasos agigantados, un nuevo jugador ha surgido en la escena tecnológica, prometiendo revolucionar la forma en que interactuamos con los modelos de lenguaje. Este innovador modelo, denominado 'Reflection 70B', ha sido desarrollado por HyperWrite AI y se jacta de ser la solución a un problema persistente en la inteligencia artificial: las alucinaciones en los modelos de lenguaje de gran tamaño (LLM, por sus siglas en inglés). El CEO de HyperWrite AI, Matt Shumer, hizo el anuncio el 5 de septiembre de 2024 a través de una publicación en la plataforma X, destacando que 'Reflection 70B' se considera el modelo de código abierto más avanzado del mundo. Pero, ¿qué hace que este modelo sea único? La clave está en su capacidad para aprender de sus propios errores gracias a una técnica innovadora llamada "Reflection-Tuning" o afinación de reflexión. Este método permite al modelo evaluar y corregir sus respuestas, algo que muchos modelos actuales no pueden hacer.

Las alucinaciones en los LLM son un fenómeno donde el modelo genera contenido que, aunque puede parecer plausible, es en realidad falso o engañoso. Estos errores pueden resultar problemáticos, especialmente en aplicaciones donde la precisión es fundamental. Por ejemplo, un chatbot que proporciona información incorrecta podría conducir a decisiones erróneas, dañar la confianza del usuario y afectar la calidad del servicio. El desafío ha sido que la mayoría de los modelos de IA actuales no tienen la capacidad de reconocer cuándo están cometiendo un error, lo que puede llevar a respuestas imprecisas o engañosas. 'Reflection 70B' aborda este problema de manera innovadora.

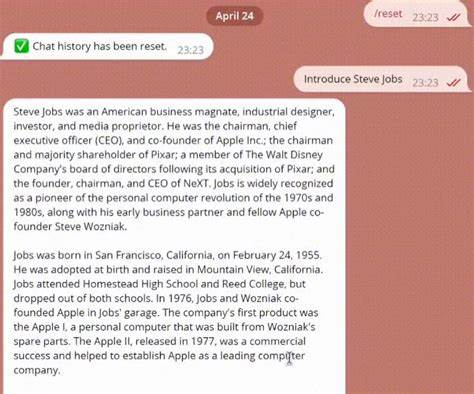

A través del proceso de "Reflection-Tuning", el modelo se alimenta de sus propias respuestas y es capaz de analizarlas, identificando sus fortalezas y debilidades. Este ciclo de autoevaluación permite al modelo refinar continuamente sus capacidades, acercándose a un nivel de autoconciencia que podría significativamente mejorar su rendimiento. Durante este proceso, el modelo no solo busca corregir sus errores, sino que también aprende a hacer frente a conceptos y contextos más complejos, lo que incrementalmente aumenta su eficacia y utilidad. Matt Shumer mencionó que, con el “promptering” adecuado, 'Reflection 70B' es increíblemente poderoso para una amplia variedad de casos de uso. Esta afirmación refuerza la idea de que, además de mejorar la autocrítica del modelo, también permite a los usuarios interactuar de manera más efectiva con la IA.

En un entorno donde la creatividad y la adaptación son esenciales, un modelo que no solo responde, sino que también aprende a proporcionarle respuestas más pertinentes y precisas, puede marcar una gran diferencia. Este avance se sitúa en un contexto donde los modelos de lenguaje, como el Claude 3.5 Sonnet de Anthropic y el GPT-4o de OpenAI, han establecido un estándar en este sector. Sin embargo, según Shumer, 'Reflection 70B' puede mantener el ritmo incluso frente a estos titanes de la IA. La competencia en este campo es feroz y continuamente evoluciona, lo que significa que cada avance tecnológico puede tener repercusiones significativas no solo para los desarrolladores, sino también para los consumidores de tecnología.

Es importante mencionar que el campo de la inteligencia artificial está continuamente siendo objeto de estudios y investigaciones. A finales de 2023, OpenAI publicó un documento de investigación que exploraba formas de prevenir alucinaciones en modelos de IA. Una de las ideas clave era el concepto de "supervisión de procesos", que implica recompensar a los modelos de IA no solo por llegar a conclusiones correctas, sino también por cada paso de razonamiento correcto que tomaron para llegar a esa conclusión. Esta propuesta resuena con la filosofía detrás de 'Reflection 70B', donde el aprendizaje de los errores se convierte en un camino hacia la precisión y la confiabilidad. La capacidad de detectar y mitigar errores lógicos en un modelo, o las alucinaciones mencionadas anteriormente, es un paso crítico hacia la construcción de una inteligencia artificial alineada con las necesidades y expectativas humanas.

En palabras de Karl Cobbe, un investigador de OpenAI, crear modelos que sean capaces de reconocer y rectificar sus fallos podría ser fundamental para el desarrollo de una inteligencia general artificial (AGI, por sus siglas en inglés). En un mundo donde la interacción humano-máquina es cada vez más frecuente, la importancia de contar con un modelo de IA que pueda aprender y adaptarse se vuelve evidente. Desde asistentes virtuales en empresas, chatbots en atención al cliente, hasta herramientas creativas que ayudan a los escritores y artistas, 'Reflection 70B' tiene el potencial de transformar la forma en que concebimos la inteligencia artificial. Promete mejorar tanto la precisión de las respuestas como la confianza del usuario en la tecnología, lo que podría abrir las puertas a aplicaciones aún no imaginadas. Además, es crucial destacar el impacto que esta tecnología puede tener en el ámbito educativo.

Un modelo que puede ajustar y corregir su propio comportamiento podría ser extremadamente valioso como tutor virtual o asistente de aprendizaje. Imagina un sistema educativo donde los estudiantes pueden interactuar con un modelo de IA que, al igual que un profesor, no solo proporciona respuestas, sino que también adapta su enfoque según las necesidades de cada alumno, aprendiendo constantemente de las interacciones previas. Sin embargo, como toda nueva tecnología, la implementación de 'Reflection 70B' y su técnica de reflexión-tuning no está exenta de desafíos. A medida que esta tecnología avanza, las consideraciones éticas y de privacidad también cobran relevancia. ¿Qué sucede con los datos utilizados para la autoevaluación? ¿Cómo se asegura que la IA no aprenda de manera sesgada o errónea? A medida que nos adentramos en la era de la inteligencia artificial avanzada, es crucial continuar el diálogo sobre la responsabilidad y la ética en la inteligencia artificial.

A pesar de las promesas que 'Reflection 70B' trae consigo, el camino hacia un futuro donde los modelos de IA son no solo precisos, sino también éticamente responsables, es uno que debemos recorrer con cuidado. En conclusión, 'Reflection 70B' representa un hito significativo en la búsqueda por mitigar las alucinaciones en los modelos de lenguaje. Con su técnica de reflexión-tuning, este modelo no solo tiene el potencial de mejorar la precisión de las respuestas, sino que también podría cambiar nuestra relación con la inteligencia artificial, haciéndola más confiable y útil. A medida que el panorama tecnológico continúa evolucionando, será fascinante observar cómo este modelo y otros similares impactarán en el futuro de la inteligencia artificial y sus aplicaciones en diversas industrias.