La inteligencia artificial (IA) se ha convertido en una tecnología transformadora en múltiples sectores, desde la salud hasta la educación, y desde la industria hasta la comunicación. Sin embargo, el crecimiento exponencial de los modelos de inteligencia artificial y su consumo energético ha generado una preocupación creciente: el posible impacto negativo en la crisis energética proyectada a nivel mundial. En este contexto, surge una pregunta crucial que atrae la atención de expertos y entusiastas por igual: ¿puede la IA ejecutada directamente en dispositivos locales, conocida como IA en el dispositivo o on-device AI, ser la clave para mitigar el consumo energético masivo asociado con la inteligencia artificial tradicional en la nube? En esta reflexión abordaremos las ventajas, limitaciones y realidades de la IA en el dispositivo desde una perspectiva energética, tecnológica y práctica. La inteligencia artificial tradicionalmente ha dependido de la computación en la nube para funcionar, lo que significa que los datos se envían a grandes centros de datos donde servidores potentes procesan los modelos de IA y devuelven las respuestas o acciones. Estos centros de datos utilizan una enorme cantidad de energía debido a la magnitud tanto de hardware especializado, como GPUs y TPUs avanzados, y la necesidad de refrigeración constante para evitar sobrecalentamientos.

La escala de esta infraestructura es indispensable para manejar modelos especialmente grandes, como los modelos de lenguaje con miles de millones de parámetros, que requieren recursos enormes para realizar inferencias. Aquí es donde entra en debate la IA en el dispositivo. La idea es que, en lugar de realizar estas operaciones complejas en la nube, los dispositivos personales, tales como teléfonos inteligentes, tabletas o incluso electrodomésticos inteligentes, puedan procesar la IA localmente. A primera vista, esta modalidad parece prometedora desde un punto de vista energético: evitar la transmisión constante de datos, reducir la demanda en los centros de datos y descentralizar el procesamiento con máquinas que ya forman parte del ecosistema cotidiano. Sin embargo, el tema no es tan sencillo.

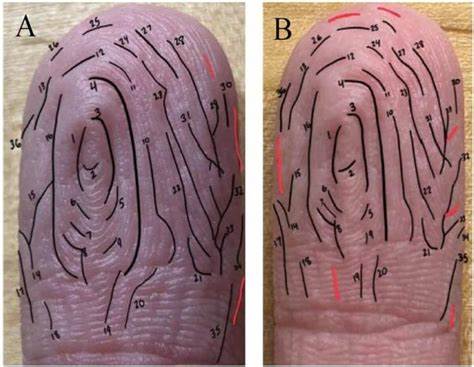

Uno de los principales retos técnicos radica en la capacidad computacional y la eficiencia energética de los dispositivos actuales. Los smartphones y otros dispositivos portátiles cuentan con procesadores cada vez más potentes, algunos diseñados específicamente para tareas de IA, pero todavía están muy lejos de la potencia y eficiencia energética que ofrecen los grandes centros de datos equipados con GPUs especializadas. Esto puede implicar que ejecutar modelos incluso de tamaño moderado pueda generar un consumo energético relatively alto debido al esfuerzo de cómputo en hardware limitado. Por ejemplo, algunos expertos han señalado que un pequeño modelo de lenguaje con alrededor de 1.000 a 4.

000 millones de parámetros, un rango en el que se encuentran ciertos LLMs (Modelos de Lenguaje a Gran Escala) ligeros, podría funcionar razonablemente bien en smartphones para tareas simples y rutinarias. Pero hay que entender que el trabajo que puede realizar un modelo tan pequeño es necesariamente limitado y que para tareas más complejas, la reducción del tamaño del modelo compromete la precisión y la funcionalidad. Los centros de datos, a pesar de su alto consumo, operan en un entorno optimizado y con hardware de muy alto rendimiento. Por ello, es posible que, en términos absolutos, sea más eficiente en energía ejecutar ciertas tareas de inferencia en un supercluster Nvidia o AWS que intentar forzar la misma operación en un dispositivo portátil. Esta aparente paradoja se debe a que la eficiencia energética no sólo depende del volumen de datos procesados, sino también de la velocidad y arquitectura del hardware utilizado.

Es esencial señalar que muchos desarrolladores y compañías exploran técnicas de compresión y optimización para modelos de IA, buscando que estos sean lo suficientemente livianos como para funcionar on-device sin penalizar en exceso la capacidad de respuesta. El uso de modelos «distillados» o simplificados y la mejora en chips específicos para IA como los Neural Processing Units (NPUs) evidencian la tendencia hacia la implementación local de IA. No obstante, todavía estamos lejos de una realidad donde la IA en el dispositivo pueda reemplazar completamente a la IA en la nube, especialmente en aplicaciones que demandan alto rendimiento o grandes volúmenes de datos en tiempo real. En términos energéticos, esto implica que la IA en el dispositivo puede ser complementaria, pero no reemplazará la necesidad de infraestructura en la nube. La descentralización puede distribuir el consumo energético de manera más uniforme, pero no lo elimina.

Más bien puede complementar el ecosistema, evitando la saturación de los centros de datos en tareas menos complejas y reduciendo la latencia y dependencia de conexión constante. Además, la reducción de transferencia de datos entre el dispositivo y la nube tiene beneficios colaterales relacionados con la privacidad y la seguridad, lo que puede incentivar su adopción en ciertos ámbitos, como la salud o la industria, donde el manejo de datos sensibles es crítico. En este escenario, la IA en el dispositivo no es sólo una cuestión energética, sino también una respuesta a la demanda de mayor control sobre la información generada por los usuarios. En otro aspecto importante, los avances en hardware especializado están acelerando la eficiencia energética de los dispositivos portátiles. Fabricantes de chips están integrando núcleos dedicados a IA que ejecutan inferencias con un consumo energético mucho menor que los procesadores tradicionales.

Esta evolución puede traer una mayor sostenibilidad a la IA en el dispositivo en el futuro cercano, aunque no es una solución definitiva para la crisis energética general asociada con la IA masiva. Por supuesto, la solución a la crisis energética global vinculada a la inteligencia artificial no depende exclusivamente de dónde se ejecutan los modelos, sino de una combinación de factores: innovación en hardware eficiente, optimización de algoritmos, fuentes de energía renovables para centros de datos, mejora en políticas de consumo energético y un uso consciente y responsable de la tecnología. En conclusión, la idea de que la IA en el dispositivo pueda por sí sola resolver la crisis energética proyectada es demasiado optimista. Si bien puede ofrecer ventajas significativas al reducir la dependencia de enormes infraestructuras centrales y al mejorar la eficiencia en tareas específicas, la escalabilidad y potencia que requieren los modelos más avanzados y útiles seguirán demandando centros de datos energéticamente intensivos por ahora. Sin embargo, la convergencia del desarrollo tecnológico en dispositivos locales y la mejora en eficiencia energética puede contribuir a un ecosistema de IA más equilibrado y sostenible.

Al mirar hacia adelante, la clave residirá en la integración inteligente entre IA en el dispositivo y IA en la nube, aprovechando lo mejor de ambos mundos para ofrecer soluciones potentes, eficientes y respetuosas con los límites energéticos del planeta. La innovación tecnológica debe ir acompañada por una visión consciente sobre el impacto ambiental, la optimización de recursos y políticas claras para asegurar que la inteligencia artificial siga siendo una herramienta que impulse el progreso sin comprometer el futuro energético global.