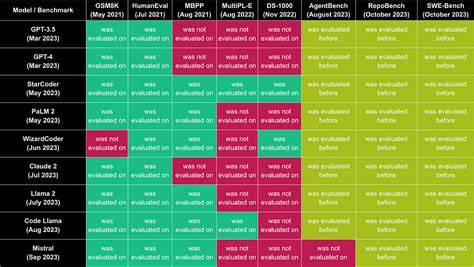

El campo de los modelos de lenguaje grande (Large Language Models, LLM) ha experimentado un crecimiento exponencial en los últimos años, transformando no solo la forma en que interactuamos con la tecnología, sino también la manera en que se desarrollan soluciones inteligentes en una amplia variedad de sectores. Ante el rápido avance y la proliferación de estos modelos, surge la necesidad de contar con sistemas de evaluación que permitan medir objetivamente su desempeño. En este contexto, el Meta-Leaderboard, que promedia los resultados de los modelos en 28 de los mejores benchmarks disponibles, se posiciona como una herramienta fundamental para entender el estado actual y futuro de los LLM. Los benchmarks, que son conjuntos estandarizados de tareas o pruebas, juegan un papel crucial en la medición del rendimiento de los modelos de lenguaje. Sin embargo, cada benchmark se enfoca en aspectos específicos como comprensión de texto, razonamiento, generación de lenguaje natural, traducción o análisis semántico.

Por ello, un enfoque integral que combine múltiples benchmarks resulta indispensable para obtener una visión global y equilibrada de las capacidades de un modelo. El Meta-Leaderboard es una iniciativa que responde precisamente a esta necesidad, al consolidar y promediar los resultados de los LLM en 28 benchmarks cuidadosamente seleccionados. Esta metodología permite identificar patrones de desempeño que pueden pasar desapercibidos cuando se analizan métricas aisladas. Además, facilita la comparación entre diferentes modelos de forma más justa y rigurosa, ayudando tanto a investigadores como a empresas a tomar decisiones informadas sobre qué tecnología implementar o desarrollar. Entre los aspectos medidos por el Meta-Leaderboard se encuentran la precisión en tareas de comprensión y generación de lenguaje, la capacidad de razonamiento lógico y contextual, la eficiencia computacional, y la adaptabilidad a diferentes dominios y lenguajes.

La combinación de estas variables proporciona un panorama amplio del rendimiento real de los modelos, alejándose de evaluaciones superficiales o sesgadas. Otra ventaja clave del Meta-Leaderboard es que fomenta la transparencia y la competitividad en la comunidad de IA. Al estandarizar criterios y proporcionar datos comparativos objetivos, impulsa a los desarrolladores a mejorar continuamente sus modelos y a innovar en técnicas que optimicen tanto la calidad del lenguaje como la eficiencia del procesamiento. Esta dinámica beneficia en última instancia a los usuarios finales, quienes reciben tecnologías más precisas, rápidas y versátiles. Para entender en profundidad qué significa el promedio del Meta-Leaderboard, es crucial examinar la diversidad de los benchmarks incluidos.

Algunos se centran en habilidades lingüísticas básicas, como la sintaxis y semántica, mientras que otros evalúan capacidades avanzadas de inferencia, comprensión contextual y manipulación de conocimiento. La ponderación equilibrada de estos distintos desafíos en el ranking global asegura que no se privilegie un tipo particular de tarea, sino que se reconozca la multifacética naturaleza del lenguaje humano. Además, el Meta-Leaderboard refleja cómo evoluciona el campo con el tiempo. A medida que aparecen nuevos modelos y técnicas, su impacto se puede medir directamente en este ranking, lo que permite monitorear tendencias, identificar líderes emergentes y detectar posibles áreas de mejora. Por ejemplo, el progreso en la reducción de sesgos, la incorporación de razonamiento lógico o la capacidad de aprendizaje con menos datos son factores que gradualmente modifican las posiciones en la tabla.

En el contexto empresarial, el Meta-Leaderboard actúa como una brújula para la inversión y desarrollo tecnológico. Las organizaciones que buscan implementar soluciones basadas en inteligencia artificial pueden usar estos datos para elegir modelos que no solo sean precisos, sino que también tengan la robustez y versatilidad necesarias para aplicaciones específicas, desde atención al cliente hasta análisis de grandes volúmenes de información. El alcance global de los benchmarks incluidos también facilita la internacionalización de los modelos, promoviendo la creación de LLM que funcionen eficazmente en múltiples idiomas y culturas. Esto es especialmente relevante en un mundo cada vez más conectado, donde la comunicación multilingüe y las soluciones personalizadas cobran mayor importancia. Finalmente, la consolidación de un Meta-Leaderboard con una base sólida y representativa marca un hito en la regulación y estandarización de la inteligencia artificial.

Al establecer parámetros claros para la evaluación, se generan condiciones más equitativas para la competencia y se reducen riesgos asociados a la implementación de tecnologías no verificadas o poco confiables. En conclusión, el Meta-Leaderboard que promedia los resultados de 28 benchmarks de referencia se presenta como una herramienta indispensable para comprender el verdadero desempeño de los modelos de lenguaje grande. Su capacidad para integrar una variedad de métricas y desafíos ofrece una visión completa y actualizada que impulsa el progreso tecnológico de manera responsable y fundamentada. A medida que la inteligencia artificial continúa avanzando, iniciativas como esta serán clave para maximizar su potencial y garantizar su impacto positivo en la sociedad.