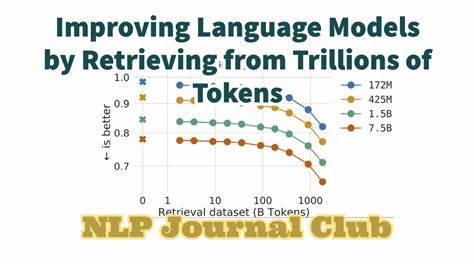

En la actualidad, la inteligencia artificial y especialmente los modelos de lenguaje han avanzado a pasos agigantados, transformando la manera en que interactuamos con la tecnología. Sin embargo, uno de los grandes retos y preocupaciones para investigadores, desarrolladores y usuarios finales ha sido entender y verificar cómo estos modelos generan sus respuestas, qué información utilizan realmente y de dónde obtienen su conocimiento. OLMoTrace surge como una innovación disruptiva en este ámbito, ofreciendo una transparencia sin precedentes al permitir rastrear las salidas de los modelos de lenguaje hasta sus conjuntos de datos de entrenamiento, que contienen trillones de tokens. La herramienta OLMoTrace, desarrollada por el Instituto Allen de Inteligencia Artificial (Ai2), se integra en el Playground de Ai2 y está disponible para varios de sus modelos insignia, incluyendo OLMo 2 32B Instruct, OLMo 2 13B Instruct y OLMoE 1B 7B Instruct. Esta función representa un compromiso claro con un ecosistema abierto que promueve modelos abiertos y datos accesibles para la comunidad científica, desarrolladores y el público general que busca comprender profundamente el funcionamiento interno de los modelos de inteligencia artificial.

Antes de la llegada de tecnologías como OLMoTrace, el funcionamiento interno de los modelos de lenguaje se venía percibiendo como una caja negra. Cuando un modelo generaba una respuesta, era difícil saber si esta provenía de conocimientos aprendidos a partir de datos confiables o simplemente de patrones memorizados o combinaciones creativas sin base real. Esta opacidad dificultaba la verificación de hechos, la comprensión de sesgos y el análisis del origen del contenido, problemas que ahora comienzan a resolverse gracias a la capacidad de OLMoTrace para conectar cada fragmento generado con sus fuentes originales de aprendizaje. El funcionamiento de OLMoTrace se basa en un complejo proceso técnico que detecta y resalta fragmentos del texto generado que coinciden literalmente con partes del conjunto de entrenamiento del modelo. El sistema identifica fragmentos largos y únicos, evitando expresiones muy genéricas o frases comunes, para facilitar el análisis y la interpretación.

Así, cuando un usuario accede a una respuesta generada, puede activar la opción “Show OLMoTrace” y observar cómo diferentes segmentos del texto cobran vida al evidenciarse sus correspondencias exactas con documentos reales del entrenamiento. Esta capacidad tiene un impacto significativo en la capacidad de fact-checking o verificación de hechos. Por ejemplo, si un modelo genera una afirmación específica, OLMoTrace permite identificar los documentos exactos en los cuales la información similar aparece. Si estas fuentes son confiables y verificadas, el usuario puede ganar confianza en que la respuesta es precisa y está basada en datos verdaderos. Pero también esta herramienta ayuda a detectar fragmentos menos relevantes o genéricos mediante un sistema de colores que indica el grado de especificidad y relación con el tema tratado.

OLMoTrace también tiene aplicaciones en áreas creativas y cognitivas de los modelos. En tareas de escritura creativa, donde la generación de contenido único y original es valiosa, la herramienta permite rastrear expresiones literarias o frases particulares hasta su origen en la base de datos de entrenamiento. Esto es crucial para estudiar cómo los modelos imitan estilos y construyen narrativas basadas en aprendizajes previos. Asimismo, la capacidad de los modelos para resolver problemas matemáticos también puede ser examinada a través de OLMoTrace. Se puede observar, por ejemplo, cómo un modelo resuelve problemas de combinatoria o cálculo de números binomiales simplemente porque dicha información o ejercicios similares aparecieron explícitamente en sus datos de entrenamiento, evidenciando la línea entre aprendizaje por memorización y razonamiento genuino.

Uno de los ejemplos reveladores aportados por Ai2 muestra cómo un modelo de 13 mil millones de parámetros generó una afirmación sobre su fecha de corte de conocimientos diferente a la real. Mediante OLMoTrace se identificó que esa información errónea se originaba en ejemplos de entrenamiento posteriores, lo que llevó a la organización a corregir sus datasets y mejorar la precisión del modelo. Este tipo de análisis fue imposible de realizar sin la tecnología de rastreo de OLMoTrace. Desde el punto de vista técnico, OLMoTrace enfrenta enormes desafíos debido a la magnitud y complejidad de los conjuntos de entrenamiento, que contienen billones de tokens distribuidos en miles de millones de documentos. Para superar esta barrera, la herramienta implementa una técnica avanzada llamada "infini-gram" y un algoritmo paralelo innovador que reduce dramaticalmente el tiempo necesario para buscar todas las coincidencias posibles de fragmentos dentro del vasto corpus de entrenamiento.

El proceso comienza con la tokenización del texto generado, seguido de la búsqueda de todos los subfragmentos que cumplen criterios específicos, como aparecer exactamente en el corpus, no estar fragmentados y ser lo bastante extensos para ser llamativos. Luego, OLMoTrace ordena estos fragmentos por una métrica de probabilidad de unigramas, que favorece la selección de frases con tokens menos comunes y más distintivos, aumentando así la relevancia de los fragmentos destacados. Cada fragmento registrado muestra hasta diez documentos donde aparece en la base de datos original, con una organización inteligente que elimina duplicados y fusiona fragmentos superpuestos para evitar saturar la interfaz del usuario. Además, para aumentar la utilidad, los documentos se ordenan según la relevancia al contenido actual que se está analizando mediante algoritmos de recuperación de información sofisticados, como BM25. El volumen de datos que maneja OLMoTrace es colosal.

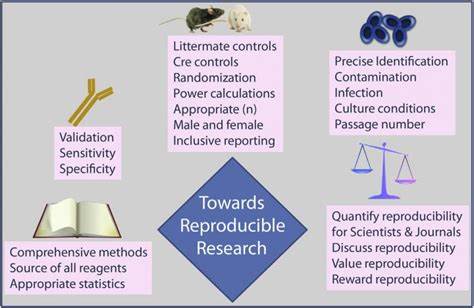

Para el modelo OLMo 2 32B Instruct, por ejemplo, la base de datos combina múltiples conjuntos de datos, que en conjunto suman alrededor de 3.2 mil millones de documentos y 4.6 billones de tokens, un panorama de información masivo al cual la herramienta puede referenciar en tiempo real. Los modelos más pequeños de la familia OLMo se apoyan en bases similares con ligeras variaciones impulsadas por datos post-entrenamiento distintos. El compromiso de Ai2 con la apertura y la transparencia se refleja ampliamente en la publicación del código fuente de OLMoTrace y la disponibilidad pública de los conjuntos de datos.

Este movimiento promueve un entorno de colaboración, donde la comunidad global puede aprovechar y perfeccionar estas tecnologías para entender mejor el impacto y la dinámica de los entrenamientos masivos en modelos de inteligencia artificial. En suma, OLMoTrace representa un avance trascendental en la búsqueda de confianza y explicación en la inteligencia artificial basada en lenguaje, permitiéndonos no solo cuestionar qué dice un modelo, sino comprender cómo y por qué llega a esas conclusiones. Esta transparencia es fundamental para un desarrollo responsable y ético de la IA, y sienta las bases para futuros avances en trazabilidad, auditoría y mejora continua de los sistemas inteligentes. A medida que la inteligencia artificial sigue integrándose en nuestra vida diaria, la capacidad de validar sus fuentes y entender su conocimiento será cada vez más crítica. Innovaciones como OLMoTrace no solo fortalecen la interpretación técnica sino que también empoderan a los usuarios, investigadores y reguladores a participar activamente en la evolución de estos sistemas, asegurando que su crecimiento sea confiable, justo y alineado con los valores de la sociedad.

La revolución en la transparencia de los modelos de lenguaje ya es una realidad gracias a OLMoTrace y el trabajo visionario del Allen Institute for AI.