En el campo del audio digital, la compresión de sonido ha sido esencial para permitir la transmisión y almacenamiento eficiente de música, voces y otros sonidos. Tradicionalmente, codecs como MP3 y Ogg Vorbis han dominado el mercado, facilitando la reducción de tamaño de los archivos sin sacrificar demasiado la calidad percibida. Más recientemente, con la llegada de tecnologías basadas en inteligencia artificial y aprendizaje profundo, han surgido codecs neuronales como el Encodec desarrollado por Meta o el Codec de Audio de Descript, que emplean modelos avanzados para optimizar la codificación de audio. Sin embargo, a pesar de sus evidentes ventajas en términos de calidad y funcionalidad, muchos de estos sistemas están basados en divisiones de audio en bloques o frames de tamaño fijo y sobrepuestos, lo que dificulta la interpretación directa y natural de la representación interna del sonido codificado. La idea de desarrollar un codec de audio que sea a la vez escaso e interpretable surge como un desafío innovador que puede transformar la forma en que entendemos y operamos con la codificación de audio.

Un codec escaso trata de representar el audio utilizando un número limitado y esencial de elementos o eventos claves, minimizando la redundancia y capturando únicamente la esencia del sonido. La interpretabilidad, por su parte, implica que la estructura interna de la codificación pueda ser comprendida fácilmente, tanto para tareas de análisis, manipulación o generación de audio posterior. Un reciente artículo presentado por John Vinyard en arXiv explora un concepto pionero de encoder de audio que rompe con la ortodoxia del codec basado en bloques. Este encoder reemplaza la segmentación fija por una representación basada en eventos y sus tiempos de ocurrencia, introduciendo una codificación mucho más próxima a cómo percibimos y generamos el sonido en el mundo real. Mediante la incorporación de modelos rudimentarios basados en la física del sonido, se simulan dos aspectos fundamentales: el ataque o inicio del sonido y la resonancia física que caracteriza tanto al instrumento que lo produce como el entorno en que se ejecuta la grabación.

Este planteamiento tiene un doble propósito. En primer lugar, busca fomentar una representación que sea parsimoniosa, es decir, que contenga solo la información estrictamente necesaria para reconstruir el audio con fidelidad aceptable. La parsimonia en la codificación no solo reduce el tamaño del archivo sino que facilita el procesamiento y análisis posterior de la información almacenada. En segundo lugar, se prioriza la interpretabilidad, permitiendo que cada evento codificado tenga significado claro y coincida con fenómenos sonoros perceptibles, como golpes, notas y reverberaciones específicas. La codificación basada en eventos puede entenderse como una traducción del sonido continuo en una serie de sucesos discretos, cada uno con atributos propios que describen su intensidad, frecuencia y duración, además del contexto físico implícito.

Por ejemplo, el ataque de una nota producida por un piano no solo se codifica como un patrón de frecuencias, sino que también se asocia a un fenómeno físico específico: la interacción del martillo con las cuerdas, seguida por la resonancia del cuerpo del instrumento y finalmente la reverberación en la sala. Este tipo de modelo tiene implicaciones profundas para diversas aplicaciones. En primer término, un codec interpretable facilita tareas como la manipulación puntual del audio, permitiendo modificar aspectos concretos como la resonancia o el ataque de una nota sin afectar otras partes del sonido. Esto abre la puerta a una edición de audio más intuitiva y detallada que va más allá de la simple manipulación de espectrogramas o formas de onda. Además, una representación escasa puede ser de gran utilidad para proyectos relacionados con la inteligencia artificial aplicada al audio.

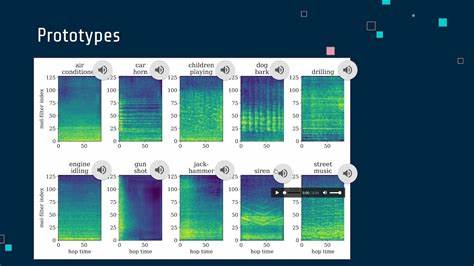

Por ejemplo, modelos de síntesis sonora, reconocimiento musical o clasificación de sonidos pueden beneficiarse de una descripción menos redundante y más alineada con la percepción y física del sonido. La codificación basada en eventos también podría facilitar la generación de contenido auditivo generado por IA, al dar acceso a parámetros claros y maniobrables relacionados con aspectos físicos y temporales del sonido. Sin embargo, la implementación práctica de un codec basado en eventos requiere varios desafíos técnicos. La detección precisa y robusta de eventos musicales o acústicos a partir de señales de audio complejas es un problema activo en la investigación en procesamiento de señales. Es necesario desarrollar algoritmos que identifiquen y segmenten los ataques y resonancias en escenarios reales con ruido, interpretando correctamente la superposición de sonidos y ecos naturales.

Asimismo, modelar el espacio físico y las características del instrumento requiere simplificaciones adecuadas para no incrementar de manera significativa la complejidad del encoder o la cantidad de datos codificados. El uso de principios básicos de acústica, junto con data-driven learning, puede ser una vía para encontrar ese balance entre realismo y eficiencia computacional. En contraste con los codecs tradicionales que priorizan la tasa de compresión y la calidad perceptual, esta nueva aproximación impulsa un paradigma que prioriza la inteligibilidad de la representación sonora. Esto es especialmente relevante para entornos donde la comprensión del contenido sonoro tiene un valor añadido, como en musicología, educación musical, restauración de audio o incluso terapias sonoras. La comunidad de investigación y desarrollo en audio digital está atenta a la evolución de estos enfoques que, aún en etapa de prueba de concepto, prometen transformar tanto el fundamento técnico como la experiencia del usuario con contenido sonoro.