En un mundo cada vez más guiado por los datos, comprender no solo qué está correlacionado sino qué es causante se ha convertido en una necesidad fundamental para la ciencia, la economía, la salud y la tecnología. La inferencia causal surge como la disciplina que nos permite desentrañar la relación causa-efecto a partir de datos observacionales o experimentales. Especialmente para quienes se atreven a enfrentar los retos y complejidades de esta área, "Inferencia Causal para los Valientes y Verdaderos" es una referencia que promete un aprendizaje riguroso pero accesible. Esta obra combina conceptos sólidos con un espíritu fresco, haciendo especial énfasis en el uso de Python y en una aproximación didáctica que no rehúye el humor ni la claridad. Los cimientos de la inferencia causal descansan en la capacidad de formular preguntas precisas que busquen entender qué pasa si se realiza una intervención o cambio en un sistema.

Los modelos tradicionales de análisis estadístico, centrados en la correlación, no bastan, ya que la correlación no implica causalidad. La inferencia causal, por tanto, utiliza un conjunto de herramientas conceptuales y metodológicas para identificar efectos causales confiables y minimizar sesgos o confusiones. La estructura fundamental que ofrece "Inferencia Causal para los Valientes y Verdaderos" divide su contenido en dos grandes partes: "El Yang" y "El Yin". La primera parte establece el marco conceptual y estadístico clásico que ha sido comprobado y consolidado a lo largo de décadas. En ella se introducen desde los experimentos aleatorios, pasando por modelos gráficos causales, hasta técnicas avanzadas como variables instrumentales y diseños de regresión discontinua.

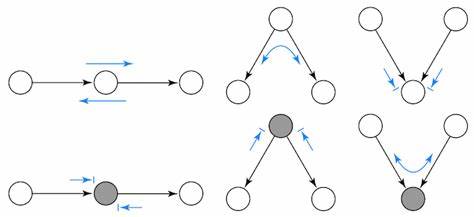

Esta sección no solo proporciona una base sólida sino que también ayuda a familiarizarse con terminología y problemas clásicos, como el sesgo por confundidores o el incumplimiento en experimentos. Uno de los temas clave abordados es la representación formal de preguntas causales mediante la notación de resultados potenciales, que permite conceptualizar qué resultados esperaríamos bajo diferentes escenarios o tratamientos. También se introduce la importancia de los gráficos causales para representar visualmente relaciones entre variables y detectar posibles fuentes de sesgo o variables confusoras. Estas herramientas forman el esqueleto con el cual se puede empezar a construir análisis causales rigurosos. La efectividad de técnicas como la regresión lineal es explorada a fondo, ilustrando su poder y sus limitaciones cuando se trata de inferir relaciones causales.

Se abordan extensiones como regressiones con variables ficticias (dummy) y aprobaciones que van más allá de los habituales métodos para controlar variables confundidoras, mostrando caminos hacia análisis más robustos. Las técnicas avanzadas como el uso de variables instrumentales se presentan como soluciones cuando existen problemas de endogeneidad, es decir, cuando el tratamiento o intervención está correlacionada con el error del modelo. Se discute también cómo tratar la no adherencia al tratamiento (non compliance) y cómo estimar efectos locales promedio para grupos específicos. Estos conceptos son esenciales para trabajos aplicados en economía, salud pública o cualquier área donde el control experimental sea parcial o imperfecto. Metodologías modernas y casi revolucionarias, como el emparejamiento (matching) y el puntaje de propensión (propensity score), son explicadas con ejemplos en Python que permiten a los lectores aplicar directamente las técnicas, facilitando la transición de la teoría a la práctica.

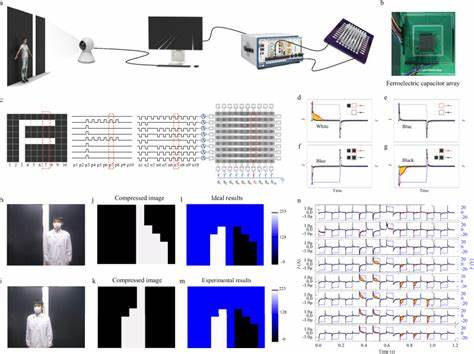

Se enfatiza la importancia de crear grupos comparables para simular un experimento aleatorio cuando no es posible realizarlo de forma controlada. Dentro de los diseños cuasi-experimentales, los métodos de diferencia en diferencias, datos de panel con efectos fijos, controles sintéticos y diseños de regresión discontinua son detallados como estrategias para aislar efectos causales en escenarios complejos. Estos enfoques son fundamentales para estudios en políticas públicas, economía y otras ciencias sociales donde los experimentos aleatorios son imposibles o poco éticos. La segunda parte de la obra, aunque en desarrollo, abre la puerta a un mundo más experimental y orientado a las aplicaciones tecnológicas. Aquí se exploran los modelos predictivos y el análisis de efectos heterogéneos, donde se reconoce que los tratamientos pueden tener impactos diferentes según el subgrupo que se analice.

Esta personalización es clave en áreas como la medicina personalizada, recomendadores y marketing digital. En esta sección también se discuten métodos modernos llamados meta-aprendices (meta learners), aprendizaje ortogonal o des sesgado, así como las dificultades que presentan la heterogeneidad y no linealidad en la estimación de efectos causales. La sensibilidad al contexto y la necesidad de modelos plug-and-play acercan la inferencia causal a usuarios más prácticos y profesionales de la tecnología. Un valor adicional de la obra es la sección de apéndices donde se abordan temas complejos como la eliminación de sesgos mediante ortogonalización o uso del puntaje de propensión, los límites de los modelos predictivos para inferencia causal, y cómo extender el enfoque de controles sintéticos bajo incertidumbre con inferencia conforme. El enfoque del libro es abierto, libre y colaborativo, fomentando una comunidad de aprendizaje basada en software libre, específicamente Python.