En la era digital, la inteligencia artificial (IA) juega un papel trascendental en la forma en que consumimos y procesamos la información. Los modelos de IA, como los que emplean algoritmos de aprendizaje automático y procesamiento del lenguaje natural, utilizan grandes volúmenes de datos provenientes de diferentes sitios web para responder consultas, generar contenidos o realizar investigaciones. Esto ha generado una gran curiosidad y, sobre todo, interés por entender si es posible influir en el ranking de los sitios web que estos modelos utilizan como fuente de información. Para comprender si esta influencia es viable, primero es necesario entender cómo funcionan los modelos de IA en cuanto a la selección y ponderación de datos. Estos modelos no navegan en internet como un usuario común; en su lugar, se entrenan con conjuntos masivos de documentos, bases de datos y páginas web que han sido recopiladas y procesadas previamente.

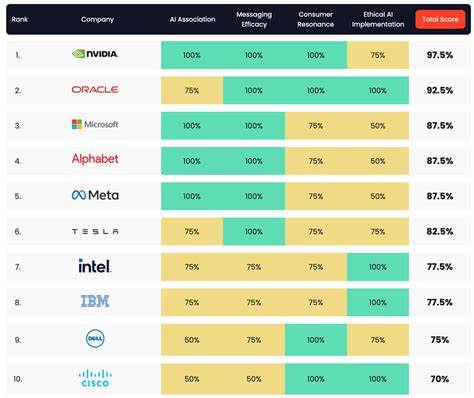

Las fuentes más confiables, relevantes y populares suelen tener una mayor probabilidad de alimentar el conocimiento del modelo y por ende aparecer en sus resultados o recomendaciones. El ranking de un sitio web está vinculado a varios factores que también aplican en las búsquedas convencionales de motores como Google o Bing. Entre estos factores destacan la autoridad del dominio, la calidad del contenido, la frecuencia de actualización, la relevancia temática y la experiencia del usuario. En teoría, si un sitio mejora en estos aspectos, aumenta su probabilidad de estar entre las fuentes preferidas por los algoritmos de IA. No obstante, este proceso no es lineal ni sencillo.

La recopilación de datos para entrenar a un modelo de IA depende de múltiples variables que no siempre son transparentes para el público, como políticas de selección de datasets, restricciones de licencias, o incluso sesgos inherentes a los programadores y los sistemas automáticos que recopilan la información. Esto puede explicar, por ejemplo, por qué algunos sitios con alto tráfico no son tan visibles en las respuestas generadas por IA, mientras otras páginas menos populares logran destacar. Los especialistas en SEO (optimización para motores de búsqueda) pueden intentar mejorar el posicionamiento de sus sitios aplicando estrategias tradicionales como la generación de contenido de alta calidad, optimización técnica, backlinks, y experiencia de usuario. Pero cuando se trata de modelos de IA, es mucho más complejo. La simple popularidad o volumen de visitas no garantiza inclusión en los datasets que los modelos utilizan, principalmente porque estos entrenamientos tienen ciclos definidos y fuentes curadas de información.

Existe también la posibilidad de "sesgo de búsqueda" o muestreo limitado, que puede originar resultados skews o sesgados. Esto quiere decir que, incluso si un sitio cumple con criterios esenciales, puede quedar relegado debido a desequilibrios temporales en la recopilación de datos o prioridades internas de los desarrolladores del modelo. Por lo tanto, influir directamente en el ranking para un modelo de IA podría requerir estrategias más sofisticadas y a largo plazo. Un factor clave es la autoridad y la reputación que los sitios web generan en una comunidad online amplia y establecida. Si una página web logra ser citada con frecuencia, recomendada en medios respetados, y mantenida con información confiable y actualizada, aumenta su posibilidad de ser considerada una fuente valiosa para los modelos.

Esto puede ser reforzado por colaboraciones con instituciones académicas, publicaciones en revistas confiables, y la contribución en foros reconocidos por profesionales del área. Otro aspecto a destacar es la naturaleza dinámica de la web y de los modelos de IA. Los datos con los que se entrenan estas inteligencias pueden estar sujetos a actualizaciones periódicas, por lo que un sitio reciente o recién optimizado podría no aparecer inmediatamente entre las fuentes utilizadas. Esta latencia significa que la influencia sobre el ranking tiene un componente temporal que debe considerarse para evaluar resultados sostenibles. Además, hay prácticas poco éticas o controvertidas que intentan manipular artificialmente el ranking, como la creación masiva de enlaces falsos, contenido duplicado o spam.

Aunque estas técnicas podrían generar un aumento temporal en la visibilidad, no solo pueden ser penalizadas por motores de búsqueda tradicionales, sino que también es probable que los modelos de IA las reconozcan como poco confiables y las excluyan de sus bases de datos. La transparencia y editorialización en los procesos de selección para entrenamiento de IA también están en debate. Algunas plataformas y organizaciones promueven la creación de datasets abiertos y auditables, con la intención de que la comunidad pueda entender cómo se eligen las fuentes y detectar posibles sesgos. Estos esfuerzos pueden garantizar que solo la información verificada y de buena calidad componga el material de entrenamiento, haciendo más difícil la influencia indebida pero fomentando una competencia más justa entre los sitios. En resumen, aunque no es imposible intentar influir en el ranking de los sitios web que utilizan los modelos de IA para investigar, es un proceso mucho más complejo y menos directo que el posicionamiento en motores de búsqueda tradicionales.