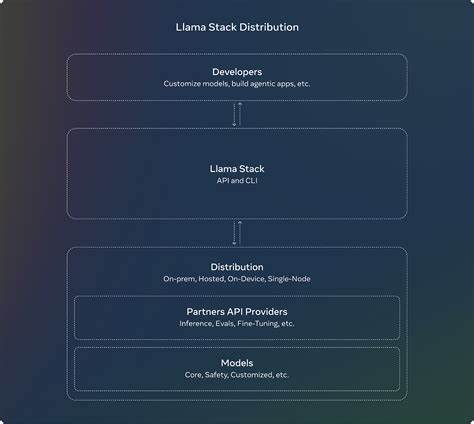

En el mundo digital actual, las aplicaciones de chat se han convertido en una herramienta imprescindible para la comunicación tanto personal como profesional. El auge de la inteligencia artificial y las tecnologías basadas en modelos de lenguaje amplios (LLM, por sus siglas en inglés) ha revolucionado la forma en que interactuamos con estas plataformas. Un claro ejemplo de esta evolución es la creación de aplicaciones de chat que integran Meta Llama-Stack junto con las integraciones MCP, ofreciendo soluciones potentes, escalables y eficientes para usuarios y desarrolladores. Meta Llama-Stack representa un conjunto avanzado de herramientas y entornos diseñados específicamente para gestionar modelos de lenguaje grandes. Gracias a su arquitectura y optimizaciones, permite realizar inferencias robustas y rápidas, lo que es fundamental para mantener conversaciones naturales y fluidas en aplicaciones de chat.

MCP, o Multi-Client Platform, añade otro nivel de funcionalidad, facilitando la integración de diversas fuentes y servicios, así como la coordinación eficiente entre ellos. Para quienes desean desarrollar su propia aplicación de chat con estas tecnologías, existen varias etapas fundamentales que garantizan el éxito del proyecto. Primero, es imprescindible contar con el entorno adecuado y las dependencias necesarias para manejar el modelo Llama y la plataforma MCP. En este sentido, uno de los requerimientos es la instalación de Ollama, un servicio que permite realizar inferencias locales y trabajar con los modelos de Meta directamente desde el dispositivo del usuario, reduciendo la latencia y ofreciendo mayor privacidad. La instalación de Ollama es sencilla: basta con descargar el software oficial desde su sitio web, instalarlo y ejecutar el servicio con comandos básicos en la terminal.

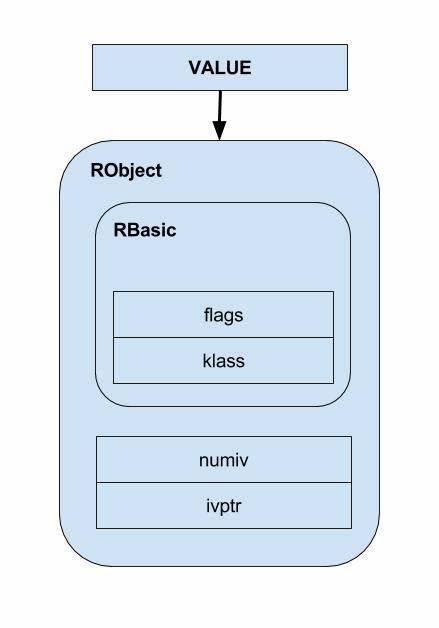

Esto asegurará que el entorno para el procesamiento del modelo esté activo y listo para responder a las solicitudes de chat. Además, si se prefiere no depender de una infraestructura local, existe la opción de utilizar la API de Together.ai, que proporciona acceso remoto a los mismos modelos de lenguaje, facilitando la implementación sin necesidad de administrar servicios locales. Una vez establecido el entorno de inferencia, el siguiente paso es configurar el Llama-Stack. Este stack específico gestiona la interacción con los modelos y permite adaptar el comportamiento de la aplicación según las necesidades particulares.

Para ello, se recomienda utilizar el gestor de paquetes uv y crear un entorno virtual de Python. Esto aislará las dependencias del proyecto y facilitará la gestión futura de actualizaciones o cambios. Con el entorno preparado, se debe clonar el repositorio oficial de la aplicación de chat desarrollada con Meta Llama-Stack y MCP. Este repositorio contiene no solo el código fuente, sino también ejemplos, herramientas y configuraciones esenciales para una implementación exitosa. Junto a los archivos principales, es importante revisar y editar archivos de configuración como el .

env, donde se incluirán claves de API y variables que determinan si el servicio utilizará Ollama localmente o se conectará a Together.ai. La integración de MCP es fundamental para enriquecer la aplicación de chat. MCP permite manejar múltiples clientes y servicios simultáneamente, lo que facilita la incorporación de funcionalidades adicionales como herramientas internas, bases de datos, o incluso motores de búsqueda que mejoran la experiencia del usuario. Gracias a esta integración, la aplicación no solo responde a las consultas básicas, sino que puede procesar tareas complejas y coordinar varios servicios de manera transparente.

Otra ventaja destacada del uso de Meta Llama-Stack junto con MCP es la flexibilidad para adaptar el modelo a distintos escenarios. Por ejemplo, se puede configurar el modelo para que actúe como asistente virtual, moderador de contenido, agente de soporte o cualquier otro rol específico, simplemente ajustando las instrucciones y parámetros dentro del Llama-Stack. Esto convierte a la aplicación en una herramienta altamente personalizable y preparada para satisfacer demandas variadas. El despliegue de la aplicación suele realizarse a través de Gradio, una plataforma sencilla y accesible que permite crear interfaces web interactivas para modelos de aprendizaje automático sin complicaciones técnicas excesivas. Al ejecutar la aplicación con Gradio, los desarrolladores pueden acceder a una interfaz funcional directamente desde el navegador, probar diferentes funcionalidades, y realizar ajustes en tiempo real.

Esto acelera el ciclo de desarrollo y garantiza que la experiencia del usuario final sea óptima. Durante el proceso de instalación y ejecución, es común enfrentar ciertos retos que pueden incluir problemas de dependencias, configuración incorrecta del entorno virtual o fallos en la activación del servicio Ollama. Para superar estos obstáculos, es recomendable verificar que todos los servicios estén corriendo adecuadamente, que la versión de Python utilizada sea compatible, y que las claves y variables de entorno estén correctamente establecidas. Más allá de su potencial técnico, la creación de una aplicación de chat con estas características también plantea reflexiones importantes sobre la privacidad y la seguridad. Al contar con la opción de realizar inferencias localmente mediante Ollama, los desarrolladores pueden reducir la cantidad de datos que salen de los dispositivos del usuario, mitigando riesgos asociados a la exposición de información sensible.

Al mismo tiempo, la modularidad del sistema asegura que las actualizaciones de seguridad y mejoras en los modelos puedan implementarse sin interrumpir la operación. El impacto de estas tecnologías en diferentes sectores es evidente. En el ámbito empresarial, aplicaciones construidas con Meta Llama-Stack y MCP pueden automatizar la atención al cliente, gestionar solicitudes internas o mejorar la colaboración entre equipos mediante chatbots inteligentes. En educación, facilitan tutorías personalizadas y el acceso a información relevante en tiempo real. Incluso en el entretenimiento, abren la puerta a experiencias conversacionales más inmersivas y naturales.

La comunidad que rodea estas tecnologías es otro punto a destacar. Al ser en gran medida open source y contar con un ecosistema activo, los desarrolladores tienen acceso a documentación detallada, foros de discusión y proyectos complementarios que aceleran el aprendizaje y estimulan la innovación. Compartir experiencias y contribuir a la evolución del software asegura que estas soluciones sigan adaptándose a las necesidades cambiantes del mercado. En definitiva, la combinación de Meta Llama-Stack, Ollama y MCP representa un avance significativo en el desarrollo de aplicaciones de chat sofisticadas y versátiles. Si bien el camino de la implementación requiere atención a detalles técnicos y una curva de aprendizaje, los beneficios obtenidos en cuanto a rendimiento, personalización y escalabilidad justifican ampliamente el esfuerzo.

Para quienes se aventuren en este viaje tecnológico, es recomendable mantenerse actualizados con la evolución de los modelos de lenguaje y las plataformas asociadas, experimentar con diferentes configuraciones y compartir sus resultados con la comunidad. Así, no sólo se aprovecharán al máximo las capacidades actuales, sino que también se contribuirá a moldear el futuro de la comunicación digital. Desarrollar una aplicación de chat con Meta Llama-Stack y MCP no es simplemente crear otro chat más; es construir una plataforma inteligente que aprovecha la inteligencia artificial para transformar la interacción humana, hacerla más eficiente, segura y personalizada. En un mundo digital que avanza rápidamente, contar con herramientas y soluciones de esta magnitud marca la diferencia y abre nuevas posibilidades para empresas, usuarios y desarrolladores por igual.