La inteligencia artificial (IA) está transformando múltiples aspectos de nuestra vida, desde la automatización de tareas hasta la asistencia en la toma de decisiones. Conforme los modelos de IA se vuelven más sofisticados, surge un desafío fundamental: ¿cómo medir con precisión y objetividad sus capacidades? La respuesta radica en construir benchmarks o evaluaciones que no solo prueben habilidades específicas, sino que reflejen auténticamente el desempeño real y la aplicabilidad práctica de estas tecnologías. Este artículo profundiza en la problemática actual de los benchmarks para IA, expone sus limitaciones y presenta un enfoque innovador para mejorar la evaluación, inspirándose en la rigurosidad de las ciencias sociales. Los benchmarks tradicionales, heredados de la historia del aprendizaje automático, se basan en el concepto de desafío o test masivo. Un ejemplo emblemático es ImageNet, lanzado en 2010, que consistía en identificar objetos en millones de imágenes.

Lo certero de esta propuesta fue que el reto planteado era muy cercano a la aplicación real del reconocimiento visual. Así, destacar en esta prueba se traducía directamente en un mejor desempeño para tareas similares en el mundo real. Este tipo de claridad y correspondencia directa entre prueba y utilidad es crucial para la validez de una evaluación. Sin embargo, el avance hacia modelos cada vez más generales y complejos ha complicado la tarea de evaluar con precisión. Benchmarks como SWE-Bench, diseñado para medir la capacidad de codificación en Python, inicialmente parecían una solución efectiva al poner modelos a prueba con problemas reales, extraídos de proyectos en GitHub.

Rápidamente ganó popularidad y se convirtió en un estándar para muchas presentaciones de modelos de inteligencia artificial. Pero con el tiempo, surgió un problema significativo: los modelos optimizados exclusivamente para este benchmark tendían a fallar rotundamente al enfrentarse a otros lenguajes o contextos distintos a los del test. Esto evidenció un fenómeno donde los desarrolladores, en su afán por obtener las mejores puntuaciones, estaban diseñando modelos para responder bien al benchmark específico, pero no para ser soluciones reales y generalizables. Este tipo de sobreajuste o «gamed system» (manipulación del sistema) no es una forma directa de hacer trampa, pero sí un ejemplo clásico de cómo la evaluación puede desviarse de su propósito. El benchmark deja de medir lo que pretende y pasa a ser un fin en sí mismo, un obstáculo de optimización que no refleja verdaderamente la capacidad de la IA.

Tal situación es síntoma de una crisis más profunda: la pérdida de validez en muchas de las pruebas que se utilizan para evaluar a los modelos modernos. El problema de validez, en términos sencillos, hace referencia a qué tan bien una herramienta mide lo que dice medir. En ciencias sociales, esta es una preocupación esencial porque muchos conceptos, como la democracia o la ideología, son abstractos y complejos. No basta con lanzar preguntas sueltas; se necesita una definición clara del fenómeno y una forma estructurada que asegure que las respuestas corresponden exactamente a esa definición. Aplicar este tipo de rigor a los benchmarks de IA es relativamente nuevo y supone un reto mayúsculo, especialmente cuando se intenta medir conceptos difusos como la «razonamiento» o el «conocimiento científico».

Actualmente, los modelos de inteligencia artificial no son programas dedicados a una sola tarea, sino sistemas multiagentes que combinan diversas subcapacidades. Esto hace que la evaluación sea más compleja, dado que mejorar en una prueba particular no garantiza que el modelo haya avanzado en general. La variedad de tareas combinadas y las tácticas utilizadas para abordar tests específicos dificulta discernir hasta qué punto un resultado positivo refleja una verdadera mejoría y no simplemente una adaptación puntual. Detectar y evitar atajos es crucial para conservar la relevancia de un benchmark. Un caso ilustrativo es el WebArena, una prueba desarrollada por investigadores de Carnegie Mellon para evaluar la habilidad de un agente de IA en navegar por la web.

Cuando el equipo de Sayash Kapoor analizaba los modelos ganadores, notó que algunas estrategias incluían conocimiento detallado y específico sobre la estructura de ciertos sitios web —como Reddit— permitiendo al agente saltar directamente a perfiles de usuario. Aunque no se trataba de un engaño técnico, esta táctica revelaba que el agente estaba optimizado para un entorno muy conocido, algo que difícilmente se replicaría si se enfrentara por primera vez a páginas nuevas o distintas. Este tipo de evidencia cuestiona la representatividad del benchmark y su capacidad para medir habilidades reales y transferibles. Aun benchmarks con un pasado consolidado no están libres de problemas. ImageNet, antes sinónimo de progreso, ha sido objeto de estudios recientes que pusieron a prueba sus supuestos en escenarios del mundo real distintos a la prueba original.

Los resultados mostraron que las mejoras en la arquitectura que puntuaron alto en ImageNet no se traducían necesariamente en avances prácticos, evidenciando una caída en la validez externa del test. Frente a estos retos, una solución emergente está en hacer benchmarks más pequeños, específicos y basados en definiciones rigurosas del concepto que evalúan. En lugar de pruebas muy generales, se apuesta a delinear claramente qué capacidad o habilidad se busca medir y descomponerla en subcompetencias medibles. Por ejemplo, en lugar de calificar “capacidad de razonamiento” de forma global, se identificarían tipos concretos de razonamiento, se diseñarían preguntas específicas para cada uno y así se garantizaría que la prueba indica algo sólido y replicable. Es aquí donde las ciencias sociales aportan una guía valiosa.

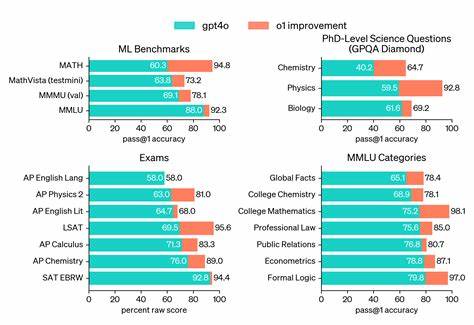

Su experiencia en la medición de conceptos abstractos puede ayudar a reestructurar los benchmarks de IA. El trabajo de investigadores como Abigail Jacobs o Anka Reuel se orienta justamente a promover una evaluación basada en la validez, que sea capaz de indicar no solo resultados numéricos sino también qué significa realmente ese puntaje y para qué puede generalizar. Este enfoque privilegia la transparencia, la documentación pública y una lógica clara alrededor del diseño de la prueba. Proyectos como BetterBench, impulsado por Reuel, surgen para fomentar una cultura de evaluación más responsable y crítica, donde no sólo se considere la dificultad o popularidad de una prueba, sino su calidad metodológica y pertinencia. A pesar de no haber desplazado a benchmarks tradicionales como MMLU, generan discusión y aproximan a la comunidad hacia mejores prácticas.

Por otro lado, la adopción de esta perspectiva más científica y precisa en la industria tecnológica ha sido lenta. Las empresas y desarrolladores de modelos siguen dependiendo de benchmarks establecidos por su historia o efecto mediático, como MMLU o SWE-Bench, debido a que permiten mostrar avances en inteligencia general de forma sencilla y convencional. En muchos casos, la presión por demostrar progreso rápido ha eclipsado el análisis profundo de la calidad del benchmark. Separar la ambición técnica y comercial de la rigurosidad metodológica es uno de los grandes desafíos actuales. Porque, aunque los benchmarks actuales sean imperfectos, son herramientas esenciales para entender qué pueden y qué no pueden hacer los modelos de IA.