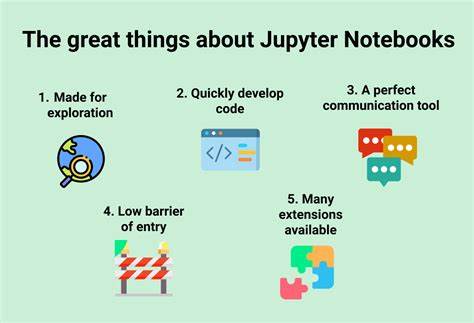

Jupyter Notebooks se han convertido en una herramienta esencial para los científicos de datos en todo el mundo. Su capacidad para combinar código, visualización de datos y documentación en un solo entorno interactivo ha revolucionado la forma en que realizamos análisis de datos y desarrollamos modelos de machine learning. Este artículo se propone explorar en profundidad cómo utilizar Jupyter Notebooks para impulsar tu trabajo en la ciencia de datos, ofreciéndote una guía comprensiva para maximizar su potencial. Para empezar, es importante entender qué es Jupyter Notebook. Jupyter es una aplicación web de código abierto que permite crear y compartir documentos que contienen código en vivo, ecuaciones, visualizaciones y texto narrativo.

Aunque admite varios lenguajes de programación, como R y Julia, Python es el más popular en la comunidad de ciencia de datos. Esta versatilidad lo hace adecuado para una amplia variedad de tareas, desde análisis exploratorio de datos hasta implementaciones avanzadas de machine learning. La instalación de Jupyter es sencilla. Puedes hacerlo mediante el gestor de paquetes de Python, pip, o utilizando Anaconda, que es una distribución que incluye Jupyter y muchas bibliotecas de ciencia de datos esenciales. Una vez instalado, puedes iniciar Jupyter Notebook desde la terminal de tu sistema.

Esto abrirá una nueva pestaña en tu navegador donde podrás crear y gestionar tus cuadernos de trabajo. Una de las características más valiosas de Jupyter Notebooks es su compatibilidad con diversas bibliotecas de ciencia de datos. Algunas de las más utilizadas incluyen: 1. Pandas: Esencial para la manipulación y análisis de datos. Pandas permite trabajar con datos en formato tabular, facilitando la limpieza, transformación y análisis de grandes conjuntos de datos.

2. NumPy: Fundamental para realizar operaciones numéricas y manejar datos multidimensionales. NumPy ofrece una variedad de funciones matemáticas y estructuras de datos optimizadas. 3. Matplotlib y Seaborn: Estas bibliotecas son utilizadas para la visualización de datos.

Te permiten crear gráficos y representaciones visuales atractivas y efectivas que facilitan la comprensión de los resultados. 4. Scikit-learn: Esta biblioteca está diseñada para realizar tareas de machine learning. Proporciona herramientas para construir, entrenar y evaluar modelos de aprendizaje automático. Ahora que tienes instalada la herramienta y conoces las bibliotecas esenciales, es hora de sumergirte en el análisis de datos.

Los Notebooks de Jupyter son ideales para el análisis exploratorio de datos (EDA). Puedes cargar tus datos en un marco de datos de Pandas y utilizar funciones integradas para explorar, limpiar y manipular tus datos. Además, Matplotlib y Seaborn te permiten crear visualizaciones que iluminan patrones y tendencias ocultas en los datos. El proceso de EDA generalmente comienza con la carga de los datos. Puedes hacerlo utilizando la función `pd.

read_csv()` de Pandas para leer archivos CSV, por ejemplo. Una vez que tus datos están en un DataFrame, puedes utilizar funciones como `.head()`, `.info()` y `.describe()` para obtener una visión general de los datos.

Esto te dará una idea de su estructura, tipos de datos y estadísticas básicas. A medida que exploras tus datos, seguramente te encontraras con valores nulos, duplicados o formatos inconsistentes. Jupyter facilita la detección y corrección de estos problemas. Puedes aplicar transformaciones a los datos en tiempo real, permitiéndote ver los resultados inmediatamente. Esta interactividad es uno de los principales atractivos de Jupyter Notebooks.

Una vez que hayas preparado tus datos, puedes comenzar con el modelado. Jupyter Notebooks soporta tareas de machine learning de manera fluida. Puedes importar Scikit-learn y utilizarlo para dividir tus datos en conjuntos de entrenamiento y prueba, construir modelos, ajustar hiperparámetros y evaluar el rendimiento. La capacidad de ver los resultados de tus experimentos en tiempo real crea un flujo de trabajo ágil que muchos científicos de datos valoran. Adicionalmente, los Jupyter Notebooks permiten documentar tu trabajo de forma efectiva.

La combinación de código y texto en Markdown en un solo documento hace que sea fácil explicar tu flujo de trabajo, compartir resultados y elaborar informes. Puedes insertar ecuaciones matemáticas utilizando LaTeX, lo que facilita la representación precisa de fórmulas y modelos. Una característica avanzada de Jupyter es la posibilidad de utilizar comandos mágicos. Estos son comandos especiales que permiten mejorar la funcionalidad de los Notebooks. Por ejemplo, puedes usar el comando `%matplotlib inline` para mostrar gráficos directamente en tu Notebook, facilitando la visualización sin necesidad de abrir ventanas externas.

Asimismo, el comando `%timeit` te permite medir la duración del tiempo de ejecución de una determinada celda de código, lo que es valioso para la optimización. Otro aspecto a considerar es la colaboración. Los Notebooks pueden guardarse en plataformas como GitHub, lo que permite compartir fácilmente tu trabajo con otros. Además, existen extensiones y herramientas que facilitan la gestión de versiones de tus Notebooks, ayudándote a rastrear cambios y mantener un control de la evolución de tus proyectos. Sin embargo, hay que tener en cuenta algunas limitaciones de Jupyter.

A pesar de que los Notebooks son excelentes para prototipos y experimentos, pueden volverse engorrosos para proyectos más grandes y estructurados. A medida que tu código crece, puede resultar difícil navegar a través de celdas desorganizadas. En esos casos, puede ser útil considerar un enfoque híbrido, donde desarrollas scripts de Python independientes para tareas más pesadas y utilizas Notebooks para la visualización y presentación de los resultados. Finalmente, es crucial mencionar la reproducibilidad de los análisis. Jupyter Notebooks capturan el código, los resultados y la documentación en un solo archivo, lo que facilita la reproducción de resultados.

Esta característica es de suma importancia en la ciencia de datos, donde la capacidad de replicar hallazgos es fundamental. En conclusión, Jupyter Notebooks son una herramienta poderosa y flexible para los científicos de datos. Su capacidad para combinar análisis, visualización y documentación en un entorno interactivo lo hace indispensable. Desde la instalación hasta la aplicación en proyectos de machine learning, esta guía te ofrece una comprensión integral para aprovechar al máximo Jupyter. Si aún no has comenzado a explorar este recurso, ahora es el momento perfecto para sumergirte en el fascinante mundo de la ciencia de datos con Jupyter Notebooks.

Imagina las posibilidades que se abrirán ante ti mientras exploras datos, construyes modelos y compartes tus descubrimientos de manera efectiva.