Estamos en una era donde la inteligencia artificial (IA) se ha convertido en una tecnología transversal que impacta numerosos sectores, especialmente el desarrollo de software. Los agentes de IA, sistemas que pueden tomar decisiones y ejecutar tareas de manera autónoma, revolucionan la forma en que programamos, diseñamos y mantenemos aplicaciones. Sin embargo, su administración efectiva presenta retos que a menudo parecen desafíos imposibles de superar. La velocidad con la que evolucionan estas herramientas supera la capacidad humana para adaptarse rápidamente, generando una sensación constante de estar a la zaga ante una tecnología en vertiginoso avance. El control y la gestión de agentes de IA requieren un enfoque meticuloso que combina planificación estratégica, conocimiento profundo de las herramientas y una comunicación clara con los sistemas.

La clave está en establecer límites y contextos precisos dentro de los cuales los agentes deben operar, evitando que tomen decisiones arbitrarias o generen código erróneo. Los errores son inevitables, tanto para humanos como para máquinas, pero aprender de ellos es fundamental para mejorar la precisión y la eficiencia de los agentes. La selección adecuada de herramientas para trabajar con agentes de IA es crucial. No se trata solo de elegir las plataformas más populares o con las funciones más recientes, sino de comprender que los materiales con los que se alimentan estos agentes, como el código, los diagramas o los prompts, son los verdaderos pilares sobre los cuales se edifica el resultado. Así, la calidad y coherencia de estos insumos determinarán el éxito del trabajo final.

Por ello, la familiarización y actualización constante en las características y novedades de las herramientas utilizadas son imprescindibles. Además, es vital evaluar las propias capacidades al interactuar con los agentes de IA. Los programadores deben poseer no solo habilidades técnicas, sino también una visión arquitectónica clara y la capacidad de expresar ideas complejas en un lenguaje accesible para la IA. El poder de estos agentes está en gran medida limitado por la calidad de las instrucciones y la precisión de los contextos que se les provea. Uno de los errores comunes en el uso de agentes de IA es la denominada 'vibe coding', o codificación basada en impresiones momentáneas y sin planificación.

Aunque puede ofrecer resultados visualmente atractivos en prototipos, este método no es sostenible para soluciones finales y operativas. Es esencial implementar planes reutilizables que puedan ser revisados y mejorados en varias iteraciones, facilitando así la corrección de errores y la extensión de funcionalidades. Dividir el trabajo en etapas pequeñas y manejables es una estrategia que aumenta la probabilidad de éxito. Los agentes de IA tienden a desbalancearse y desviarse si la tarea es demasiado compleja o si el plan inicial carece de detalles suficientes. Por lo tanto, es recomendable diseñar rutas claras y ajustadas para que el agente siga, lo que ayuda a evitar inventos inadecuados que pueden comprometer la integridad del software.

Para avanzar eficazmente, es imprescindible mantener una comunicación fluida y detallada con los agentes, utilizando ejemplos concretos y referencias específicas del código existente. Esto incluye el uso de documentos de planificación y reglas, que funcionan como guías permanentes que se almacenan en el repositorio del proyecto y se actualizan constantemente. Estos documentos, elaborados en formatos legibles tanto para humanos como para máquinas, permiten que el agente entienda y siga instrucciones con mayor precisión, transformando el desarrollo en un proceso colaborativo y ordenado. Sin embargo, hay que aceptar que los planes raramente son perfectos desde el inicio. Revisarlos y ajustarlos es parte inherente del proceso.

La paciencia y la capacidad de identificar errores conceptuales en los planes permiten afinar la ejecución y acercarse cada vez más al resultado deseado. Esta iteración continua es un reflejo del desarrollo humano, por lo que es importante no perder la perspectiva ni frustrarse ante fallos iniciales. Las pruebas rigurosas del código generado son indispensables. Confiar ciegamente en que el agente ejecuta correctamente cada instrucción puede llevar a resultados desastrosos. Mejor es validar manualmente, mediante sesiones de testing y observación de comportamientos en entornos controlados, asegurando que el producto final cumple con los requisitos y estándares de calidad establecidos.

Además, la inteligencia artificial no posee una comprensión verdadera del código ni del propósito detrás de cada línea. Su fortaleza radica en la predicción basada en patrones observados en grandes bases de datos de código, lo que puede llevar a soluciones genéricas o inadecuadas para casos específicos. Por eso, el aporte humano es insustituible en la definición del contexto y en la supervisión crítica del trabajo realizado. Otro aspecto crucial es la identificación y resolución temprana de problemas mayores en la arquitectura de software que pueden dificultar la labor de los agentes. Los agentes tienen la capacidad de señalar inconsistencias o áreas que requieren refactorización, lo que no solo mejora el código actual sino que también optimiza futuras interacciones con la IA.

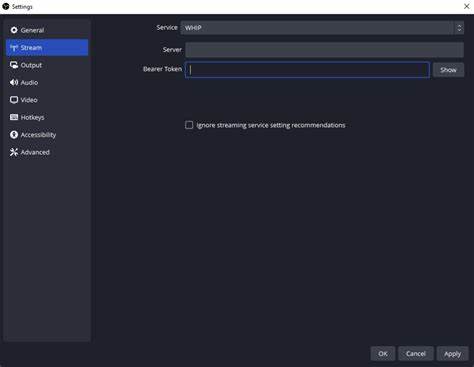

La creación de reglas y estándares claros para los agentes evita la repetición de errores y mejora la coherencia en el desarrollo. Mantener archivos de reglas que se incorporan automáticamente o manualmente a los prompts permite manejar las especificaciones del proyecto de manera sistemática, adaptándose a diferentes situaciones y requerimientos. Es importante considerar el costo asociado con el uso de agentes de IA, ya que muchas de estas plataformas operan bajo modelos de suscripción o pago por uso. Controlar el gasto implica establecer límites, elegir modelos adecuados para cada tarea y evaluar constantemente el retorno de inversión en términos de calidad y eficiencia del código generado. Dentro de la gestión técnica, la selección cuidadosa del modelo de IA a utilizar para cada fase del desarrollo es fundamental.

Algunos modelos están diseñados para acciones directas y rápidas, ideales para ejecutar instrucciones concretas, mientras que otros ofrecen mayor capacidad de razonamiento y planificación a un costo mayor. Saber cuándo y cómo utilizar cada uno es una habilidad que potenciará enormemente el aprovechamiento de los agentes. En este contexto, surge el Model Context Protocol (MCP), una metodología que permite la comunicación fluida y estructurada entre diferentes agentes y herramientas de IA. A pesar de su complejidad aparente, MCP representa una formalización de prácticas ya existentes, donde los prompts y llamadas a herramientas se pasan de manera organizada, facilitando la integración y cooperación de múltiples sistemas inteligentes. Aunque MCP no aporta mágicamente el control absoluto sobre agentes variados, ayuda a estandarizar las interacciones y a evitar problemas de incompatibilidad o pérdida de información en complejas cadenas de trabajo.