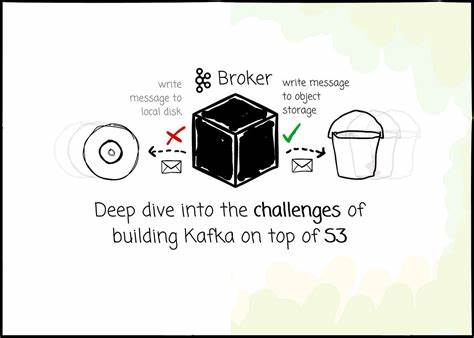

Kafka se ha consolidado como la plataforma líder para mensajería distribuida y procesamiento de flujos en tiempo real a nivel mundial. Esta solución, que inicialmente fue diseñada para funcionar en centros de datos locales, enfrenta numerosos retos cuando se intenta adaptar su arquitectura a entornos en la nube, especialmente sobre sistemas de almacenamiento orientados a objetos como Amazon S3. El desarrollo de Kafka sobre S3 representa un esfuerzo innovador para mejorar la escalabilidad, reducir costes y simplificar la operación, pero también implica resolver complejos problemas técnicos que afectan el rendimiento, la compatibilidad y la experiencia del usuario. Una de las principales motivaciones para trasladar Kafka a un almacenamiento basado en objetos es el ahorro significativo en costos. Tradicionalmente, Kafka utiliza un modelo en el que el cómputo y el almacenamiento están muy acoplados, lo que fuerza a las organizaciones a escalar ambos recursos simultáneamente aun cuando solo uno sea necesario.

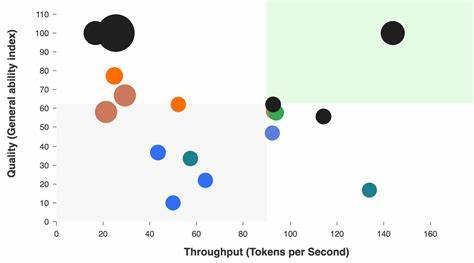

Al aprovechar la capacidad de escalamiento independiente de los servicios como S3, es posible optimizar recursos y gastos. Además, la replicación nativa y la durabilidad garantizada en S3 permiten eliminar la compleja capa de replicación entre nodos que caracteriza a Kafka, reduciendo la sobrecarga y las transferencias entre zonas de disponibilidad que implican grandes costos en la nube. Sin embargo, la latencia es uno de los desafíos más relevantes en este escenario. Las operaciones de lectura y escritura en almacenamiento basado en objetos presentan tiempos de acceso considerablemente más altos que un disco local SSD o incluso un sistema EBS. Por ejemplo, S3 puede presentar latencias en torno a decenas de milisegundos, a diferencia de los microsegundos en sistemas de almacenamiento tradicionales.

Esto puede afectar la percepción de rapidez en la escritura de mensajes y la confirmación al productor, impactando aplicaciones sensibles a la latencia. Para mitigar este problema, algunas implementaciones optan por sacrificar la latencia a cambio de una mayor eficiencia y ahorro, enviando las confirmaciones tras la persistencia definitiva en S3. Otras soluciones, como AutoMQ, adoptan un modelo híbrido que utiliza un registro de escritura adelantada (Write Ahead Log - WAL) alojado en soluciones de almacenamiento de baja latencia como EBS. De esta forma, se puede confirmar la recepción del mensaje en tiempos reducidos mientras que la escritura en S3 se realiza de manera asíncrona. Este enfoque permite mantener latencias cercanas a Kafka tradicional sin perder los beneficios económicos y de escalabilidad del almacenamiento de objetos.

Otro elemento a considerar es el impacto del costo asociado a la cantidad de operaciones realizadas sobre S3, en especial las solicitudes PUT que pueden ser onerosas en servicios de la nube. En un modelo donde cada mensaje es individualmente escrito a S3, los costos pueden escalar rápidamente, haciendo inviable la solución. La estrategia dominante para solucionar este problema implica la agrupación o batching de mensajes en lotes de tamaño adecuado para reducir la cantidad de solicitudes. Este mecanismo también puede afectar la latencia, generándose una tensión constante entre coste y rendimiento. En esta agrupación de datos es común la aparición de diferentes tipos de objetos: aquellos que contienen segmentos continuos de datos relacionados con un único tópico o partición, y otros que contienen datos mezclados de distintas particiones.

Esto puede provocar fragmentación de datos al distribuirse la información de una partición en múltiples objetos, lo que perjudica el rendimiento en la lectura y dificulta la recuperación secuencial de datos. Para minimizar esta desventaja, algunas plataformas desarrollan procesos en segundo plano de compactación que reorganizan la información y consolidan objetos relacionados con la misma partición en un solo archivo o conjunto reducido de objetos. Esta técnica mejora el patrón de acceso y reduce la cantidad de solicitudes de lectura, optimizando así la eficiencia. La gestión de caché es una pieza fundamental para superar las limitaciones de latencia y operaciones de I/O en S3. Una buena política y arquitectura de almacenamiento en caché permite acelerar el acceso tanto a datos recién escritos como a datos históricos.

Para lograr esto, es necesario configurar memorias temporales diferenciadas, algunas dedicadas a lecturas comunes y recientes, y otras a lecturas de datos más antiguos. Técnicas como la precarga, la lectura en lote y la ubicación inteligente de los datos ayudan a aumentar la tasa de aciertos en la caché, reduciendo la carga en el sistema de almacenamiento. Un reto adicional lo representa la gestión de metadatos. A diferencia del almacenamiento local donde la enumeración y organización de archivos se realiza con operaciones rápidas sobre el sistema de archivos, en S3 estas operaciones se traducen en solicitudes LIST poco eficientes y costosas. La agregación y mantenimiento de metadatos más elaborados es imprescindible para mantener coherencia y facilitar la búsqueda eficiente de segmentos de datos, referencias de mensajes y posicionamiento dentro de los flujos.

Para resolver este inconveniente, soluciones como AutoMQ emplean técnicas avanzadas basadas en metadatos estructurados que almacenan la relación entre segmentos y objetos mediante flujos paralelos de metadatos. Esto evita la necesidad de solicitar LIST constantes en S3 y mejora considerablemente la gestión y localización de los datos. La compatibilidad con Kafka es otro factor determinante en la implementación de sistemas que utilizan S3 como almacenamiento. Kafka tiene un ecosistema muy amplio y un protocolo bien establecido, y garantizar la interoperabilidad es clave para que los usuarios puedan migrar sin dificultades y aprovechar las características conocidas de Kafka. Dado que la arquitectura de Kafka está diseñada para acceder a datos en discos locales con operaciones tipo append y segmentación directa de archivos, implementarla íntegramente sobre S3 supone una transformación profunda.

Algunas alternativas optan por rediseñar su protocolo completamente para ajustarse mejor a las propiedades del almacenamiento de objetos. Otros, como AutoMQ, prefieren mantener la capa de aplicación y protocolo originales y solo modificar la capa de almacenamiento. Esta estrategia preserva la compatibilidad total con Kafka y facilita la incorporación de futuras actualizaciones. A nivel operativo, almacenar datos en S3 implica que los brokers tienen que asumir más responsabilidades al gestionar buffers, compaction y lectura en memoria, lo que puede incrementar la complejidad y la sobrecarga en comparación con Kafka tradicional que usa el sistema operativo para la gestión de almacenamiento local. Para controlar el uso de recursos, AutoMQ introduce limitadores de tasa asíncronos y esquemas de prioridad en el tráfico de red para evitar la competencia entre diferentes tipos de operaciones y asegurar la calidad de servicio.

Otro aspecto crítico es el manejo de la transferencia de datos entre zonas de disponibilidad (AZ) en la nube. Kafka original puede incurrir en costos elevados porque las escrituras y réplicas cruzan zonas con frecuencia. Al utilizar almacenamiento como S3 que maneja la durabilidad y réplica de forma automática, se elimina la necesidad de replicación entre nodos para asegurar la persistencia. Sin embargo, el problema persiste para la comunicación efectiva entre productores y brokers que pueden residir en distintas AZ. Para reducir los cargos por tráfico interzona, soluciones como AutoMQ implementan un sistema inteligente que redirige a los productores hacia brokers ubicados en la misma AZ cuando sea posible.