Python se ha consolidado como uno de los lenguajes de programación más usados y apreciados en la industria tecnológica, especialmente en el desarrollo de aplicaciones de inteligencia artificial, análisis de datos, automatización y desarrollo web. Sin embargo, a pesar de su popularidad, muchos desarrolladores se enfrentan a retos comunes cuando se trata de llevar un proyecto Python desde una etapa experimental hasta un producto profesional, escalable y fácil de mantener. La clave para alcanzar este nivel profesional radica en la correcta estructuración del proyecto y la adopción de herramientas modernas que optimicen tanto el desarrollo como el despliegue. La estructura de un proyecto Python debe ser sólida y modular para facilitar el mantenimiento y la escalabilidad. Una práctica recomendada es organizar el código en un repositorio monolítico modular, donde los componentes principales del proyecto, tales como el backend y el frontend, convivan en un mismo lugar pero de forma separada en carpetas claras y funcionales.

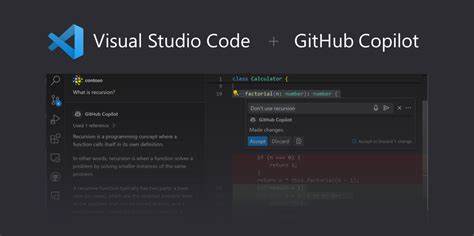

Por ejemplo, tener carpetas dedicadas como "philoagents-api" para la lógica del servidor y "philoagents-ui" para la interfaz de usuario permite que ambos módulos puedan ser gestionados y desarrollados independientemente, manteniendo la coherencia y facilitando la colaboración en equipos de diferentes tamaños. Dentro del backend Python, es esencial organizar los módulos en un paquete estándar dentro de una carpeta, comúnmente llamada "src" seguida del nombre del proyecto, para que el código pueda ser importado profesionalmente con sintaxis clara, eliminando ambigüedades. Esta estructura profesional hace que el trabajo con múltiples módulos sea intuitivo, permite usar las características avanzadas de Python para la gestión de paquetes y se alinea con las mejores prácticas de la comunidad. Además de la estructuración física de carpetas y archivos, el rol de las herramientas de desarrollo es crucial para acelerar el tiempo de desarrollo y mantener la calidad del código. En 2025, un avance significativo ha sido la adopción de "uv", una herramienta escrita en Rust que funciona como un gestor de proyectos y dependencias en Python.

Su principal ventaja es su velocidad notablemente superior frente a herramientas tradicionales como pip o Poetry, que suelen ser más lentas. Gracias a esta herramienta, instalar y sincronizar las dependencias de un proyecto se vuelve una tarea mucho más eficiente, optimizando significativamente el flujo de trabajo. Mantener el código limpio, legible y uniforme es fundamental en proyectos colaborativos y de largo plazo. Para lograrlo, "ruff" ha emergido como una solución integral que combina linter y formateador en una sola herramienta, también escrita en Rust. Ruff no solo sigue estrictamente las normas PEP8 para mantener la coherencia del estilo de código, sino que unifica lo que antes requería múltiples herramientas separadas, como Flake8, Black e isort.

Esto establece reglas claras y automáticas para el formato y estilo del código, evitando discusiones sobre preferencias personales y optimizando el proceso de revisión. Para automatizar tareas repetitivas como ejecutar pruebas, construir imágenes Docker o levantar el entorno completo del proyecto, la herramienta clásica Make sigue siendo altamente útil. Mediante la definición de comandos específicos en un Makefile, se facilitan atajos para ejecutar complejas cadenas de comandos con instrucciones sencillas. Esta práctica aporta orden y eficiencia, haciendo que el equipo de desarrollo trabaje más coordinadamente sin tener que memorizar comandos largos y específicos. El manejo seguro y flexible de configuraciones es otro componente vital en proyectos Python modernos.

Aquí, "Pydantic Settings" brinda una solución elegante para definir y validar configuraciones de la aplicación, tales como claves de API, parámetros de modelos o conexiones a bases de datos. Al permitir la carga automática desde variables de entorno o archivos .env y chequear tipos estrictos, ayuda a prevenir errores comunes de configuración y centraliza parámetros sensibles de forma práctica y segura. No se puede hablar de desarrollo profesional sin abarcar el despliegue y la infraestructura. Docker ha revolucionado la forma de construir, probar y distribuir aplicaciones, aislando el entorno completo de ejecución y sus dependencias dentro de contenedores livianos.

Esta cifra elimina la clásica problemática de “funciona en mi máquina” porque encapsula desde el sistema operativo hasta las librerías y la aplicación en una imagen reproducible. En proyectos con frontend, backend y bases de datos, la containerización permite que cada componente funcione de manera independiente pero orquestada, replicando en local el comportamiento que tendrá en producción. El uso de Docker Compose para conectar los distintos contenedores del sistema simplifica aún más la puesta en marcha del entorno completo con un solo comando. Esto es fundamental para facilitar el desarrollo local y la integración continua, promoviendo consistencia y predictibilidad. Además, organizar el Dockerfile con buenas prácticas, como copiar primero los archivos de dependencias para aprovechar la cache de Docker y solo luego copiar el código fuente, optimiza los tiempos de build, haciendo que el ciclo de desarrollo sea ágil y menos propenso a errores.

Más allá del desarrollo local, la posibilidad de desplegar imágenes Docker en la nube permite una transición fluida hacia producción. Plataformas gestionadas como AWS EKS, ECS, Beanstalk o equivalentes en otras nubes ofrecen entornos escalables, seguros y con alto uptime para ejecutar aplicaciones containerizadas. La combinación de Docker con Kubernetes facilita la orquestación avanzada, permitiendo que las aplicaciones escalen automáticamente ante cambios en la demanda. En cuanto a bases de datos y servicios de backend, optar por soluciones gestionadas en la nube, como MongoDB Atlas para bases de datos documentales, ayuda a reducir la complejidad relativa al manejo de infraestructura y operaciones críticas, permitiendo que el equipo se centre en el desarrollo de funcionalidades de alto valor. Finalmente, un aspecto fundamental para proyectos con componentes de inteligencia artificial y modelos de lenguaje consiste en entender cómo se integran los diferentes módulos tecnológicos, desde los agentes conversacionales hasta los pipelines de recuperación y evaluación (RAG).

![China Installs Nation's Largest Pumped Storage Rotor [video]](/images/6A06FEEC-BFF1-463F-A41F-DB644C77AE72)