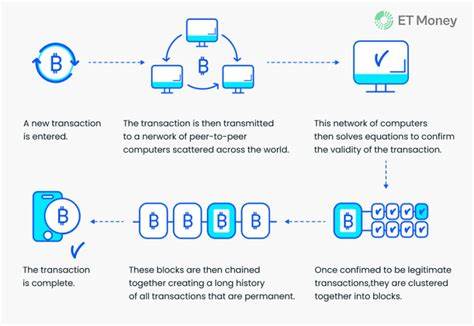

En la era actual, donde la inteligencia artificial (IA) avanza a pasos agigantados y se integra en distintas facetas del mundo tecnológico y empresarial, garantizar la seguridad y validez de las acciones que estos sistemas emprenden es más crucial que nunca. Los agentes de IA, especialmente aquellos que utilizan grandes modelos de lenguaje (LLM, por sus siglas en inglés), generan planes complejos en tiempo real para alcanzar ciertos objetivos. Sin embargo, estas arquitecturas no están exentas de errores: pueden producir planes inválidos, incoherentes, no ejecutables o incluso peligrosos. Plan-linter surge como una respuesta innovadora a estos desafíos, proporcionando un sistema de pre-check robusto para validar y asegurar que las acciones proyectadas por los agentes sean seguras, coherentes y responsables antes de ser ejecutadas. La relevancia de Plan-linter se fundamenta en los problemas inherentes a la planificación autónoma de agentes basados en IA.

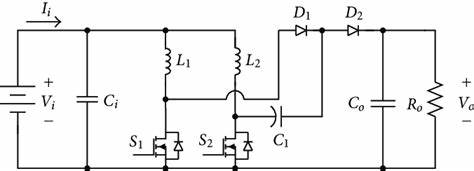

Estas inteligencias toman decisiones dinámicas, invocan diferentes herramientas y determinan cómo alcanzar metas sin intervención humana directa en cada paso. No obstante, la generación de planes no está exenta de errores debido a la naturaleza probabilística de los modelos y la posibilidad de alucinaciones o malinterpretaciones de los datos de entrada. Esto puede desembocar en la formulación de planes que incluyen operaciones potencialmente destructivas, como la eliminación masiva de datos, o que incumplen parámetros esenciales, afectando la integridad del sistema. Plan-linter actúa como un analizador estático especializado en planes emitidos por LLM. La herramienta toma un plan en formato JSON, comprueba su estructura contra esquemas definidos e inspecciona cada componente en busca de irregularidades o violaciones políticas establecidas mediante reglas específicas.

El resultado de este proceso es una evaluación clara que indica si el plan es seguro para su ejecución o si existen riesgos y errores críticos que deben atenderse previamente. Esta validación automatizada es indispensable para minimizar el riesgo de impactos negativos en entornos empresariales, tecnológicos o de investigación donde la AI opera de manera autónoma. La instalación y uso de Plan-linter son sencillos, lo que facilita su integración en diversos flujos de trabajo. Mediante pip, una herramienta estándar de Python, es posible instalar la aplicación rápidamente, y la ejecución desde la línea de comandos permite validar planes mediante un simple comando. Para proyectos más complejos, Plan-linter puede utilizar políticas personalizadas definidas en archivos YAML que especifican permisos, límites y restricciones a aplicar, enriqueciendo así el análisis con reglas adaptadas a escenarios particulares.

Un aspecto destacado de Plan-linter es su capacidad para detectar planes inseguros y no ejecutables. Por ejemplo, puede identificar cuando un plan intenta utilizar herramientas no autorizadas o realizar operaciones inválidas, y también restringe la inclusión de información confidencial como claves o tokens sensibles mediante patrones de negación. Gracias a esta función, organizaciones pueden proteger datos críticos y evitar que agentes autónomos expongan secretos o realicen acciones inapropiadas. El funcionamiento interno de Plan-linter se basa en la definición de reglas modulares programadas en Python, las cuales se encargan de inspeccionar cada paso dentro del plan. Cada regla puede evaluar distintos aspectos, desde la seguridad de las herramientas utilizadas hasta la coherencia lógica del conjunto de acciones.

Los desarrolladores tienen la libertad de añadir reglas personalizadas para cubrir necesidades específicas, incrementando la flexibilidad y adaptabilidad del sistema en distintas industrias o casos de uso. La importancia de contar con un sistema así es aún mayor cuando se considera el crecimiento vertiginoso de agentes basados en IA en áreas sensibles como finanzas, salud, manufactura o administración pública. En estos sectores, un error en el plan de un agente puede causar consecuencias graves, desde pérdidas económicas hasta daños en infraestructura o riesgos para la seguridad de personas. La instalación de un proceso de pre-validación mediante Plan-linter asegura que estos agentes solo ejecuten planes que han pasado rigurosos análisis de seguridad y conformidad. Además de las reglas básicas, Plan-linter incorpora integración con Open Policy Agent (OPA) y su lenguaje Rego, facilitando la creación de políticas complejas y centralizadas para entornos donde se requieren controles estrictos y auditables.

Esta característica avanzada permite a los administradores definir con precisión comportamientos permitidos, asegurando al máximo la gobernanza de agentes AI. El proyecto es de código abierto y cuenta con una comunidad en crecimiento que aporta mejoras constantes. La licencia Apache 2.0 garantiza que organizaciones y desarrolladores puedan usar, modificar e integrar Plan-linter sin restricciones comerciales, fomentando la adopción y contribución colaborativa. La documentación es amplia y accesible, incluyendo guías para la creación de reglas personalizadas, ejemplos reales y herramientas de desarrollo para facilitar el despliegue y adaptación a diferentes necesidades.

Uno de los beneficios más palparbles de usar Plan-linter es la posibilidad de prevenir impactos no deseados antes que ocurran. En lugar de detectar errores una vez que el agente ha actuado (lo que podría ser demasiado tarde), la herramienta ayuda a implementar controles proactivos. Esto deposita confianza en sistemas críticos y democratiza el uso responsable de la inteligencia artificial, especialmente cuando se manejan operaciones automatizadas con potencial legal, financiero o ético relevante. De cara al futuro, el equipo de desarrollo plantea incorporaciones que ampliarán la utilidad del linter. Entre los planes destacan la capacidad de autocompletar o corregir automáticamente errores simples detectados, la creación de extensiones para entornos de desarrollo como VS Code que permitan validación en tiempo real, y la integración en flujos de trabajo de CI/CD mediante acciones de GitHub para auditoría y control continuo en despliegues de inteligencia artificial.

Este enfoque integral de seguridad para agentes AI es esencial ya que el ecosistema de herramientas se torna cada vez más complejo con la entrada de nuevas metodologías como cadenas de pensamiento, razonamiento en árboles y agentes multi-herramienta. Contar con un analizador estático que interprete la lógica, las dependencias y los riesgos involucra un avance crucial dentro del paradigma de confianza en sistemas autónomos. Además, la posibilidad de incorporar reglas específicas para distintos contextos, como la prevención de operaciones SQL que intenten modificar información o evitar que se establezcan bucles infinitos, permite que Plan-linter se adapte con alta granularidad a los requerimientos particulares de cada aplicación o entidad. Esta personalización contribuye a maximizar la eficacia del análisis y minimiza las falsas alarmas o riesgos inadvertidos. Los usuarios interesados pueden iniciar utilizando Plan-linter en proyectos simples para evaluar planes JSON generados por sus agentes, e ir progresivamente implementando políticas sofisticadas conforme se familiarizan con el sistema.