En la era digital actual, la inteligencia artificial (IA) ha revolucionado la manera en que interactuamos con la tecnología y consumimos productos y servicios. Sin embargo, detrás del progreso y la innovación que ofrecen las herramientas basadas en IA, se esconde una dinámica compleja que afecta profundamente nuestra privacidad y la manera en que nuestra información personal se utiliza para influir en nuestros comportamientos de compra. Las compañías de IA están aprovechando cada palabra que escribimos, cada prompt que enviamos, para construir perfiles psicológicos detallados que se transforman en potentes detonantes comerciales. Este fenómeno, que podríamos denominar como “mente monetizada”, está cambiando las reglas del juego en la economía digital y abre un debate urgente sobre los límites éticos, legales y personales de la recopilación de datos y su explotación comercial. Las grandes empresas que dominan el ámbito de la inteligencia artificial, incluidas OpenAI, Google DeepMind y otras, registran y almacenan de manera sistemática los chats y las interacciones de sus usuarios.

Aunque en sus políticas de privacidad suelen justificar esta práctica bajo el pretexto de mejorar la experiencia del usuario o avanzar en la investigación técnica, la realidad es que esta información sirve para mucho más. Los datos recopilados —que pueden ir desde preferencias explícitas hasta matices emocionales ocultos— se utilizan para construir perfiles psicológicos detallados que permiten segmentar a los usuarios de manera extremadamente precisa. Estos perfiles psicológicos, también conocidos como perfiles psicográficos, transforman la información en una herramienta para maximizar la eficacia de las campañas publicitarias y, por ende, incrementar las ventas. El uso de estos perfiles psicográficos va más allá de las simples categorías demográficas habituales. No se trata solo de conocer la edad, el género o la localización de una persona, sino de entender profundamente sus motivaciones, miedos, deseos y comportamientos.

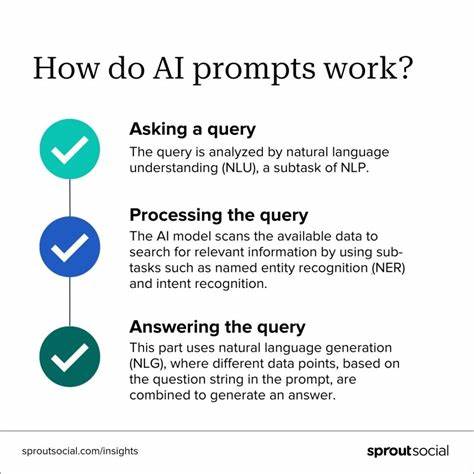

La inteligencia artificial, gracias al análisis masivo de datos, puede identificar patrones sutiles y predictivos que antes solo podían detectarse con entrevistas personalizadas y costosas. Ahora, este conocimiento se adquiere en tiempo real y a escala masiva, sin que el usuario sea del todo consciente de ello. Esta capacidad para mapear e influir en la mente humana supone un arma poderosa en manos de las empresas de publicidad y las plataformas tecnológicas. El resultado es una publicidad cada vez más personalizada y persuasiva, donde los mensajes y productos ofrecidos se ajustan con precisión a las necesidades psicológicas del consumidor, generando un nivel elevado de efectividad para desencadenar decisiones de compra. Cada prompt que envías a un asistente virtual puede alimentar este proceso y, en última instancia, ser utilizado para diseñar estrategias comerciales que explotan tus preferencias y vulnerabilidades.

El problema central reside en que, mientras estas prácticas prosperan, los marcos regulatorios y las leyes de protección de datos no han avanzado al mismo ritmo. Incluso regiones con regulaciones estrictas, como la Unión Europea con su Reglamento General de Protección de Datos (GDPR), muestran dificultades para imponer límites claros y exigentes a la explotación de datos psicográficos. Muchas empresas se aprovechan de lagunas legales, interpretaciones ambiguas o jurisdicciones desfavorables para almacenar, analizar y comercializar datos, a menudo bajo acuerdos implícitos y procesos poco transparentes que el usuario acepta sin plena conciencia. Los riesgos que esta situación implica son múltiples y no solo afectan la privacidad individual. La exposición constante y masiva de datos puede derivar en filtraciones de información sensible, como ha ocurrido con plataformas como Muah.

ai, donde una brecha de seguridad expuso datos de millones de usuarios, incluidos sus chats personales y datos de contacto. Este tipo de incidentes demuestran que la monetización de nuestros datos no solo tiene un impacto comercial sino también implica riesgos reales de seguridad y vulnerabilidad. Además, existe el peligro de que estas bases de datos sean aprovechadas por actores malintencionados, desde ciberdelincuentes que buscan explotar información para extorsionar, hasta gobiernos autoritarios que utilizan estas herramientas para campañas de desinformación o vigilancia masiva. La combinación de perfiles psicográficos detallados con datos de identificación puede constituir una amenaza para la democracia, la libertad individual y la soberanía nacional. Por otra parte, la manipulación psicológica a través de la publicidad personalizada puede generar un efecto adverso en la sociedad, condicionando comportamientos de consumo y decisiones personales en función de sesgos invisibles e intereses comerciales ocultos.

Cuando las empresas juegan con nuestra mente y emociones para provocar impulsos de compra, se plantea una cuestión ética fundamental sobre el respeto a la autonomía y el consentimiento informado. Google emerge como un actor dominante en este paradigma, reuniendo un vasto ecosistema de datos provenientes de sus múltiples servicios: búsquedas, vídeos, aplicaciones, dispositivos, y ahora sus herramientas de IA como Gemini. Esta integración le permite construir modelos de usuario extremadamente precisos, que luego se transforman en armas publicitarias con un alcance y precisión inéditos. La revisión humana y la participación de terceros que procesan las conversaciones de los usuarios para mejorar los modelos añade otra capa de complejidad a los desafíos de privacidad. Mientras tanto, otras empresas intentan ponerse al día o aprovechar este modelo antes de que nuevas regulaciones puedan poner un freno definitivo.

Sin embargo, la rapidez con que se lanzan nuevos productos y servicios hace muy difícil que la regulación tradicional pueda contener o adecuar adecuadamente las prácticas de estas compañías. En definitiva, la monetización de la mente humana a través de la explotación de prompts y datos conversacionales está abriendo una nueva era donde la información personal y psicológica se convierte en uno de los recursos más valiosos y vulnerables del mundo digital. Esta transformación exige una mayor conciencia pública sobre los riesgos y beneficios, así como un debate urgente sobre los límites éticos y legales que deben establecerse para proteger a los individuos. Los usuarios pueden tomar algunas medidas para proteger su privacidad, como revisar cuidadosamente las políticas de privacidad, optar por servicios que garantizan mayor control sobre sus datos o mantenerse informados sobre las opciones de gestión y eliminación de información que ofrecen las plataformas. Pero esta responsabilidad individual debe complementarse con un compromiso firme de los reguladores y gobiernos para establecer normativas claras, exigir transparencia y sancionar abusos.

El debate sobre la monetización de los datos generados por la inteligencia artificial es también una reflexión sobre la sociedad que queremos construir: una donde la tecnología sirva para empoderar a las personas, respetar su dignidad y autonomía, y no para manipular o explotar en función de intereses comerciales o políticos. Como consumidores y ciudadanos, está en nuestras manos demandar mayor responsabilidad y ética en el uso de la inteligencia artificial. Porque cuando la mente humana se convierte en moneda de cambio para las empresas, el verdadero desafío será equilibrar innovación tecnológica con derechos fundamentales y el respeto hacia la privacidad y la libertad individual.