Factorio es un juego de construcción y gestión industrial que ha cautivado a miles de jugadores y desarrolladores de inteligencia artificial por igual debido a su complejidad, dinamismo y naturaleza abierta. Con la evolución constante de los entornos de aprendizaje de inteligencia artificial, el Factorio Learning Environment (FLE) se ha consolidado como una plataforma esencial para evaluar y potenciar agentes inteligentes en escenarios desafiantes y colaborativos. La más reciente actualización, FLE v0.2.0, trae importantes avances relacionados con la coordinación multi-agente, modelos de razonamiento, reflexión y retroceso, así como la incorporación de agentes visuales para mejorar la percepción espacial y la toma de decisiones.

Estos desarrollos marcan un hito en la búsqueda de crear agentes que no solo superen a los humanos en diversas tareas, sino que lo hagan en entornos abiertos, no acotados y altamente dinámicos, donde la colaboración y la competencia entre agentes pueden explorarse a fondo. El núcleo de la actualización se basa en el soporte para escenarios multi-agente nativos dentro del entorno de Factorio. Esto se logra aprovechando las mecánicas multijugador del juego original, permitiendo que múltiples agentes interactúen, cooperen y compitan en un entorno compartido. La habilidad para comunicarse mediante mensajes broadcast o de par a par hace posible que los agentes compartan información, coordinando responsabilidades para lograr objetivos comunes de manera eficiente, incluso cuando tienen acceso limitado a la información completa del entorno. Este tipo de coordinación es crucial para simular situaciones realistas donde la cooperación y el manejo de conflictos deben ser balanceados adecuadamente para evitar errores críticos y optimizar la productividad del sistema.

Una característica esencial del FLE v0.2.0 es que los agentes priorizan la ceder el paso mutuo durante la planificación y la ejecución de acciones, reduciendo así conflictos y problemas de coordinación que podrían surgir al intentar actuar simultáneamente sin un control adecuado. Aun así, la falta de verdadera concurrencia presenta nuevos desafíos, ya que los agentes pueden tener dificultades para anticipar cómo las acciones de otros afectarán la globalidad de la fábrica, generando errores novedosos difíciles de corregir al instante. No obstante, este compromiso en el diseño ha abierto un terreno fértil para investigaciones tanto en capacidades avanzadas de automatización como en seguridad y confiabilidad de sistemas multi-agente inteligentes.

Además de la cooperación multi-agente, FLE v0.2.0 incorpora el uso de modelos de razonamiento integrados mediante el Protocolo de Control Modular (MCP). Esta integración permite a los agentes efectuar planeamientos profundos apoyados en una cadena de razonamientos y invocación de herramientas durante la ejecución de tareas complejas. Con esta arquitectura, los usuarios pueden monitorear y controlar integralmente las trayectorias de los agentes desde la terminal, interviniendo manualmente para ayudar en puntos problemáticos, o activar un modo de investigación para fomentar planes aún más detallados.

Este enfoque híbrido combina la autonomía de la IA con la supervisión humana, mejorando la eficacia en el diseño y optimización de fábricas automatizadas de forma robusta y flexible. Los problemas comunes en entornos de automatización, como la ejecución incompleta o errónea de programas que desembocan en estados rotos o semicompletos de la fábrica, también han sido abordados con innovaciones de reflexión y retroceso (backtracking). Durante anteriores versiones, cuando un agente ejecutaba una acción defectuosa que generaba un estado inconsistente, este podía quedar atrapado en intentos recurrentes y poco fructíferos de corrección, desviándose de los objetivos primarios durante largos periodos. Para resolver esto, el nuevo sistema evalúa los mensajes de error y el historial de ejecuciones para iterativamente mejorar los programas, revirtiendo al estado previo a la falla antes de intentar una ejecución nuevamente. Este mecanismo mantiene la fábrica en condiciones limpias y estables, lo que mejora la fiabilidad y permite a los agentes concentrarse en lograr metas críticas sin perder tiempo ni recursos en corregir fallas acumuladas.

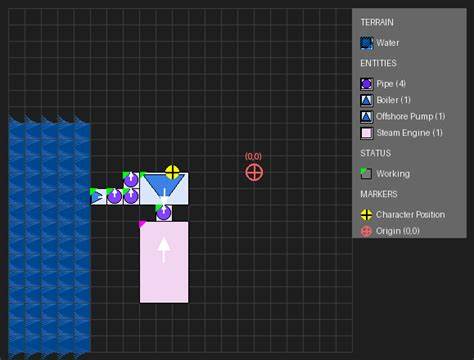

Los resultados preliminares de laboratorio indican que esta técnica de retroceso, combinada con mecanismos de reflexión, ha logrado incrementar hasta en un seis por ciento el rendimiento de agentes como Claude Sonnet 3.5. Este aumento se debe tanto a una mayor consistencia en la resolución de tareas de bajo nivel como a la capacidad recién adquirida para acometer con éxito desafíos antes no solucionables, tales como la construcción automatizada de fábricas para circuitos electrónicos o ciencia automática. Este avance demuestra cómo la capacidad de autoevaluación y corrección es fundamental para la escalabilidad y robustez de agentes inteligentes en entornos complejos. Otra innovación importante de esta actualización son los agentes visuales, diseñados para mejorar la percepción espacial y la toma de decisiones al proporcionar mapas simplificados anotados del entorno de juego.

Estas visualizaciones facilitan que los agentes razonen con mayor profundidad sobre la ubicación y disposición de elementos clave de la fábrica, especialmente en servidores sin interfaz gráfica, donde la conexión del cliente de Factorio no está activada. Aunque todavía los modelos visuales actuales no muestran una mejora significativa en resultados de benchmark, sientan las bases para futuras investigaciones que integren mejor información visual y conocimiento estratégico, abriendo posibilidades para optimizaciones sustanciales en el diseño y gestión industrial automatizada. En cuanto al desempeño general de agentes, destacan modelos como Claude 3.7 Sonnet, que alcanzaron un record de automatización del 29.1% en pruebas de laboratorio, con variantes con reflexión mostrando también resultados destacados.

Otros modelos como Gemini 2.5 Pro y GPT-4o presentaron desempeños sólidos aunque inferiores. Estos datos reflejan la competitividad y potencial de los modelos integrados con tecnologías avanzadas de razonamiento y coordinación para superar barreras tradicionales en agentes de automatización. Mirando hacia el futuro, el equipo de Factorio Learning Environment planea una expansión significativa de las posibilidades con integraciones Agent-to-Agent (A2A), permitiendo que diferentes modelos colaboren o compitan en línea, abriendo un espectro infinito de escenarios con combinaciones heterogéneas. Esto además propone desafíos técnicos y de seguridad estimulantes, ya que la gestión de interacciones entre agentes autónomos e independientes es un área de frontera en la investigación en inteligencia artificial.

Asimismo, se anticipa una ampliación en las modalidades multi-agente, con soporte para equipos especializados, entornos competitivos y colaboraciones mixtas con capacidades diversas, permitiendo un laboratorio natural para estudiar comportamientos emergentes y estrategias de coordinación complejas. Complementariamente, está en desarrollo una infraestructura para entrenamiento a gran escala con pipelines optimizados que incorporarán aprendizaje por refuerzo y retroalimentación humana, buscando entrenar agentes que maximicen objetivos complejos y divergentes, como el conocido problema de los maximizadores de Paperclip, en un entorno controlado y reproducible. El lanzamiento de FLE v0.2.0 representa un paso relevante en la evolución de entornos de evaluación para inteligencia artificial, enfatizando la importancia de la coordinación multi-agente, el razonamiento profundo y la capacidad de reflexión adaptativa.

![Organizational Sustainability with Platform Engineering [video]](/images/875E1975-0136-4AB8-B0E6-43B1B3296146)

![Solar Meshtastic BBS on low power dev board [video]](/images/9836F221-3EB5-4089-B8A6-3948A94B82D7)