El informe Jepsen se ha consolidado como una referencia fundamental para quienes trabajan con bases de datos distribuidas y sistemas que requieren una alta consistencia y fiabilidad. Más allá del atractivo técnico, proporciona un análisis riguroso sobre la manera en la que ciertos sistemas pueden presentar fallas inesperadas y sutiles en ambientes concurrentes. Para algunos, los conceptos del informe pueden resultar complejos debido a la naturaleza técnica y a los marcos teóricos alrededor de las transacciones, la serializabilidad y los niveles de aislamiento en bases de datos. Sin embargo, entender el núcleo del informe Jepsen es crucial para evaluar el comportamiento de los sistemas modernos y para tomar decisiones informadas sobre la elección o configuración de tecnologías de almacenamiento. Primero, es vital comprender qué es el informe Jepsen y cuál es su función en el ámbito tecnológico.

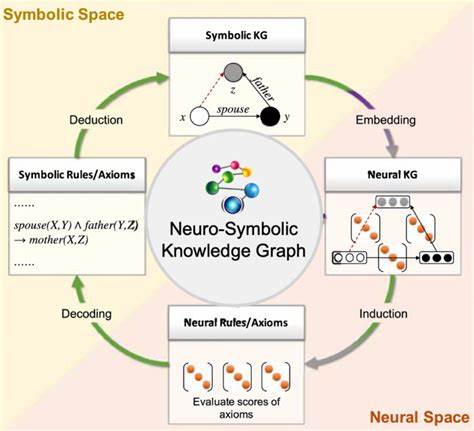

Jepsen es una serie de pruebas y análisis diseñados para evaluar y mostrar las anomalías que pueden ocurrir en sistemas distribuidos cuando se enfrentan a condiciones adversas, como particiones de red, fallas de nodos o condiciones de alta concurrencia. Estas pruebas revelan si un sistema cumple con las garantías de consistencia prometidas, principalmente aquellas relacionadas con cómo se gestionan las transacciones en la base de datos y cómo se sincronizan los datos entre nodos. Uno de los conceptos centrales en la discusión técnica de Jepsen es la serializabilidad. Este es el nivel más estricto de aislamiento de transacciones en bases de datos y se refiere a la capacidad de asegurar que el resultado de varias transacciones concurrentes es equivalente a un orden serial, es decir, que podrían haberse ejecutado en secuencia sin superponerse. Para entender esto, se utilizan grafos de dependencia que representan las relaciones entre transacciones, principalmente a través de dependencias tipo escritura-lectura, lectura-escritura y escritura-escritura.

Si este grafo es acíclico, se puede garantizar que la historia es serializable, lo que se traduce en un comportamiento consistente y predecible de los datos. Sin embargo, los sistemas modernos a menudo implementan niveles de aislamiento menos estrictos para mejorar el rendimiento y la escalabilidad, siendo uno de los más comunes la Snapshot Isolation (SI). Bajo este nivel, cada transacción opera sobre una "instantánea" consistente de la base de datos en un momento determinado. Esto permite que dos transacciones concurrentes lean datos sin bloquearse mutuamente, mejorando así la concurrencia, pero introduce riesgos de anomalías conocidas como "write skew" o desviaciones de escritura. Estas anomalías ocurren cuando dos transacciones leen y actualizan datos basándose en una instantánea que podría estar desfasada respecto a la verdadera secuencia de actualizaciones, lo que lleva a resultados inconsistentes que no serían posibles bajo serializabilidad estricta.

El informe Jepsen explora las complejidades que surgen de estas condiciones, especialmente aquellas relacionadas con las estructuras denominadas "G-nonadjacent" o ciclos no adyacentes de anti-dependencias en los grafos de dependencia. Estos ciclos representan situaciones donde existen relaciones en las que una transacción no observa el efecto de otra, creando un ciclo en el grafo de dependencias que viola la serializabilidad y, en consecuencia, la integridad de los datos bajo ciertos niveles de aislamiento. La importancia de estos ciclos radica en que permiten identificar violaciones de la Snapshot Isolation y ayudan a los ingenieros a comprender cuándo y cómo surgen estas anomalías en el funcionamiento real del sistema. Para ilustrar, considere un conjunto de transacciones donde T1 realiza una operación de escritura en un registro y T2 lo lee, indicando una dependencia escritura-lectura (wr) de T1 a T2. Simultáneamente, si T2 no observa la escritura realizada por otra transacción T3 en un registro distinto, se establece una dependencia lectura-escritura (rw) de T2 a T3.

Al estudiarse varias de estas relaciones, pueden formarse ciclos en el grafo de dependencia, que bajo un análisis tradicional indicaría una falta de serializabilidad. Lo particular es que bajo Snapshot Isolation, ciertos ciclos son permitidos siempre que cumplan condiciones específicas, como tener dos aristas consecutivas de anti-dependencia (rw). En cambio, la presencia de ciclos sin estas características —identificados en Jepsen como G-nonadjacent— señala violaciones a este nivel de aislamiento. Entender estos patrones no es solo un ejercicio académico. Son fundamentales para diseñar y evaluar sistemas distribuidos en la práctica, donde la concurrencia y las particiones de red son inevitables.

Sistemas como PostgreSQL han adoptado técnicas para "injertar" serializabilidad sobre Snapshot Isolation, negando estructuras de dependencia que provoquen ciclos peligrosos y mejorando así la consistencia sin sacrificar demasiado el rendimiento. Este tipo de innovaciones se basan directamente en el conocimiento ganado a partir de análisis como los del informe Jepsen. Además, el enfoque de Jepsen en utilizar definiciones ligeramente más amplias para Snapshot Isolation que otras definiciones más estrictas permite que sus pruebas tengan un alcance más amplio. Esto significa que una anomalía detectada es significativa para un espectro más grande de sistemas, aumentando la relevancia y la aplicabilidad de sus hallazgos. Es importante resaltar que Jepsen no busca garantizar que un sistema sea correcto, sino demostrar bajo qué condiciones puede fallar, aportando a la transparencia y a la mejora continua de los sistemas distribuidos.

Otro aspecto esencial que emerge del análisis Jepsen es la visualización y adopción de una perspectiva basada en grafos para entender la interdependencia entre transacciones. Representar las interacciones a través de estas gráficas permite a los desarrolladores y arquitectos identificar de qué forma se pueden producir anomalías y diseñar mecanismos para evitarlas o mitigar sus efectos. Entender el significado y la trayectoria de los diferentes tipos de dependencias dentro de estas estructuras es clave para la implementación de protocolos de concurrencia robustos. En conclusión, comprender el informe Jepsen requiere sumergirse en conceptos fundamentales de bases de datos, tales como la serializabilidad, los niveles de aislamiento, Snapshot Isolation y el análisis de grafos de dependencias entre transacciones. Esta comprensión es indispensable para cualquiera que busque diseñar, mantener o evaluar sistemas distribuidos contemporáneos, especialmente aquellos que deben equilibrar la necesidad de alta concurrencia, rendimiento y consistencia de datos.

A medida que las arquitecturas de software evolucionan y se distribuyen efectivamente en múltiples zonas o regiones, la relevancia de estudios y metodologías como los adoptados por Jepsen solo crecerá, sirviendo como base para construir sistemas más confiables y transparentes en entornos cada vez más complejos.