En el dinámico y complejo mundo del desarrollo de software, asegurar que el código funcione correctamente no solo es una necesidad, sino una prioridad fundamental. Tradicionalmente, las pruebas de software han sido un proceso que combina análisis manuales, revisiones de código y herramientas automatizadas. Sin embargo, con la llegada de los Modelos de Lenguaje Extensos (LLMs), muchos desarrolladores han puesto sus esperanzas en que estas inteligencias artificiales puedan simplificar considerablemente la detección de errores, incluso llevándolos a delegar por completo la tarea. Aunque la capacidad de estas herramientas para generar, explicar y corregir fragmentos de código es innegable, surge una cuestión crítica que pocas veces se discute: para llevar a cabo pruebas de calidad, es indispensable ejecutar el código y no limitarse a un análisis estático o teórico. La noción de que "probar código significa ejecutarlo" resume un principio básico pero frecuentemente olvidado en el desarrollo de software.

Las líneas de código, por muy limpias o bien escritas que estén, ocultan un mundo de interacciones complejas que solo se manifiestan durante la ejecución real. Estas interacciones involucran no solo la lógica interna del programa, sino también sus relaciones con el sistema operativo, bibliotecas externas, bases de datos y servicios de red. Son estos factores los que pueden convertir un código aparentemente correcto en una aplicación que falla en condiciones específicas o que presenta fallos intermitentes difíciles de diagnosticar sin observación en tiempo real. El auge de los LLMs ha provocado una fascinación generalizada por la idea de que simplemente observando el código fuente, estas herramientas pueden identificar y corregir cada falla. Sin embargo, esta suposición peca de simplista y no se sostiene ante las complejidades reales del desarrollo.

Cuando un LLM examina fragmentos de código, lo hace sin la capacidad inherente de ejecutar el programa y experimentar su comportamiento ante distintas situaciones. Por ejemplo, en estructuras como los bloques try-catch para manejo de excepciones, el modelo a menudo interpreta que es un error no especificar explícitamente cada posible excepción, y automáticamente genera múltiples capturas individuales que aunque técnicamente correctas, pueden no ajustarse a la filosofía práctica del proyecto ni mejorar realmente la robustez en tiempo de ejecución. Este fenómeno refleja una limitación fundamental: sin la posibilidad de correr el código y recibir feedback concreto del sistema, el análisis sigue siendo estático, y cualquier cambio realizado es una conjetura basada en patrones aprendidos, no en evidencia real. Además, la ejecución de código expone problemas que solo se manifiestan en tiempo de ejecución, como fallos en la gestión de memoria, condiciones de carrera, errores en la comunicación con sistemas externos o comportamientos inesperados debidos a estados mutables del programa. Identificar estos errores requiere un ambiente controlado que reproduzca y monitorice la ejecución, una práctica que los humanos llevan haciendo desde los albores del software pero que todavía escapa a la mayoría de las implementaciones de inteligencia artificial actuales.

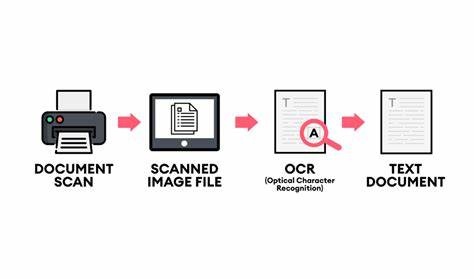

La experiencia del desarrollador al enfrentar un error es una danza continua entre la escritura de código, el fallo inesperado y la investigación detallada del problema. Para resolver una falla compleja no basta con leer el código; es indispensable observar cómo varían las variables en tiempo real, qué rutas toman los procesos, y cómo interactúa el programa con su entorno. Este proceso implica debugueo dinámico, impresión de estados intermedios, monitoreo de logs y repetidas ejecuciones bajo condiciones variadas. Es en esta interacción vivida con el sistema donde se producen los descubrimientos que finalmente conducen a la solución. La innovación llega cuando se considera la combinación de la inteligencia artificial con entornos de ejecución que ofrecen precisamente esta capacidad: proporcionar un espacio seguro y controlado donde el código puede ser ejecutado, probado y observado, e incluso modificado automáticamente para mejorar su estabilidad.

En este sentido, Jazzberry representa un avance significativo al implementar sistemas que permitan a las LLMs no solo leer y analizar el código, sino también ejecutarlo en microVMs aisladas y replicar diversas condiciones de uso. Esta habilidad permite que la inteligencia artificial genere test, corrija errores reales que solo emergen en ejecución y aprenda de los resultados, mejorando la precisión y relevancia de sus intervenciones. Al integrar una sandbox segura para la ejecución, se supera la limitación de los análisis estáticos y se aborda la necesidad de una verificación empírica en tiempo real. Esto significa que la IA puede detectar fallos estructurales profundos, inconsistencias en la gestión de excepciones, problemas de concurrencia y dependencia, así como errores debidos a la interacción con recursos externos. Más aún, al ser capaz de correr pruebas automáticas y validar los resultados, el sistema puede identificar fallos que incluso a los desarrolladores experimentados se les escapan debido a la complejidad y volumen del código.

Así pues, el futuro de las pruebas de software asistidas por IA no está en pedirle a un LLM que solo lea o modifique el código, sino en dotarlo de la facultad de «vivir» dentro del ecosistema del software, ejecutar operaciones, manipular dependencias, simular situaciones y extraer conclusiones con base en resultados tangibles. Este cambio de paradigma permite trascender la ilusión de un análisis perfecto pero superficial, hacia una verdadera inteligencia que colabora como un desarrollador activo y experimental. Es importante reconocer que, aunque la ejecución del código en entornos controlados añade seguridad y posibilidades, aún se requieren cuidados para mantener la integridad y la seguridad de los proyectos. La administración de recursos, la protección ante código malicioso y la gestión adecuada de datos sensibles son consideraciones indispensables que cualquier plataforma que integre estos procesos debe abordar cuidadosamente. En conclusión, la premisa "probar código significa ejecutarlo" resalta la esencia del proceso de calidad en el software.

La incorporación de LLMs en el ciclo de desarrollo es un avance prometedor, pero sólo cuando estos modelos pueden interactuar dinámicamente con el código en ejecución podemos esperar una verdadera revolución en la detección y corrección de errores. La visión de herramientas como Jazzberry, que permiten a las inteligencias artificiales ejecutar, observar y aprender en entornos seguros, representa un camino sólido hacia un futuro donde el desarrollo de software no solo sea más rápido y eficiente, sino también más confiable y robusto. En un mundo cada vez más dependiente de sistemas digitales estables y complejos, invertir en metodologías que integren la prueba dinámica junto con la inteligencia artificial es un paso imprescindible para garantizar aplicaciones de alta calidad. La evolución de las herramientas y procesos en este ámbito resulta fundamental para que la tecnología sea una verdadera aliada del desarrollo, minimizando fallos, mejorando la experiencia de usuario y optimizando recursos en la creación de soluciones innovadoras.