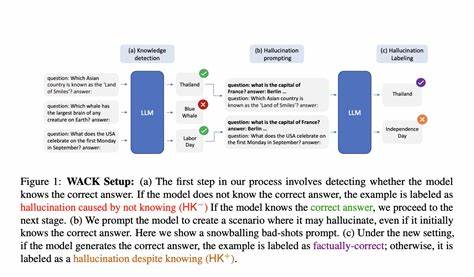

La inteligencia artificial ha transformado radicalmente la manera en que interactuamos con la información a través de modelos de lenguaje que generan texto coherente y relevante. Sin embargo, uno de los desafíos más significativos que enfrentan estas tecnologías es la generación de alucinaciones, entendidas como respuestas incorrectas, inexactas o inventadas por los modelos. Estas alucinaciones pueden perjudicar la confiabilidad y utilidad de las soluciones basadas en inteligencia artificial, especialmente en sectores críticos como la salud, finanzas o derecho. Es aquí donde surge la importancia de contar con un sistema robusto para la detección de alucinaciones que se apoye en conocimientos comunes y contexto específico, mejorando la calidad de las evaluaciones y el desempeño de los modelos de lenguaje. La detección de alucinaciones en modelos de lenguaje ha evolucionado con el desarrollo de HDM-2, un modelo abierto desarrollado por AIMon Labs que utiliza una arquitectura modular y multi-tarea orientada a la validación de la veracidad de las respuestas generadas.

A diferencia de otras herramientas, HDM-2 se distingue por su capacidad para operar con eficiencia en entornos empresariales, ofreciendo una velocidad de respuesta óptima y precisión destacada. Este modelo aprovecha tanto el contexto provisto por el usuario como el conocimiento comúnmente aceptado para evaluar si una afirmación en la respuesta de un modelo es falsa o inexacta. Uno de los principales aportes de este modelo reside en su metodología basada en taxonomías para la validación a nivel de segmentos textuales. Esto permite identificar no solo oraciones completas con probabilidad de ser alucinaciones, sino también palabras y frases individuales mediante un sistema de puntuación probabilística. Esta granularidad en la detección dota a los evaluadores y a sistemas automatizados de mayor capacidad para comprender el origen y naturaleza de los errores, facilitando una mejor corrección y refinamiento del producto final.

Además, esta explicación detallada contribuye a la transparencia y confianza en el uso de esta tecnología. La versatilidad del modelo HDM-2 es otra característica sobresaliente. Se ha diseñado para funcionar con eficacia en distintos dominios tan variados como finanzas, salud, leyes y seguros, reflejando un nivel de generalización que supera muchos de los modelos existentes, los cuales suelen estar limitados a ámbitos específicos o a ciertos tipos de tareas. Esta adaptabilidad abre la puerta a su implementación en una amplia gama de soluciones tecnológicas, ampliando el impacto y el alcance de la detección automática de alucinaciones. El rendimiento demostrado sobre benchmarks reconocidos, como RagTruth y TruthfulQA, así como un nuevo conjunto de datos llamado HDM-Bench creado por el mismo equipo, evidencia que HDM-2 supera significativamente a las alternativas previas en términos de precisión, recall y puntuación F1.

Esto significa que no solo detecta con mayor exactitud las afirmaciones erróneas, sino que también mantiene un equilibrio ideal entre identificar falsos positivos y falsos negativos, lo que es crucial para evitar alertas innecesarias o la omisión de errores. El factor latencia, o tiempo de respuesta, no pasa desapercibido en aplicaciones en tiempo real donde el procesamiento rápido es vital. HDM-2 opera dentro de un límite de 500 milisegundos en una GPU Nvidia L4, posicionándose como una solución viable para agentes conversacionales, asistentes virtuales y otros sistemas inteligentes que requieren evaluaciones inmediatas. Esta capacidad convierte al modelo en un recurso valioso para desarrolladores e instituciones que buscan mejorar la fiabilidad de sus sistemas sin sacrificar rendimiento. Un aspecto innovador adicional es la posibilidad de incorporar conocimiento empresarial específico en la evaluación de las respuestas.

Esto significa que las empresas pueden integrar bases de datos y conocimientos propios que no estén presentes en el contexto general o en el conocimiento común, mejorando la detección de alucinaciones que sean relevantes para su ámbito particular. Esta función, disponible en la versión empresarial del modelo, permite personalizar aún más el proceso y obtener resultados ajustados a necesidades específicas, incluyendo explicaciones detalladas que facilitan la comprensión y revisión de los resultados. HDM-2 también se distingue por su atención al detalle en la diferenciación entre afirmaciones inocuas, declaraciones basadas en conocimiento general y aquellas que constituyen verdaderas alucinaciones. Por ejemplo, en escenarios donde el modelo detecta afirmaciones ampliamente aceptadas y reconocidas, aunque no estén presentes en el contexto suministrado, estas no se marcan como falsas. Al mismo tiempo, frases que incumplen la veracidad y combinan detalles incorrectos son identificadas con altos puntajes de probabilidad de alucinación, evidenciando la precisión de la herramienta.

Para los desarrolladores y usuarios que deseen integrar esta tecnología, el proceso de inicio es sencillo y está pensado para facilitar el acceso a través de la plataforma Hugging Face. Instalando el paquete correspondiente se puede cargar el modelo y aplicar la detección de alucinaciones sobre cualquier respuesta generada por modelos de lenguaje, dentro del contexto definido. Además, se ofrecen funciones para visualizar de manera clara las anotaciones a nivel de palabra, facilitando la interpretación y el análisis detallado de los resultados. Esta accesibilidad basada en código abierto fomenta la adopción y mejora continua de HDM-2, permitiendo que la comunidad técnica contribuya a su perfeccionamiento y adapte la solución a distintos casos de uso, incrementando la robustez y la confiabilidad de los sistemas de inteligencia artificial en general. Al estar bajo una licencia Creative Commons BY-NC-SA 4.

0, se garantiza el respeto por los derechos de los creadores mientras se promueve la colaboración y el desarrollo abierto. El impacto potencial de la detección automática de alucinaciones es inmenso, especialmente en un momento donde los modelos de lenguaje forman parte integral de la generación de contenido, la atención al cliente, el análisis de datos y muchas otras aplicaciones. Al mitigar errores y proveer evaluaciones consistentes, las organizaciones pueden confiar más en las soluciones basadas en IA, mejorar la experiencia del usuario y optimizar procesos críticos sin comprometer la calidad. No obstante, es importante reconocer las limitaciones existentes, tales como la subjetividad potencial en la definición de qué constituye conocimiento común versus conocimiento específico, y la dificultad inherente para identificar algunas alucinaciones sutiles o complejas. Por ello, se recomienda complementar estas herramientas con supervisión humana y una constante revisión para obtener los mejores resultados.

En resumen, la creación y el despliegue de modelos abiertos como HDM-2 marcan un avance significativo en el campo de la inteligencia artificial explicable y confiable. La combinación de conocimiento común, contexto y posibilidad de incorporar información empresarial representa una estrategia integral para enfrentar uno de los principales retos actuales: la detección eficaz de alucinaciones en modelos de lenguaje. Esta innovación no solo mejora la precisión técnica, sino que también impulsa la adopción generalizada de tecnologías responsables y de alto impacto en diferentes sectores y aplicaciones.