En el mundo en constante evolución de la inteligencia artificial y los modelos de lenguaje, la capacidad de interpretar y procesar múltiples modalidades de datos se ha convertido en una necesidad imperativa. Desde imágenes hasta audio, el procesamiento multimodal está redefiniendo cómo interactuamos con las máquinas, facilitando aplicaciones más naturales, precisas y versátiles. Un protagonista destacado en esta revolución es Llama.cpp, una implementación eficiente y accessible del modelo LLaMA, que recientemente ha incorporado soporte para entrada multimodal mediante una integración innovadora con libmtmd. Esta nueva funcionalidad abre un abanico de posibilidades en el ámbito de la inteligencia artificial local y de código abierto, mejorando la forma en que los modelos entienden y responden a estímulos visuales y auditivos.

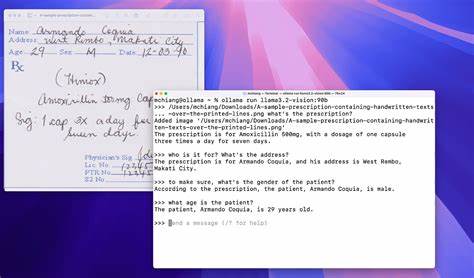

Llama.cpp se ha ganado una reputación sólida por su eficiencia y flexibilidad para ejecutar modelos LLaMA en dispositivos con recursos limitados, como equipos personales sin GPU potentes o incluso smartphones. La incorporación de soporte para visión y audio multiplica su campo de acción más allá del texto, dando paso a aplicaciones multimodales que combinan lenguaje natural con imágenes y sonidos para ofrecer respuestas y análisis mucho más ricos y contextuales. En términos técnicos, la multimodalidad en Llama.cpp se habilita mediante la biblioteca libmtmd, que permite el procesamiento conjunto de texto, audio e imágenes dentro de un mismo flujo de trabajo.

Actualmente, el soporte para audio está en una fase experimental y puede presentar limitaciones en calidad, lo que indica que la tecnología está en desarrollo continuo pero con grandes expectativas a futuro. Por ahora, el enfoque más robusto y demandado está en la integración de imágenes como entrada, lo que fortalece iniciativas como la generación de descripciones detalladas, análisis visuales, reconocimiento de objetos y otras tareas relacionadas. Los usuarios interesados en implementar estas capacidades de visión y audio cuentan con dos herramientas principales para aprovechar el soporte multimodal en Llama.cpp. La primera es llama-mtmd-cli, una interfaz de línea de comandos que facilita la interacción directa con los modelos multinodales, ideal para desarrolladores y entusiastas técnicos.

La segunda es llama-server, que ofrece un servidor compatible con la API OpenAI para chat y completaciones, permitiendo una integración más sencilla en aplicaciones web o sistemas que requieren consultas en tiempo real a modelos multimodales. Para habilitar estas funciones, es posible utilizar modelos pre-quantizados específicos que ya vienen preparados para soportar entradas visuales y auditivas. Estos modelos se pueden cargar con el parámetro -hf seguido del identificador del modelo compatible, por ejemplo, utilizando modelos de la serie Gemma, SmolVLM, Pixtral, Qwen o Mistral, entre otros. Además, si el usuario desea controlar el proceso con mayor precisión, puede emplear opciones como --mmproj para indicar archivos de proyección multimodal personalizados o deshabilitar la proyección multimodal, según las necesidades y el contexto de uso. Una característica destacada de esta integración es que el procesamiento del proyector multimodal está diseñado para ser descargado automáticamente en la GPU para maximizar rendimiento.

No obstante, también existe la opción de desactivar esta descarga mediante --no-mmproj-offload para usuarios que quieran limitar el uso de recursos GPU o estén operando en entornos sin esta capacidad. Los modelos con capacidades de visión disponibles actualmente abarcan desde variantes más ligeras como Gemma 3, SmolVLM y Pixtral 12B, hasta modelos avanzados y con grandes cantidades de parámetros como Qwen 2 y 2.5 VL, InternVL, Llama 4 Scout y otros. Estos modelos suelen estar disponibles en formato GGUF pre-quantizado en la plataforma Huggingface, facilitando la descarga y el despliegue inmediato en diferentes entornos. La inclusión de modelos que abordan audio, aunque es menos madura, también es relevante.

Ultravox 0.5 se presenta como uno de los pocos modelos de audio para Llama.cpp, ofreciendo capacidades iniciales de procesamiento sonoro dentro del ecosistema. En paralelo, los modelos Qwen2-Audio y SeaLLM-Audio se encuentran en desarrollo, aunque aún no disponen de versiones pre-quantizadas debido a los retos actuales en calidad y estabilidad. Más allá de los aspectos técnicos, la capacidad de Llama.

cpp para manejar entradas visuales y auditivas abre nuevas puertas para la creación de aplicaciones multimodales personalizadas en contextos muy diversos. En el mundo empresarial, puede potenciar asistentes virtuales capaces de interpretar imágenes y responder con mayor contexto y precisión. En el sector educativo, abre posibilidad de herramientas interactivas que analicen documentos visuales y respondan con explicaciones en lenguaje natural. En desarrollo de productos, facilita la integración de capacidades inteligentes que combinen texto, audio e imagen para mejorar la experiencia del usuario. Una ventaja adicional de Llama.

cpp radica en su enfoque hacia la privacidad y el control local, permitiendo ejecutar estos modelos multimodales sin necesidad de depender de servicios en la nube. Esto resulta especialmente atractivo para empresas y usuarios conscientes de la confidencialidad y propiedad de sus datos, quienes pueden beneficiarse de las capacidades multimodales sin comprometer la seguridad. El ecosistema de Llama.cpp continúa creciendo en capacidad y comunidad, con una cantidad considerable de pull requests, issues y discusiones que reflejan un desarrollo activo y una amplia participación de usuarios y desarrolladores. La documentación oficial también se mantiene actualizada para facilitar la adopción y experimentación de las nuevas funciones multimodales, con ejemplos claros para implementación tanto en línea de comandos como en entornos de servidor.

Finalmente, esta evolución hacia la multimodalidad dentro de Llama.cpp no solo representa un avance técnico, sino una respuesta a la creciente demanda de sistemas de IA integrados con múltiples formas de datos. La combinación de texto, imágenes y sonido en un único ecosistema localmente manejable posiciona a Llama.cpp como una herramienta estratégica para la próxima generación de aplicaciones de inteligencia artificial, más humanas, interactivas y dinámicas. En conclusión, la llegada del soporte de visión y audio en Llama.

cpp mediante libmtmd y modelos pre-quantizados representa un salto cualitativo en la funcionalidad y alcance de la inteligencia artificial accesible y de código abierto. Su potencial impacto en sectores variados y su filosofía de ejecución local hacen de esta tecnología una propuesta atractiva para quienes buscan crear sistemas inteligentes multimodales potentes, eficientes y flexibles. El futuro de la IA multimodal está aquí y Llama.cpp se sitúa a la vanguardia de esta tendencia, ofreciendo un camino claro hacia soluciones innovadoras y personalizables a nivel global.